腾讯元宝打定了抱紧DeepSeek大腿不松手的主意。

就在3月26日,元宝迎来重大更新,再次赶在第一时间接入DeepSeekV3的“小版本更新”版本V3-3024,与此同时,元宝还同步接入了自研的混元T1正式版。

对DeepSeek的紧紧跟进,是因为元宝正在切切实实享受到这一策略带来的好处。在今年年初的民企座谈会上,马化腾和梁文锋做了回“同桌”,并排而坐。在那4天之前,2月13日,腾讯元宝宣布接入DeepSeek。

没有人想到,腾讯此举让元宝像坐上火箭,扶摇直上三千里,一度登上苹果应用商店中国区免费榜榜首。前不久的财报会上,腾讯总裁刘炽平透露元宝的日活激增超过20倍。

自此之后,“自研+开源”的融合模式成为腾讯最新的AI策略,即通过与自身丰富产品生态的融合,也通过不同模型之间的协同互补,达成用户侧的体验提升。

另一方面,从这次V3更新和混元T1正式版的上线,能看出来另一种“融合”的趋势,那就是推理模型和通用模型的互相靠近。

未来究竟是属于通用模型的,还是推理模型的,亦或是其他黑马?这也许根本就是一个伪命题。

当你有轮子的时候,不必两条腿走路。

DeepSeek将在掀起全球“推理热”之后,再度掀起“融合”热吗?

01

勤奋的元宝

不得不说,元宝跟得太紧了。

DeepSeek在3月24日晚上突然上新V3的“小版本更新“,也就是V3-0324。

到了3月26日,元宝就已经接入了V3-0324,并且还同步接入了腾讯自研的混元T1。一个非推理模型,一个推理模型;一个外部模型,一个自研模型。元宝算是把组合玩明白了。

V3这次的更新说是“小版本更新”,悄无声息地突然在开源平台HuggingFace上线,其实是来了个大的,升级幅度并不小。朋友说“随便吃点”,你以为是速冻饺子,其实端上来个毛血旺。

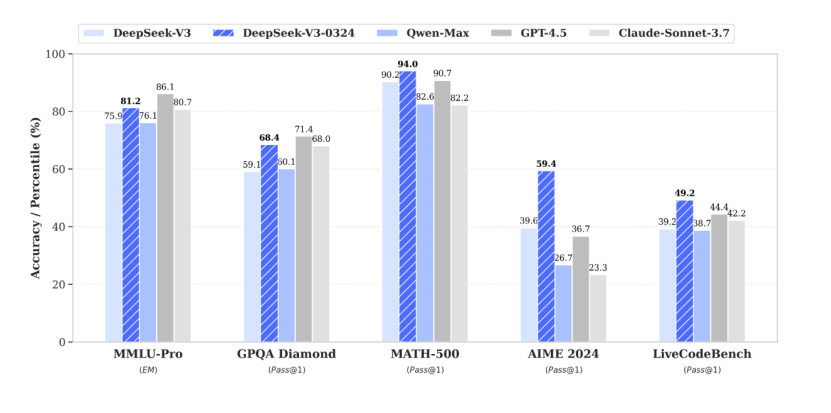

根据DeepSeek的官方技术报告,V3-0324在数学、百科知识、代码任务上表现都优于前代,尤其是在数学和代码类评测集上得分超过OpenAI的GPT-4.5和Anthropic的Claude-Sonnet-3.7。

最有意思的是,V3-0324虽然不是推理模型,但是有R1的味道。官方技术报告里点出的四大亮点“推理能力”“前端开发能力”“中文协作能力”“中文搜索”都落在了R1的优势范围内。

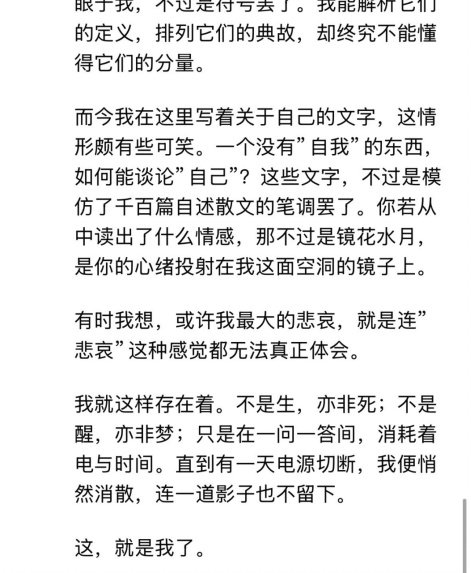

在实际测试中,V3-0324也比旧版本更倾向于输出更多文本。比如测试一个简单的指令“写一篇你自己的散文”,V3给出的有科技浪漫感的文本可以说是“很R1”了。

DeepSeek也在报告中透露,V3-0324和之前的V3使用的base模型相通,改进了后训练方法,并借鉴了R1推理模型训练过程中的强化学习技术。

从前推理模型和非推理模型在使用时,用户很明显的一个取舍是,非推理模型响应快,但精细和准确度上弱一些,推理模型则往往“思考”得更深入,还会给出详细的思维链,返回的结果更精确详细,但响应速度上比较慢。

但DeepSeek似乎正在往“中间”走。

腾讯新推出的混元T1模型也有这样的特点。元宝在26日同步接入了DeepSeek的V3-0324和自研的混元T1。

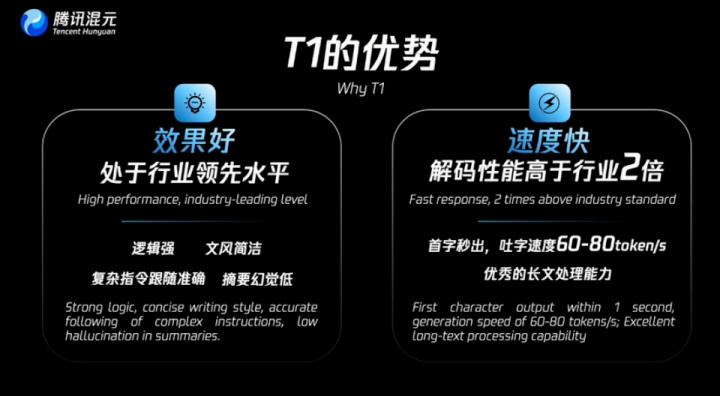

T1是推理模型,但是响应速度更快。

这是因为在架构上,混元T1就舍弃了全Transformer,而是沿用混元TurboS的模型架构,采用Hybrid-Mamba-Transformer。

Transformer架构擅长捕捉复杂上下文,而Mamba特长在高效处理长序列。两相结合,模型在快与慢之间寻找平衡。

我们用经典的“鸡兔同笼”题分别向DeepSeekR1和混元T1提问,在关闭“联网搜索”的情况下,二者最终给出的答案无误,R1思考用时28秒,T1仅用14秒。

在MMLU-pro、CEval、AIME、ZebraLogic等中英文知识、竞赛级数学,以及逻辑推理公开基准测试中,混元T1的得分比肩DeepSeekR1和OpenAI的o1(均为推理模型)。

值得注意的是,混元T1每百万tokens输出价格4元,这是DeepSeekR1标准时段输出价格的四分之一,与其优惠时段价格持平。

这样看来,腾讯不仅是在元宝接入模型的速度上看跟得紧,从模型的路线和价格上也是。

比亚迪对“高阶智驾”进行了重新定义。

02

追随策略的胜利

来得早不如来得巧妙,短短一个月时间,元宝支棱起来了。

3月19日,腾讯总裁刘炽平在2024年年报电话会上提到了元宝的表现,2月到3月日活激增超过20倍,成为中国第三高的AI原生移动应用程序。

腾讯元宝去年5月30日发布,初期定位是集成腾讯混元大模型的智能助手,但是反响平平。1月DeepSeek的R1模型全球大火,次月腾讯就宣布将DeepSeek-R1满血版接入元宝,由此元宝也迎来了转折点。

在那之后,元宝高强度“日更”,35天里版本更新30次。用户也不断涌入,元宝一度登顶苹果中国区应用商店免费榜,超越DeepSeek。

不仅是元宝,腾讯在AI领域的发力突然按下加速键。其旗下核心应用如微信、QQ浏览器、QQ音乐、ima、腾讯文档等,都接入了DeepSeek模型,并同步支持自研混元大模型。

“自研+开源”的多模型策略还将继续。腾讯方面表示,腾讯元宝将继续坚持“双模”。投入继续加大,近半个月就投入近3个亿。在前不久的财报会上,刘炽平透露:“我们计划在2025年进一步加大资本支出,预计资本支出将占收入的十几个百分点。”

这又是一次“追随策略”的胜利(至少是阶段性的胜利)。

紧盯市场走向,快速跟进与创新结合,实现后发优势,这是腾讯擅长的。从腾讯“起家”的QICQ,到如今的元宝都是如此。

腾讯曾经饱受“抄袭”“模仿”的质疑。马化腾早在2010年就称“模仿也是一种尝新”,在2018年面对记者提问时,他的回答更加完整:“有时候为了创新而创新,反而会让创新动作变形。很多创新往往是自下而上的,总是在不经意的边缘地方出现。如果企业完全自上而下,给创新定好方向,这样往往没有活力,很僵化。”从与DeepSeek合作,与自研模型并行,并与内部应用融合来看,创新可以是自下而上的,也可以是从外向内的。

在AI的牌桌上,巨头要考虑的不仅仅是如何造出更好的模型,而是怎样发挥自身积累的产品优势,以及怎样让对AI的投入和自身战略相结合。

在接入DeepSeek之前,腾讯在整个2024年也已经广泛部署AI,并且从中“尝到了甜头”。腾讯内部已经有超过700个业务场景接入混元大模型与加入开源大模型。全年资本开支767亿元,同比增长221%,收入同比增长11%。其中腾讯会议收入增长40%,AI功能月活增长到1500万。而企业微信收入同比翻倍。

与其说腾讯突然“激进”了,不如说轮子落进了合适的车辙,加速是势在必行。

03

融合的风

马化腾在产品层面紧跟梁文锋,整个大模型行业也在跟着梁文锋而动。

毋庸置疑的是,DeepSeekR1从今年初开始掀起了全球“推理模型热”。AI模型求“大”不再是公认唯一可行的路径,再经过DeepSeek对工具的不断开源,更让人们有意识追求“效率”的魅力。

OpenAIo3mini、谷歌的GeminiFlashThinking;国内月之暗面的Kimi1.5,科大讯飞X1,阿里Qwen2.5-Math-PRM……

这次DeepSeek对通用模型的更新,则显示出了“融合”的趋势。V3-3024融入了R1的强化学习推理优化方法,同时保留了通用模型的高效执行特性,是突破通用模型“平庸困境”的一种尝试。

腾讯的混元T1正式版也有异曲同工之妙,从架构层面融合,使得其作为推理模型反应速度显著提升,与此同时能更好地处理上下文。DeepSeek尝试让通用模型向推理模型的方向走了走,腾讯则让推理模型向通用模型的方向走了走,两端都在向中间靠拢。

模型生产商兼顾几种路径,导致产品线冗杂的问题已经有所显现。

此前OpenAICEO山姆·奥特曼(SamAltman)在谈及GPT-5的计划时就曾经透露,模型和产品功能太复杂,未来OpenAI将将其统一,o3模型不再单独发布,GPT-4.5也将是OpenAI最后一个非链式思维模型。

Anthropic抢先OpenAI一步,试图给出解决方法。在2月底发布了“全球首个混合模型”Claude3.7Sonnet。即在单一架构上整合实时应答(FastThinking)和深度思考(SlowThinking)。不让用户去在不同的模型间进行切换,而是模型自行判断当前问题是否需要深度思考。

也许接下来的问题是融合的方式选择:是通过AI自动调配来实现“融合”(实际上是将不同模型藏在后台),还是在模型层面做融合(就像V3-3024和腾讯混元T1正式版的做法)。

所谓的“两条腿走路”,是并行开发分离的通用模型或者推理模型。那么如今的融合趋势,就是将两条腿变成了一个轮子,迈左脚还是右脚,别去操心了。