ArchScale:微软推出的神经架构预训练一站式工具,专注架构设计与规模规律研究,助力大规模语言模型训练与评估。

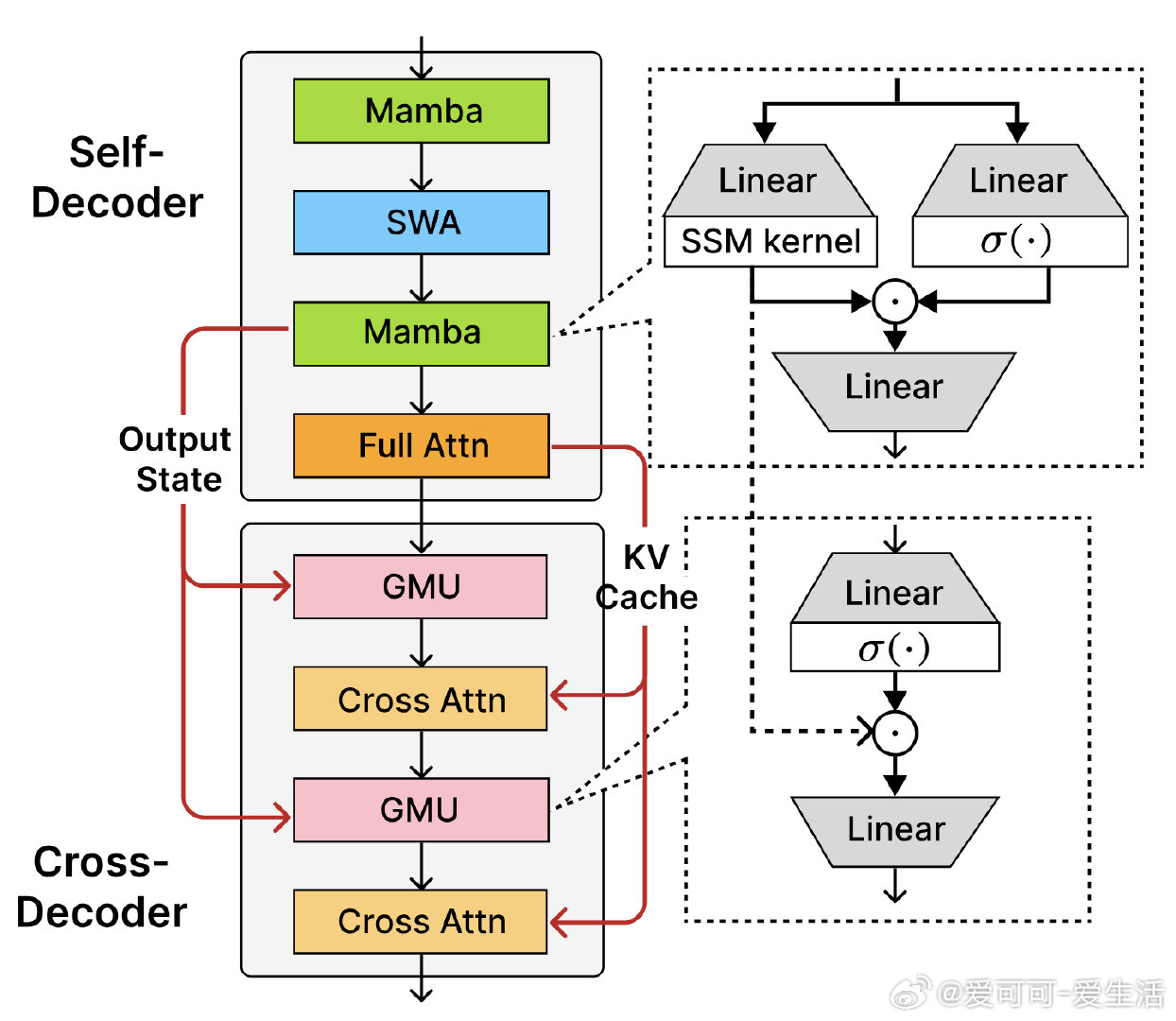

• 多样架构支持:Transformer、SSM、YOCO、差分注意力、Decoder-Hybrid-Decoder等前沿模型。

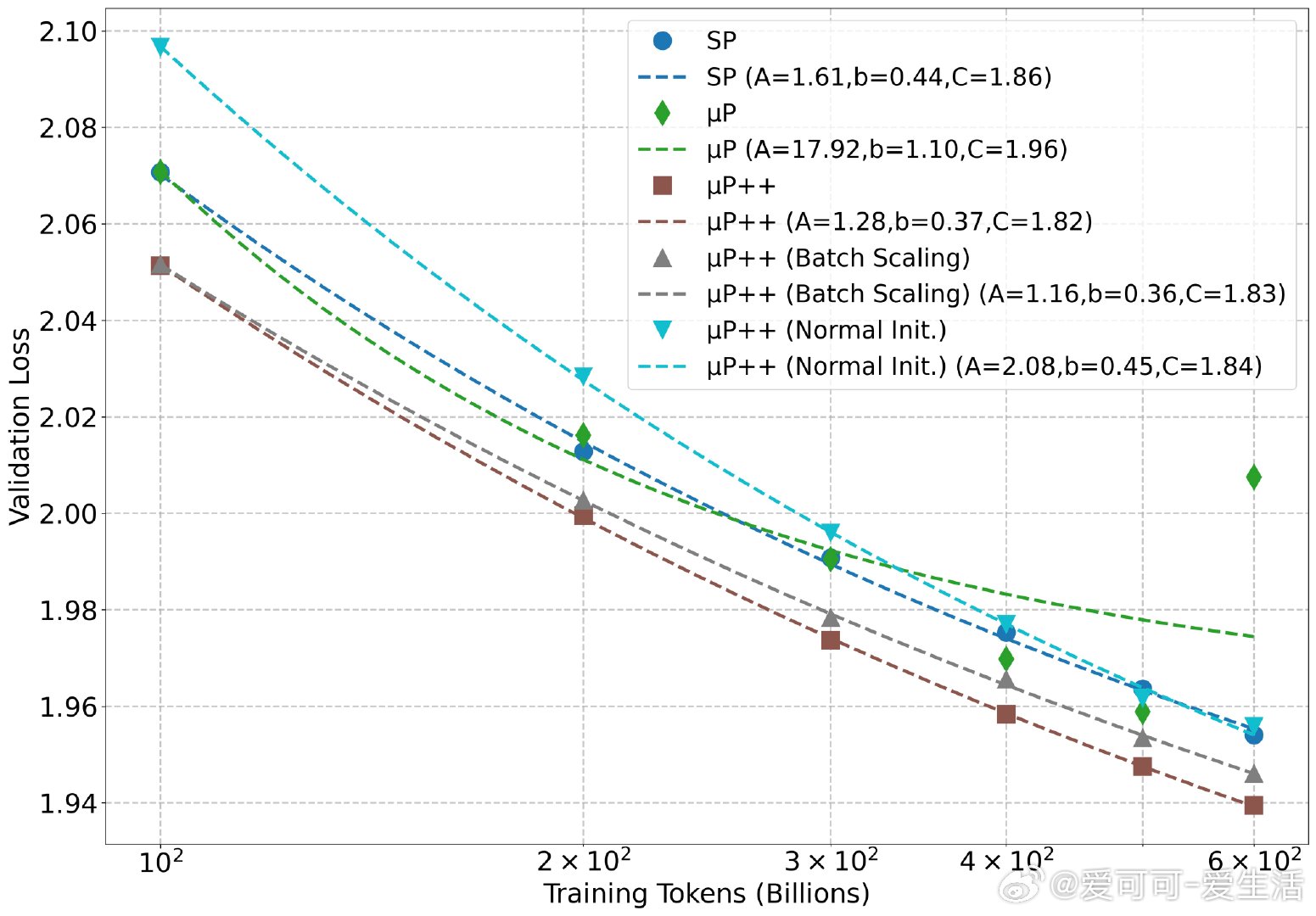

• 规模规律:集成μP++、μP、Chinchilla FLOPs等多种扩展比例定律,支持批量大小、权重衰减等参数实验。

• 优化器丰富:Muon、AdamW、混合优化器,灵活适配不同训练需求。

• 高性能训练:torch.compile加速,Lightning Fabric支持FSDP分布式训练,混合精度及实验性FP8并行。

• 灵活训练设计:支持数据混合、预分词打包、长上下文变长序列训练及大词表稳定训练。

• 全面评估方案:涵盖语言理解基准、长上下文(RULER、Phonebook)、推理任务,配合vLLM多GPU推理。

• 易用与可扩展:Docker环境,模块化代码,方便添加新架构、调度、初始化,实验日志直观。

• 开源MIT许可,社区活跃,支持大规模参数调优及多GPU训练脚本示例。

适合神经网络架构研究、模型预训练及扩展实验的专业平台。

了解详情🔗 github.com/microsoft/ArchScale

深度学习 神经网络 语言模型 预训练 模型架构 AI研究