Qwen新模型直逼Claude4Qwen编程模型33GB本地即可运行

开源编程模型的天花板,要被Qwen3-Coder掀翻了。

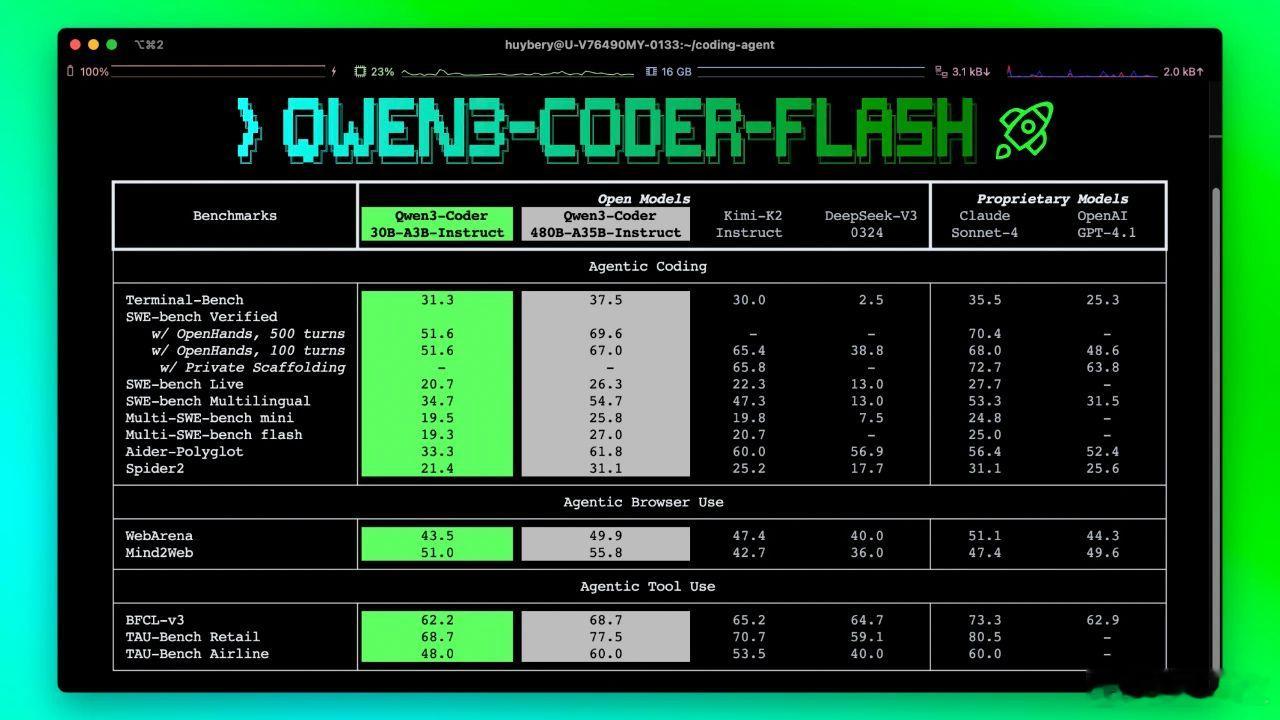

今天凌晨,Qwen3-Coder-Flash也重磅开源!【图1】

“甜品级”的size,但完全“大餐”级的性能。

多编程任务超越顶级开源模型,仅略逊于闭源的Claude Sonnet-4、GPT-4.1等。

原生上下文窗口支持256k token,可延长拓展至1 million token。

33GB内存(即中端笔记本)可运行。

啥概念?

相当于GPT-4.1级别的能力,还能让你本地使用!【图2】

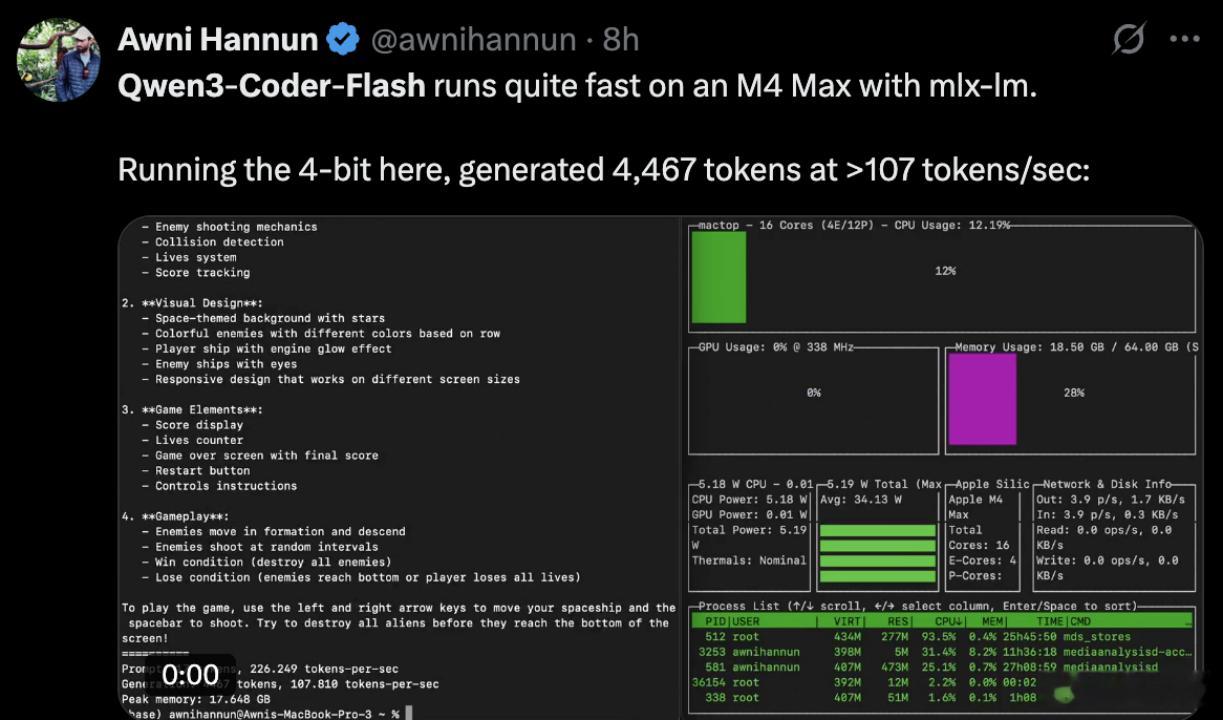

有人实测,在苹果M4 Max上通过mlx-lm运行Qwen3-Coder-Flash,每秒可生成4467个token,相当快。【图3】

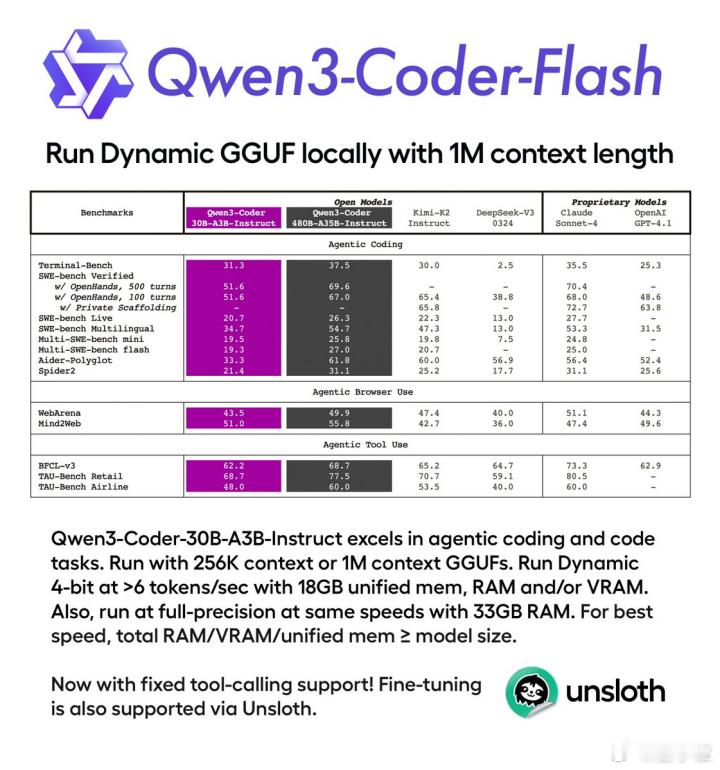

还有人已经火速推出了量化版本,显存不够的童鞋可以来下载使用。【图4】

林俊旸也发推表示,这是一个绿色低碳极速版coding模型。

我想这将是本地编程的最好选择。【图5】

Qwen3-Coder-Flash是Qwen3-Coder的精简版,都是非推理模型。

- 采用MoE架构,30亿参数总量,激活参数3.3亿。

- 原生上下文窗口支持256k token,通过YaRN等可延长至一百万token上下文,适合大型代码库和复杂多文件工程。

- 针对Qwen Code、Cline、Roo Code、Kilo Code等平台进行优化。

- 无缝支持函数调用和agent工作流。

再看Agent方面的能力:

- Agentic Coding(智能体编程)

- Agentic Browser Use(智能体浏览器使用)

- Agentic Tool Use(智能体工具调用)

有博主在M2 Macbook Pro上用量化版Qwen3-Coder-Flash( 24.82GB 6bit MLX版)做的游戏,运行效果很不错。【图6】

而且提示词也很短,就一句话:

Write an HTML and JavaScript page implementing space invaders.

这意味着训练数据中可能存在大量相关或者类似任务,才能让模型一次就能输出非常好的效果。

博主在首次尝试后,感觉飞船发射的子弹太快了,所以想要让它降速一点。

由于他使用的Open WebUI没有类似于Claude Artifacts的工具调用的功能,这意味着模型需要重新输出一个完整结果,实测表明它确实可以做到。

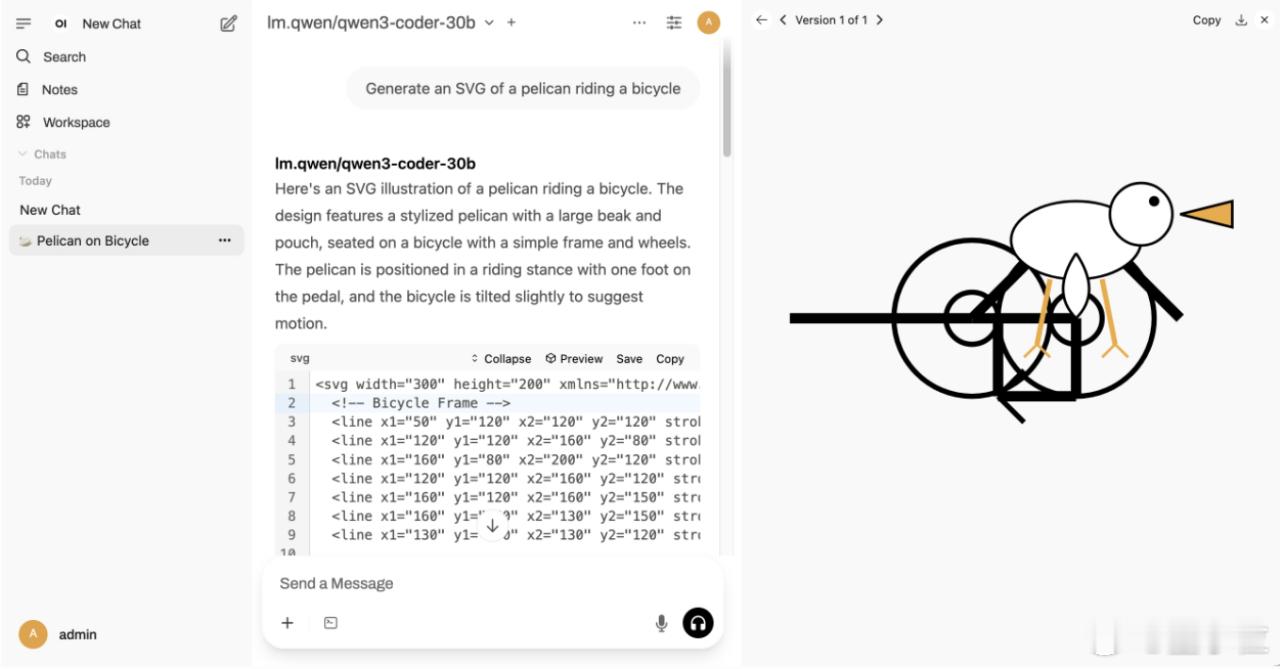

此外他还实测了生成鹈鹕骑自行车,每秒60个tokens,不过效果有点问题。【图7】

但u1s1,最近Qwen的开源节奏实在是太快了,更新模型一箩筐:

- Qwen3-Embedding

- Qwen-Vlo

- Qwen-TTS

- Qwen3-235B-A22B

- Qwen3-Coder

- Qwen-MT

- Qwen3-235B-A22B-Thinking-2507

- Qwen3-30B-A3B-Instruct-2507

……

而且都开源了,还提出了很多小显存友好的方案。

开源之光的title在国产模型这里竞争格外激烈啊(doge)【图8】

最后,Qwen3-Coder-Flash体验方式如下,感兴趣的同学快去体验吧!

QwenChat:chat.qwen.ai

魔搭社区:

HF: