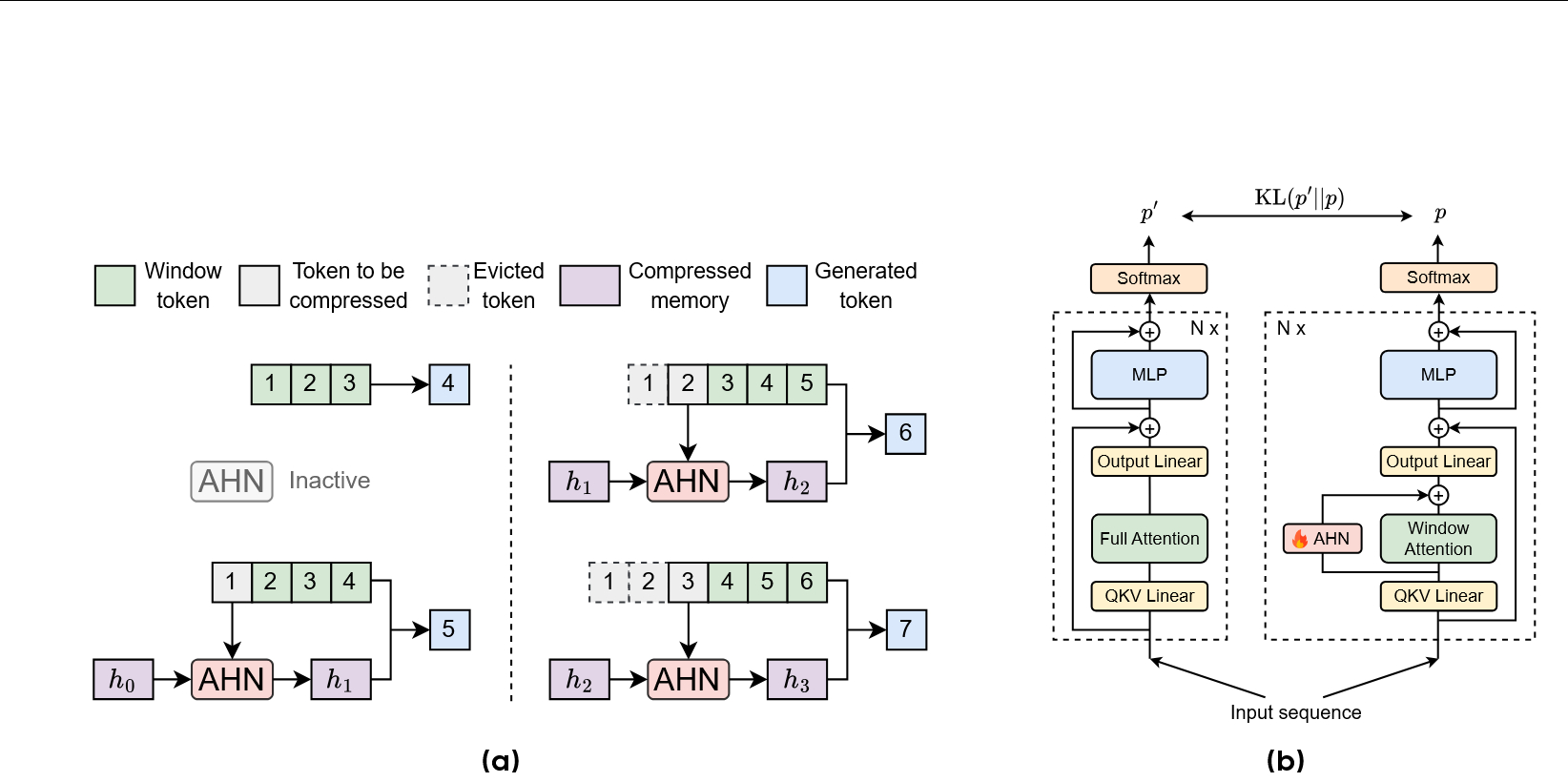

字节跳动刚发布了一篇论文( arxiv.org/pdf/2510.07318 ),介绍了他们的“人工海马体网络”(Artificial Hippocampus Networks, AHNs)的新框架,旨在解决长序列模型中基于注意力机制的无损记忆(高保真但成本高)与类似RNN的压缩记忆(高效但有信息损失)之间的根本矛盾 ,大大减少了大模型长上下文时的计算和内存开销。

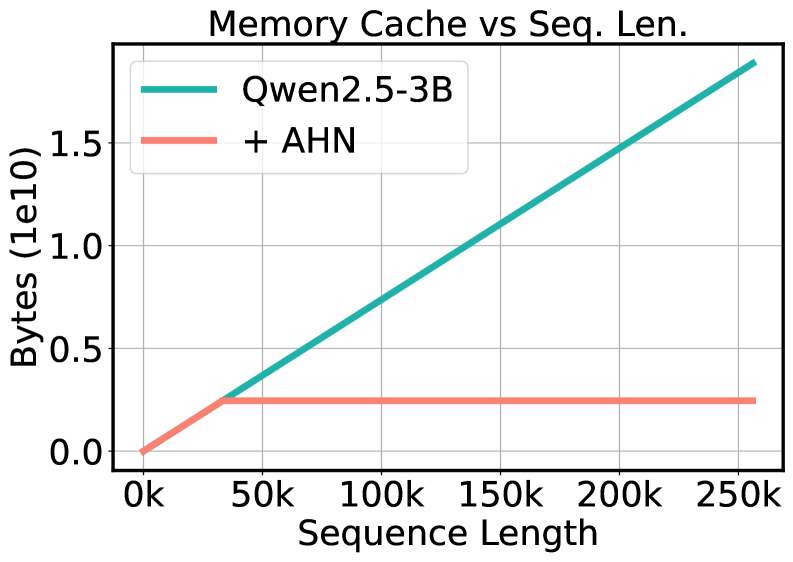

该方法为模型配备了两种记忆:一种是通过滑动窗口注意力机制实现的无损短期记忆,用于精确存储近期信息;另一种是通过AHN模块实现的压缩式长期记忆,该模块能将超出窗口的旧信息循环压缩成一个固定大小的紧凑状态 。实验结果显示,为Qwen2.5-3B模型增加AHN后,在处理128k长度的序列时,其浮点运算次数(FLOPs)减少了40.5%,内存缓存减少了74.0%,而平均分却从4.41提升至5.88 。