斯坦福大学新研究《代理上下文工程》(Agentic Context Engineering,简称ACE)。

这应该是近期 AI 领域内非常重要的研究了,他会改变你觉得 微调 finetuning 比 提示词工程 prompts 高级的认知。

他证明无需任何权重调整,就能让模型变得更聪明。

模型不断地书写、反思和编辑自己的提示词,直到它变成一个自我完善的系统。

你可以理解让模型维护一个不断增长的成功经验日记。每次失败都变成一种策略,每次成功都变成一条规则。

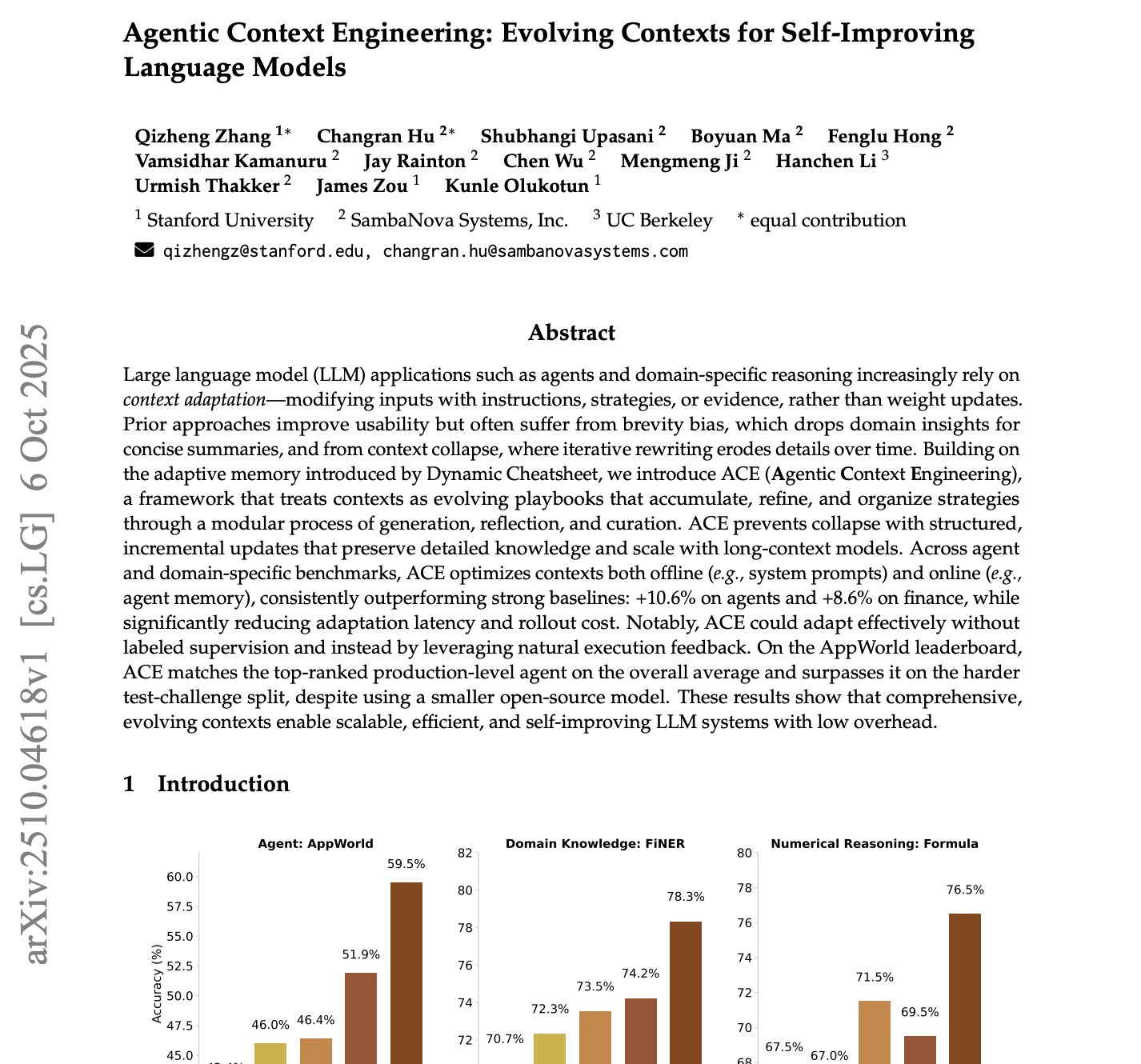

测试结果表明,不需要微调,只需要通过提示词工程:

GPT-4 驱动的代理提升了 10.6%。

在金融推理上,提升了 8.6%。

成本和延迟降低了 86.9%。

这也说明了我们对提示词工程的很多迷思是错的。“简短、清晰”的提示词不是关键。这是人类的习惯。

模型需要的是冗长、详细且不断演变的行动手册,真正提升模型能力的,是 上下文密度。

提示词工程的时代来临。

目前的 fine tuning 在式微。