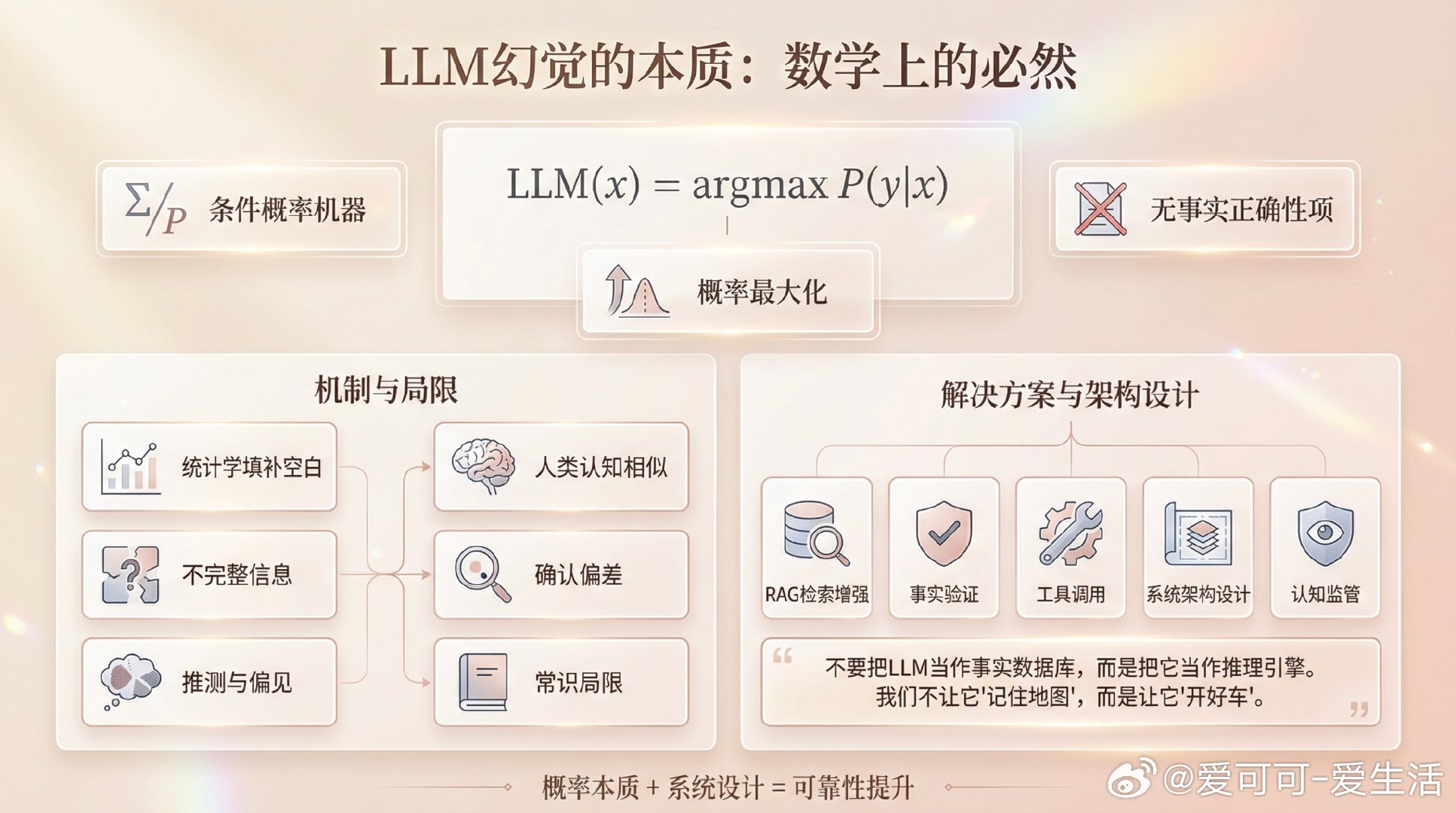

大语言模型(LLM)“幻觉”本质:数学上的必然LLM的核心是条件概率机器,它根据输入和训练数据,选择最可能的下一个词: LLM(x) = argmax P(y|x) 这个公式里,没有“事实正确性”项,只有“概率最大化”。当输入信息不足或模糊,模型只能用统计学填补空白,而非真实世界的确切事实,这就必然导致“幻觉”——生成与现实不符的内容。这是数学上的必然,而非偶发错误。这和人类认知中的误解、迷信、阴谋论其实有相似之处:都是在不完整信息下的推测与偏见。所谓“常识”不过是符合我们个人确认偏差的思维方式。当然,幻觉的“概率”可以被模型设计、训练策略、超参数(如温度、Top-K/Top-P)调节和降低。更重要的是,解决方案不在于“修正模型权重”,而在于构建更复杂的系统架构——比如检索增强生成(RAG)、事实验证、工具调用等,让模型在“统计预测”与“可靠知识”之间划清界限。这意味着: - LLM本身无法保证“绝对真实”,这是其概率本质决定的。 - 但系统层面可以通过架构设计大幅降低幻觉风险。 - 未来AI发展更像是给模型装上“认知监管”和“反馈机制”,让语言生成更贴近事实。“不要把LLM当作事实数据库,而是把它当作推理引擎。我们不让它‘记住地图’,而是让它‘开好车’。”原文:x.com/atulit_gaur/status/1992675311264362695—— 这不仅是技术细节,也是理解AI局限与未来的关键视角。幻觉不是“AI出错”,而是概率论下的必然现象,真正的进步在于如何设计系统让概率推测与真实世界更好地结合。