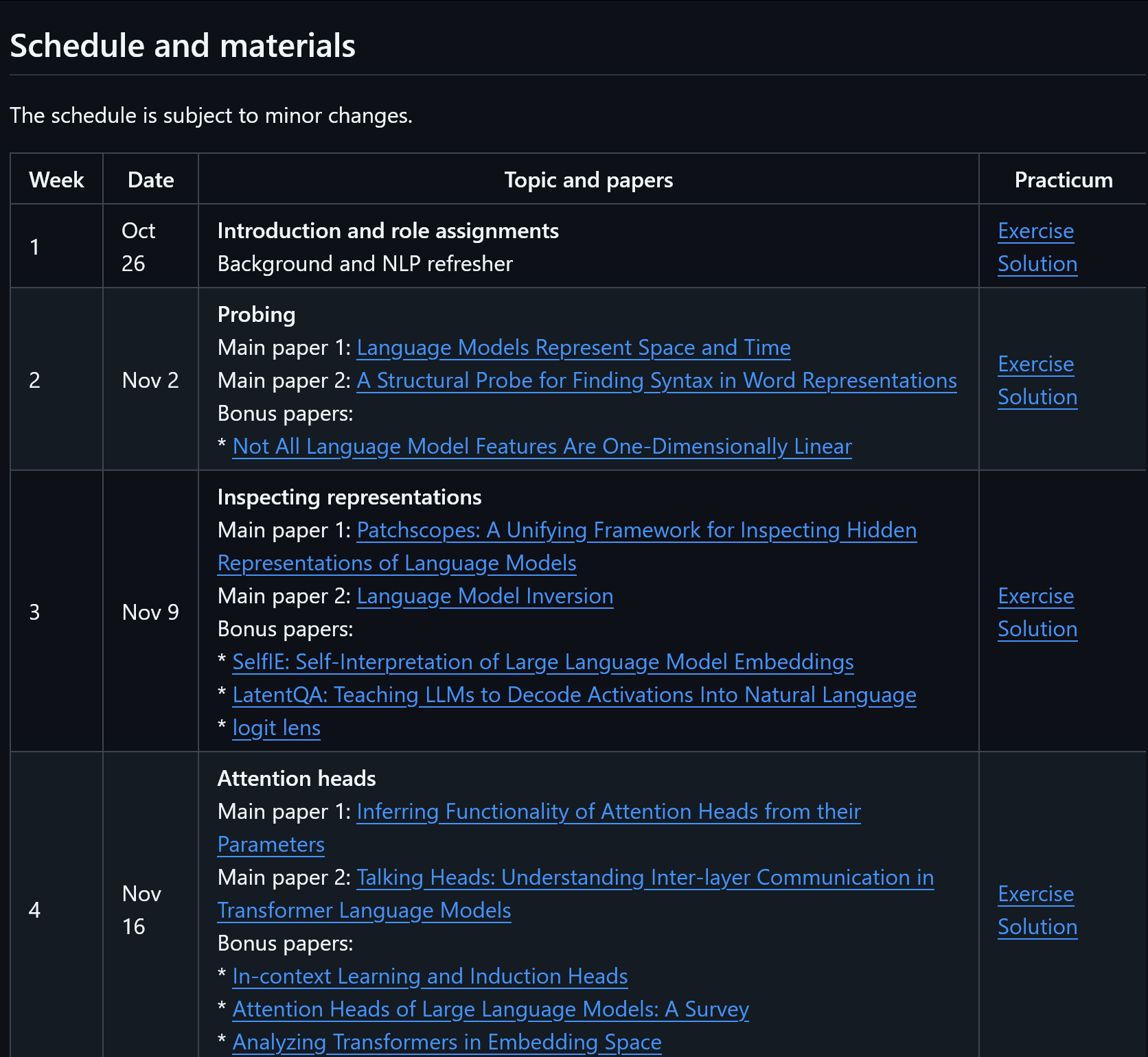

大模型可解释性的课程资料github.com/mega002/llm-interp-tau特拉维夫大学(Tel Aviv University)开设的《大规模语言模型可解释性》(Interpretability of Large Language Models)课程(0368.4264)。这是一个研究生水平的互动式学习课程,旨在通过合作研究小组的方式,让学生深入了解大规模语言模型(LLMs)的可解释性。课程内容包括每周的论文阅读、课堂讨论、角色扮演和实践练习,学生需具备自然语言处理和机器学习的基础知识。课程的主要内容涵盖了语言模型的多个方面,包括表示探测、注意力机制、多层感知器(MLP)层、神经元分析、特征表示、回忆和编辑事实知识等。课程的教学材料由Dr. Mor Geva和Daniela Gottesman设计,并且感谢其他贡献者的支持。通过这门课程,学生将学习如何通过实验、理论和实际练习来分析语言模型的工作原理。科技先锋官AI创造营