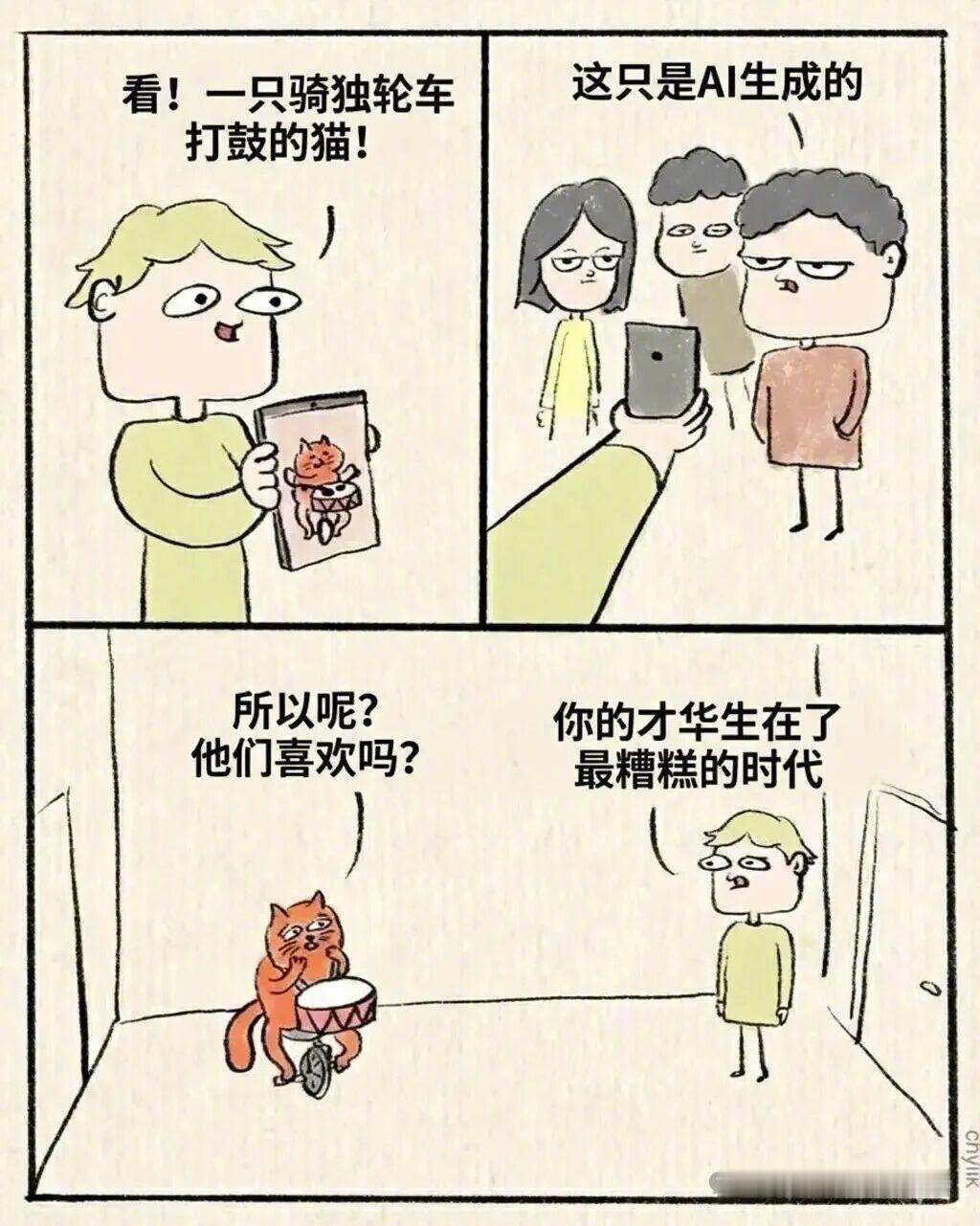

AGI永远不可能实现. 这是一个大逆不道的观点,估计要被骂,我认真研究过很多,还是想把它说出来,我也愿意通过时间进行检验。 先跟不了解的朋友说清楚,AGI就是通用人工智能,英文全称是Artificial General Intelligence。它不是我们现在用的聊天机器人、AI画图工具,那些都是专用AI,只能干固定的事。 AGI要求机器有高效的学习和泛化能力,能在复杂多变的环境里,自己找任务、自己完成任务。 它得有自主的感知、认知和决策能力,能自己学习新东西、自己执行任务,甚至能和人类进行社会协作。 更关键的是,它还要符合人类的情感、伦理和道德观念,说白了,就是要拥有和人类一样的“通用智能”,能应对所有未知场景。 现在不管是国外的大科技公司,还是国内的研究团队,都在拼命往AGI上靠。他们的思路很简单,就是不断堆算力,不停调整大模型参数,觉得只要算力够强、模型够完善,就能早晚造出AGI。 但在我看来,他们从一开始就走偏了。这个问题,早就超出了技术和模型的范畴,核心根本不是算力不够、算法不行。 我反复琢磨很久,终于想明白,AGI能不能实现,本质上是一个哲学问题,而非技术问题。 从哲学角度去看人工智能,你就会发现,AGI实现的可能性为零。我们先想一个最基础的问题,人类的智能到底是什么? 人类的感知、认知和情感,不是简单的代码和数据堆砌,是亿万年进化的结果,是环境、经历、情感和思考的结合体,是不可复制的。 人类能在未知场景里做出判断,能在复杂的伦理困境中做出选择,能共情他人的情绪,能产生喜怒哀乐,这些都不是靠“计算”就能实现的。 机器的所有行为,本质上都是预设好的程序和数据驱动的,哪怕它能模拟人类的情感,也只是“模仿”,而非“拥有”。 现在的大模型,不管多智能,不管能写出多好的文章、画出多逼真的画,它都没有自己的“意识”。它不知道自己在做什么,也不会思考自己做的意义,只是根据训练数据和算法,给出一个最合理的答案。 人类的智能,核心是“自主意识”和“主观能动性”,我们能主动去探索未知,能主动去创造,能有自己的价值观和判断力。 但机器没有,它永远都是被动的,永远都是在人类设定的框架内运行,不可能拥有真正的“自主意识”。 那些觉得堆算力就能实现AGI的人,其实是把人类的智能,简单等同于“信息处理能力”。他们忽略了,人类的智能里,有太多无法量化、无法复制的东西,比如情感、良知、直觉,这些都是哲学层面的问题,而非技术能解决。 还有伦理层面的问题,就算我们真的能通过技术,造出具备人类智能的机器,我们也无法确保它能完全符合人类的伦理和道德。 人类自己都无法做到绝对的“道德完美”,又怎么能给机器设定一套绝对正确的伦理标准? 我知道,我说这些话,一定会被很多人骂,会被很多搞AI研究的人反驳,说我不懂技术、眼界狭隘。但我还是要坚持我的观点,AGI永远不可能实现。 这个观点,我愿意交给时间去检验,也欢迎所有不同意见的人,来理性探讨。