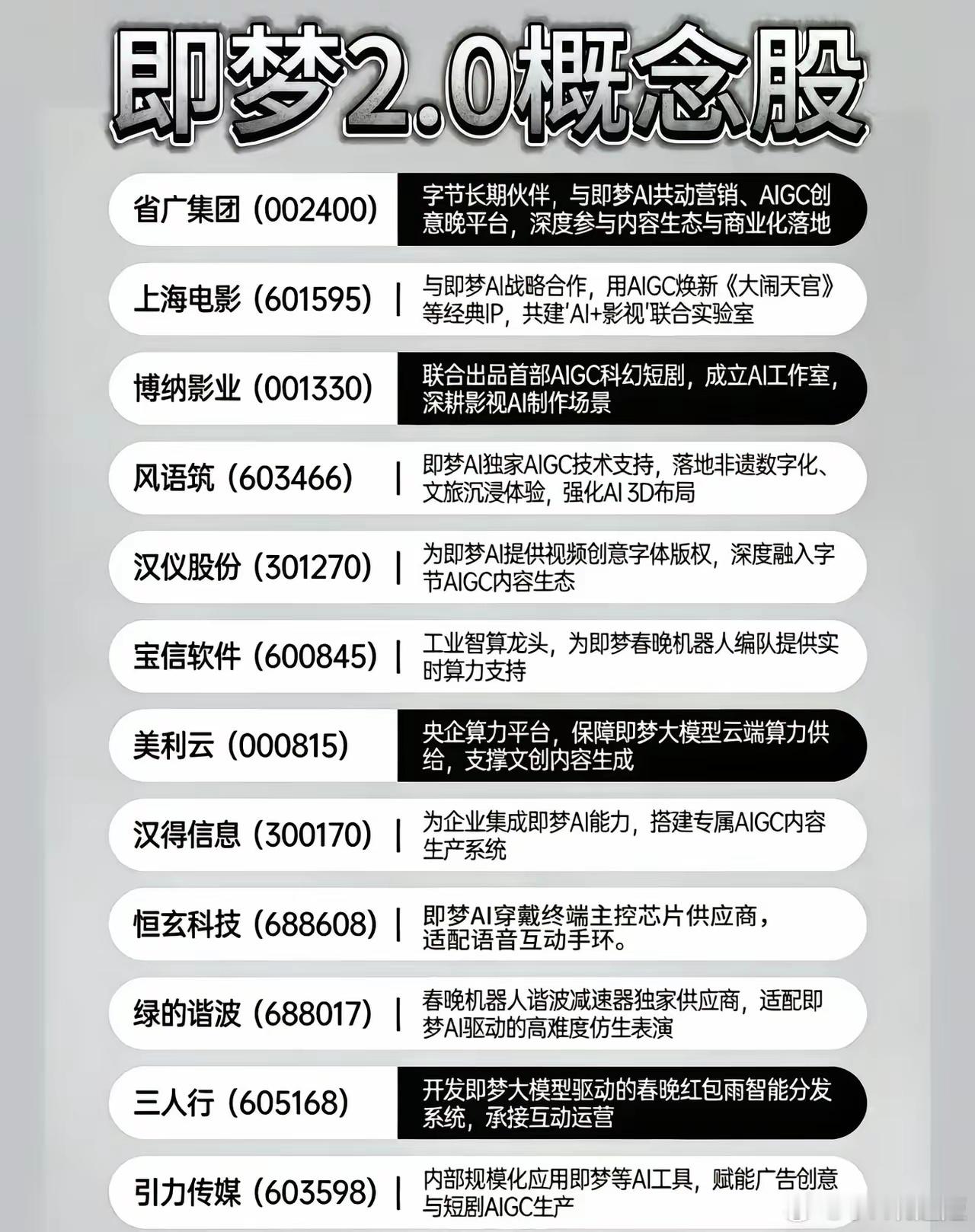

刚跟一个刚从某大厂AI Lab出来的朋友喝咖啡,聊起最近刷屏的Seedance 2.0,他嘬了一口美式,略带调侃地说:“这下好了,字节这回直接把‘分镜脚本’和‘后期剪辑’的活儿,打包塞给AI了。” 他接着解释,这玩意儿最唬人的不是什么60秒出片,而是那个“多镜头叙事”。说白了,你给一段描述,比如“一个侦探在雨夜调查咖啡馆”,它吐出来的不是一张图或一段固定镜头,而是一整套自带起承转合的多镜头序列——从侦探推门特写,到环视店内的主观镜头,再到发现关键线索的俯拍,甚至雨声和背景音乐都给你配好了。“这已经不是简单的视频生成了,这是在用算法模拟导演的蒙太奇思维,自动帮你把故事板可视化。”他说道。 这让我想起影视飓风在评测里提到的,它的运镜“有明确的角度切换”,像真人导演一样不断变换机位。朋友点点头:“对,这就是关键。以前的模型拼的是画面有多真、动作有多顺,现在赛道卷到‘叙事连贯性’和‘导演级控制’上了。你可以把它想象成一个高度智能的‘影像仪表盘’,你想调节奏、换视角、控制情绪氛围,可能未来就是调几个参数的事。” “仪表盘”这个词很妙。正如东方证券所说,视频生成正进入精准可控的“仪表盘时代”。门槛一降,从前端的内容创作者到后端的短剧制作方,玩法就多了。朋友压低了点声音:“所以你看券商的报告,都在盯着AI短剧、漫剧这块。逻辑很简单,这套东西如果能稳定产出情节连贯、镜头语言合格的短片,对那种需要海量测试剧本和镜头的短剧行业来说,就是核动力级别的降本增效器。” 当然,赛道里不止一个玩家。快手的可灵强在“运动控制”,Sora追求极致的物理真实感。而Seedance 2.0,按他们自己的说法,是专注在“带原生音频的连贯多场景”。朋友总结道:“这就好比大家都能造车了,但现在开始比拼谁的车机系统更智能、谁的自动驾驶场景更连贯。下一个差异点,可能就看谁先在一个具体的应用场景里,比如广告、教育、社交,把这种‘导演能力’用得最透,形成闭环。” 聊到最后,他感慨了一句:“现在再看网上那些标榜‘电影感’的AI短片,我第一反应不是惊叹,而是下意识地琢磨,它这组分镜是预设的模板,还是AI根据语义真正‘理解’后编排的。感觉自己的观赏体验,都快被训练成‘技术审视模式’了。” 你们最近有被哪款AI视频的“叙事感”惊艳到吗?