Meta超级智能实验室首篇论文Meta给所有大模型提速30倍

小扎下血本组建的超级智能实验室,带来了他们的首篇研究成果。

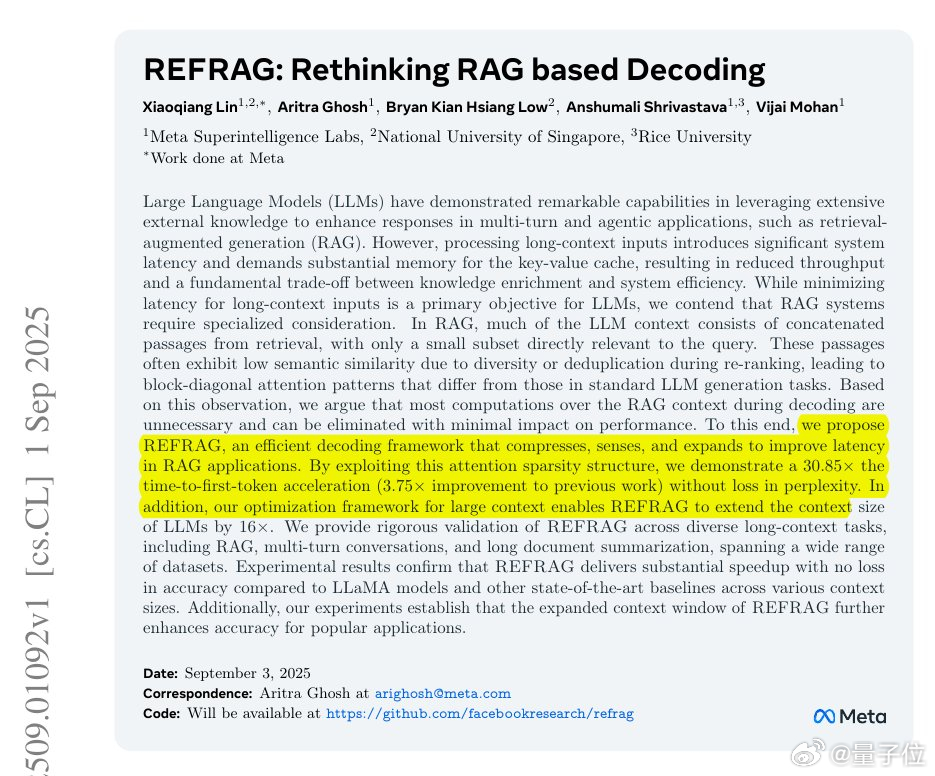

这个开门红,可谓是给所有大模型开外挂:能在不重训练的情况下,让任意大模型的回答速度提高30倍,上下文的处理长度还扩展16倍!

众所周知,由于Transformer的注意力机制,上下文一旦变长,模型推理速度就会指数级变慢。

而Meta这次提出的REFRAG,通过“先压缩,再按需还原”的方式,过滤掉了长上下文中的冗余信息,从而让模型只看有用信息。

具体来说,REFRAG的步骤是:

- 压缩:先用一个小型encoder,把检索来的长文本切块,每16个token压缩成一个chunk embedding,提前抓取语义信息;

- 缩短:主模型接收的已不是原始token序列,而是大幅缩短后的embedding序列,注意力计算和KV缓存负担都显著减轻;

- 选择性展开:为了保证精度,引入强化学习策略,让模型判断哪些chunk需要恢复成原始token,避免关键信息丢失;

由于输入更短,推理速度大幅提升,实测首字节延迟(TTFT)最高加速30.85倍,同时上下文处理能力扩展到16倍。

实验表现同样亮眼:

- 在RAG场景下,REFRAG在相同延迟下比LLaMA模型准确率更高,特别是在弱检索条件下更稳定(因为能跳过无关段落);

- 在GSM8K数学推理任务中,REFRAG把准确率从6.71提高到12.08,几乎翻倍;

- 在BoolQ、StrategyQA等数据集上也保持了较好平衡,证明它既能看得多,又能答得准。

重要的是,REFRAG不需要改造底层架构,和现有的LLaMA等解码器模型兼容,属于可直接插拔的优化框架。这意味着开发者可以在不换模型的前提下,获得更快的响应和更大的上下文容量。

论文链接: