【月之暗面推出全新注意力架构Kimi Linear】10月31日消息,月之暗面今日推出了一个非常牛的全新的注意力架构Kimi Linear,有望成为下一代Agent LLM的基石技术。月之暗面已经放出了技术报告《KIMI LINEAR:一种高表达力且高效的注意力结构》并开源了核心代码。

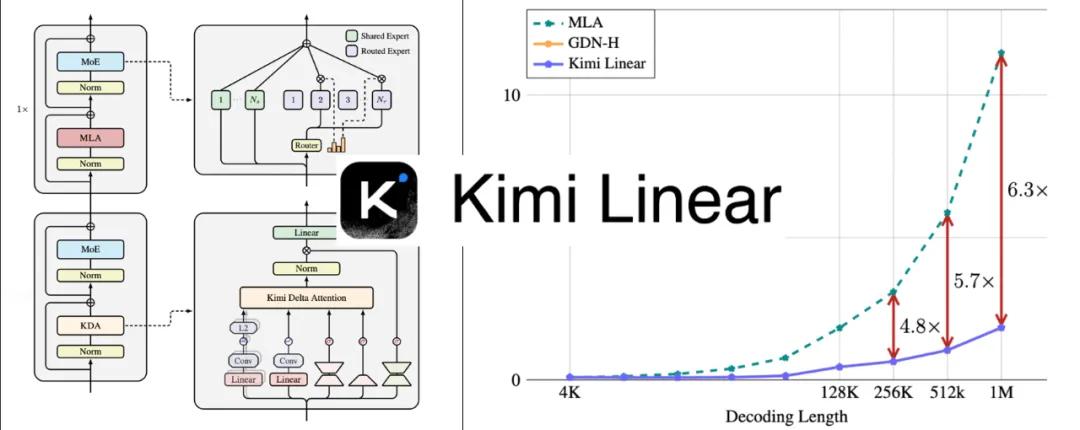

Kimi Linear架构的核心是Kimi Delta Attention (KDA),一种表达能力更强的线性注意力模块,通过更精细的门控机制实现了对循环神经网络有限状态记忆的有效利用。

最终,Kimi Linear模型不仅在各项任务上取得了更优异的性能,还在效率上实现了巨大突破:与full attention模型相比,能将Key-Value (KV) 缓存的使用量减少高达75%,并在处理百万级别的长下文时,实现高达6倍的解码吞吐量提升。这表明Kimi Linear可以作为全注意力架构的“即插即用”替代品,在提升性能的同时显著增强了效率。