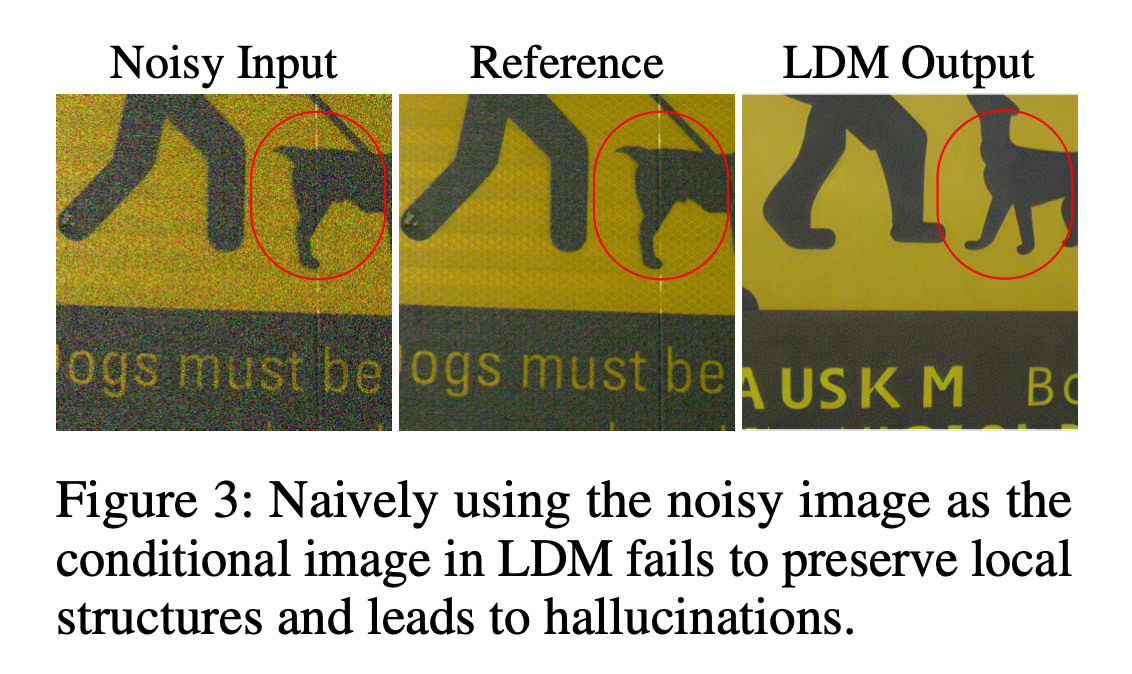

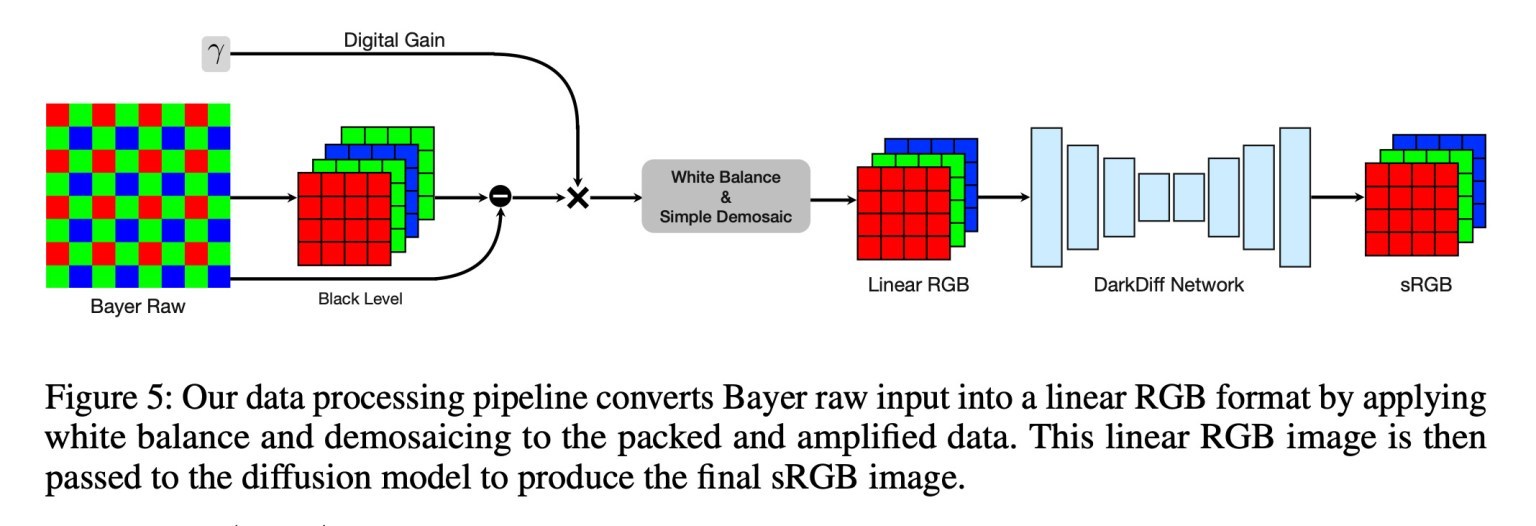

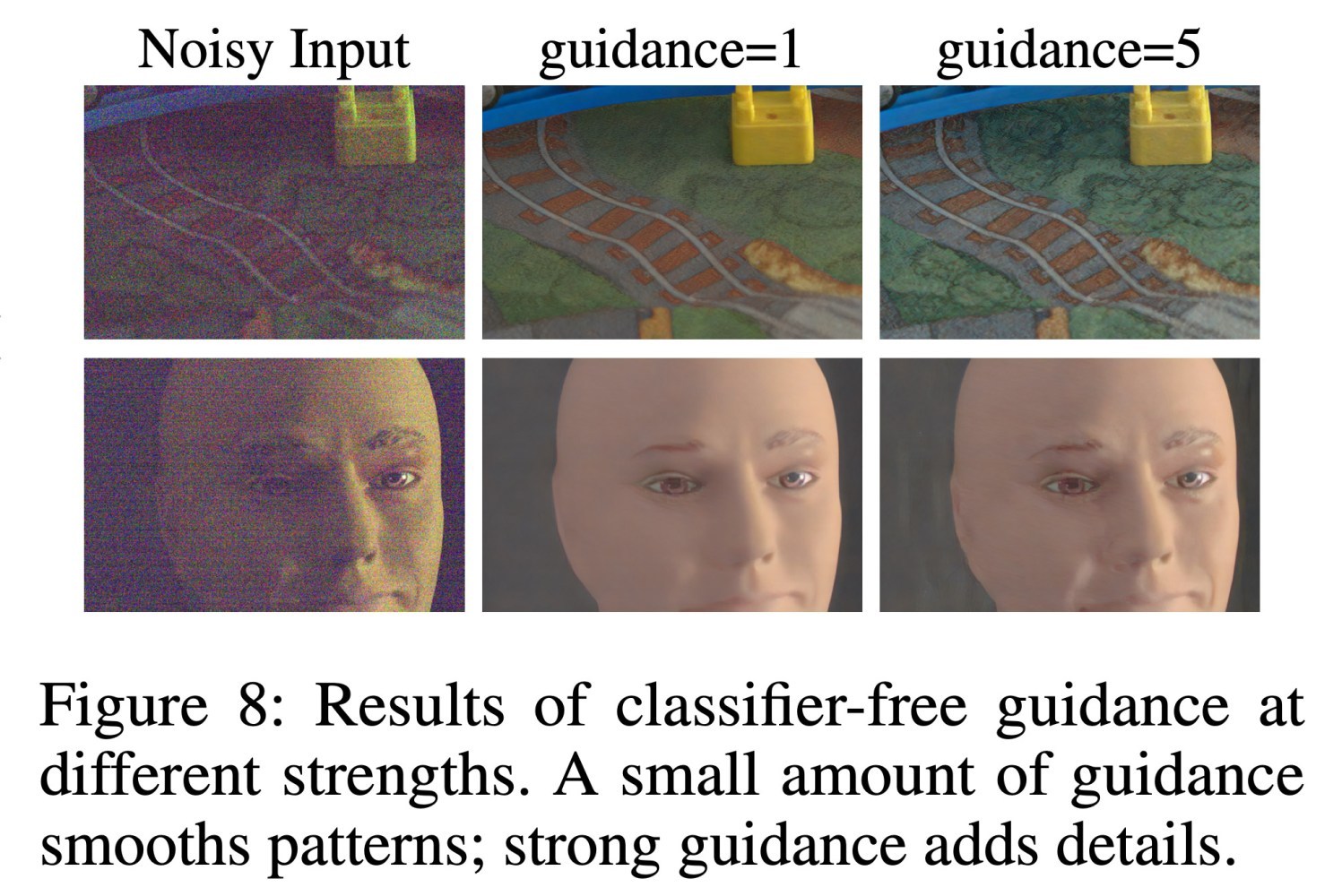

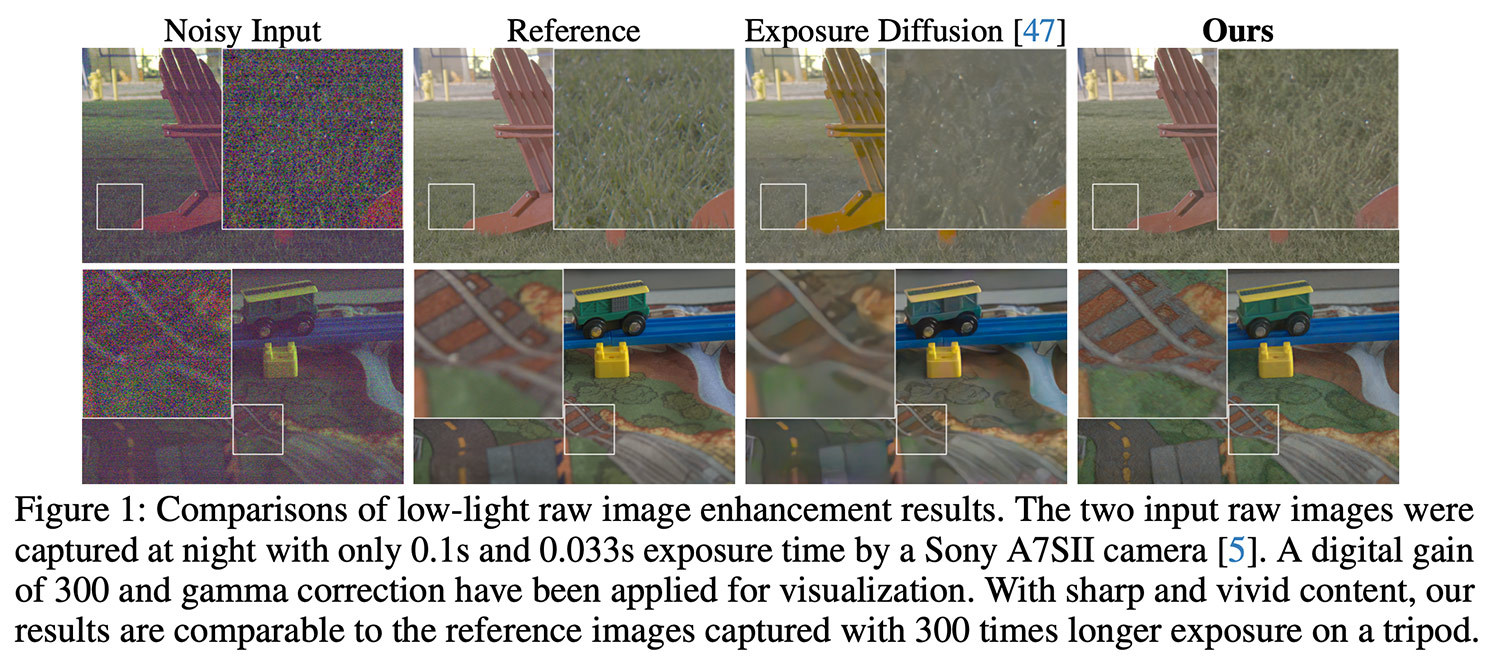

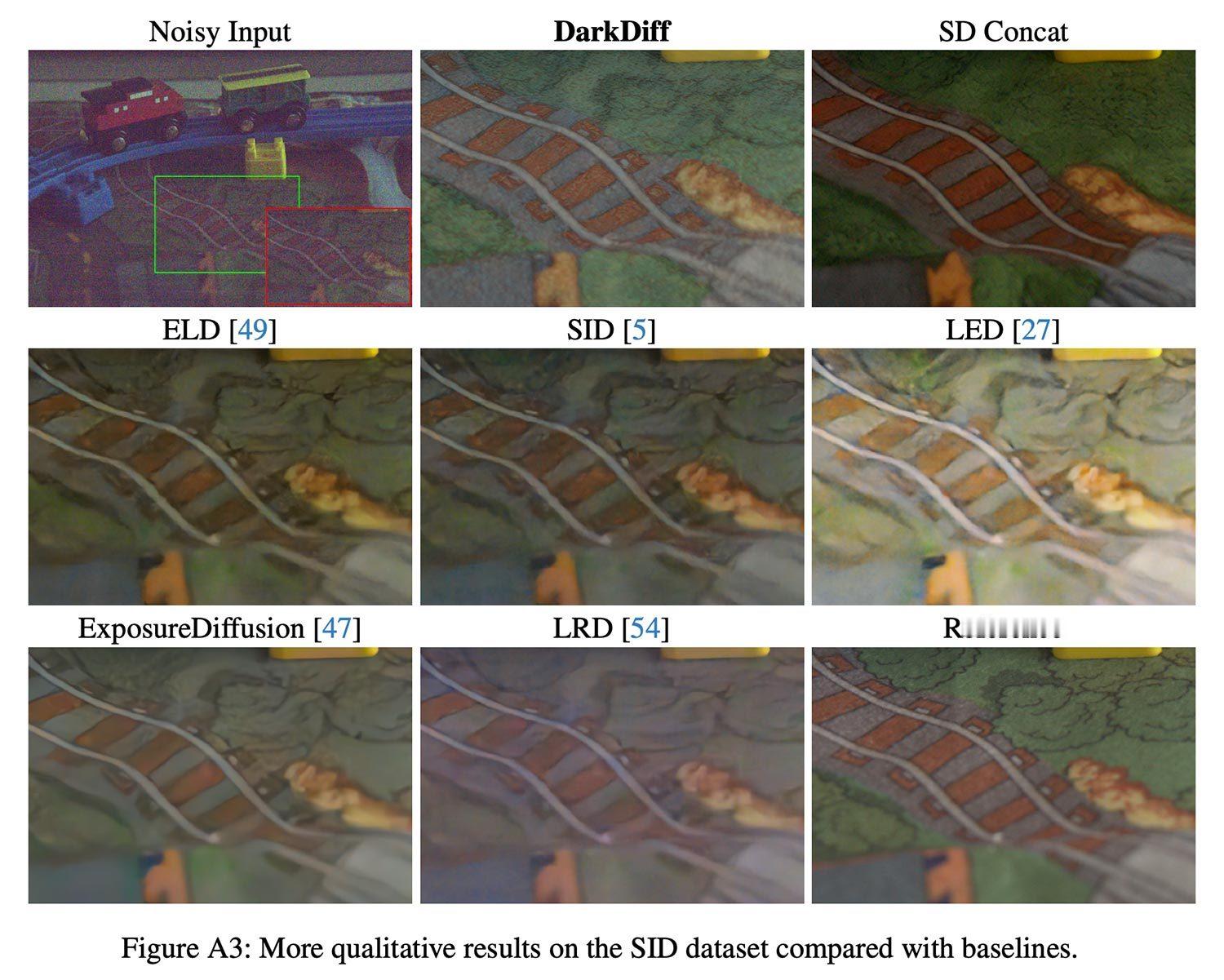

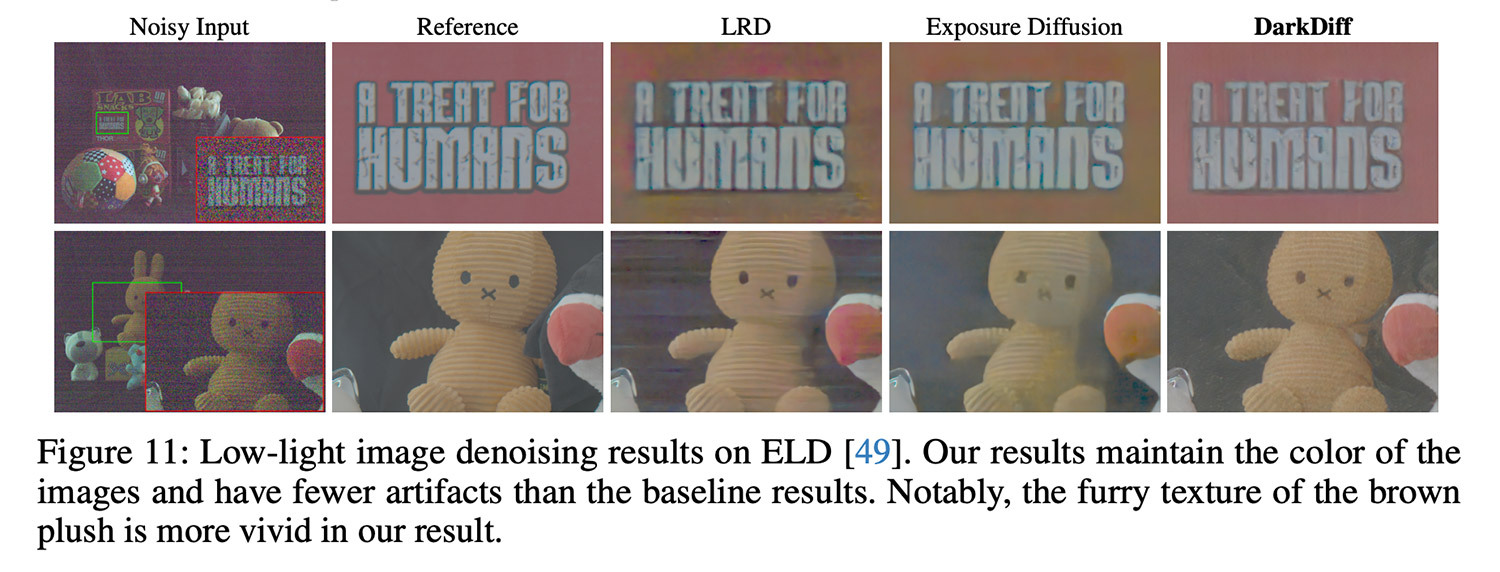

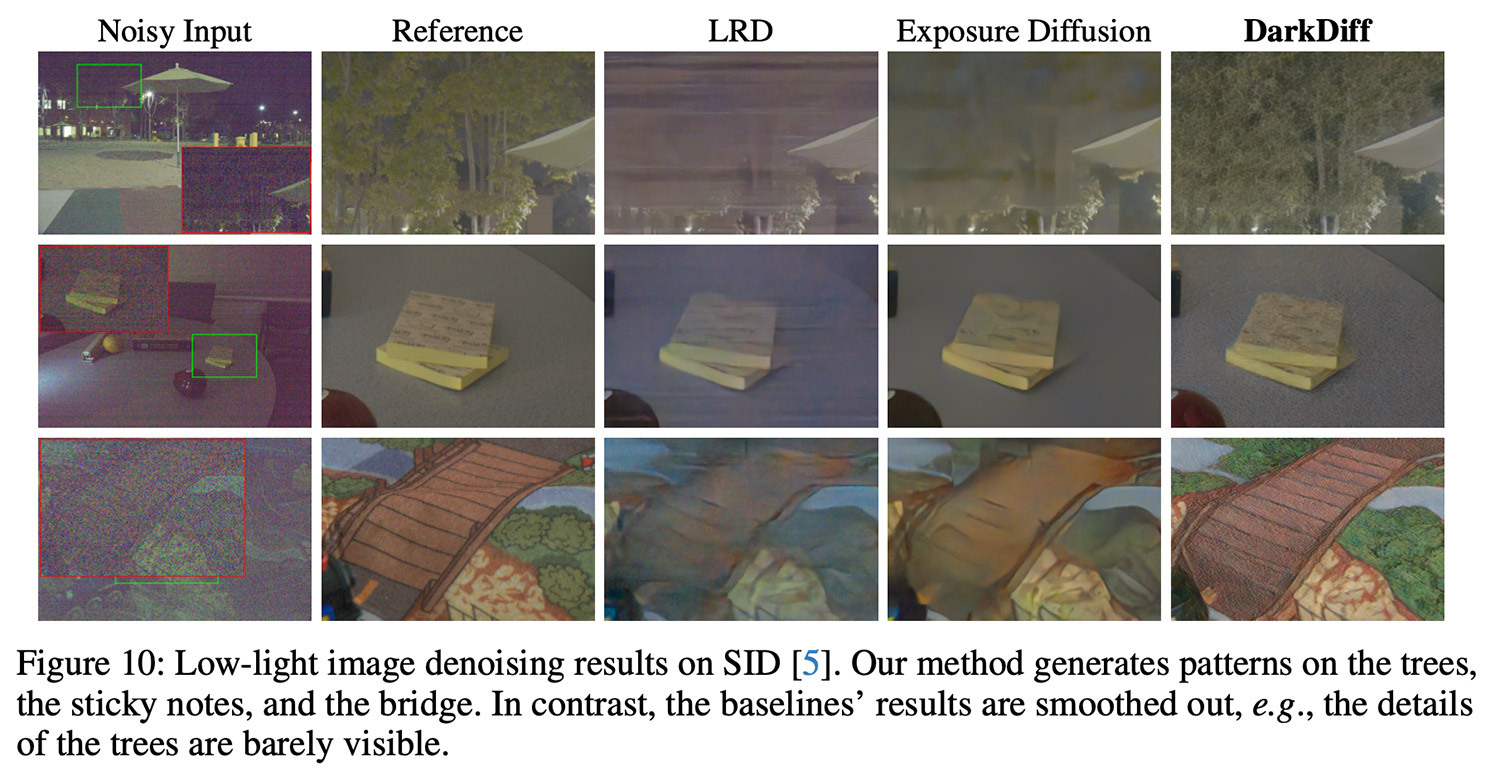

【Apple 的一项研究表明,AI 驱动的 ISP 可以显著提升 iPhone 在弱光环境下的拍照效果】Apple 研究人员开发了一种 AI 模型,它通过将基于扩散的图像模型直接集成到相机的图像处理流程中,显著改善了极暗环境下的照片质量,使其能够从通常会丢失的原始传感器数据中恢复细节。你可能在极暗的环境下拍摄过照片,结果得到的照片充满了颗粒感和数字噪点。为了解决该问题,Apple 与 Purdue University 的研究人员开发了一种名为 DarkDiff 的模型。他们在标题为《DarkDiff: Advancing Low-Light Raw Enhancement by Retasking Diffusion Models for Camera ISP》中描述:在极低光照条件下拍摄高质量照片对数码相机而言极具挑战性,但也意义重大。随着计算硬件的进步,传统的相机图像信号处理器(ISP)算法正逐渐被高效的深度网络所取代,后者能够更智能地增强噪声较大的原始图像。然而,现有的基于回归的模型通常会最小化像素误差,导致低光照照片或深阴影过度平滑。近期的研究尝试通过从头开始训练扩散模型来解决这一局限性,但这些模型在恢复清晰的图像细节和准确色彩方面仍然面临挑战。我们提出了一种新的框架,通过将预训练的生成式扩散模型与相机 ISP 结合使用,来增强低光照原始图像。大量的实验表明,在三个具有挑战性的低光照原始图像基准测试中,我们的方法在感知质量方面优于现有技术。他们没有在后期处理阶段应用 AI,而是重新利用稳定扩散(一个基于数百万张图像训练的开源模型)来理解照片暗部区域在整体背景下应该存在哪些细节,并将其集成到图像信号处理流程中。研究团队的方法提供了一种机制,可以计算局部图像块的注意力,这有助于保留局部结构并减轻如下图所示的幻觉,在图1中,重建 AI 完全改变了图像内容。采用该方法,相机的图像信号处理器(ISP)仍然负责处理理解原始传感器数据所需的早期处理步骤,包括白平衡和去马赛克等。DarkDiff 处理生成的线性 RGB 图像,对其进行降噪并直接生成最终的 sRGB 图像。DarkDiff 还使用了一种无分类器引导的标准扩散技术,它主要控制模型应该多大程度地跟随输入图像,而不是跟随它学习到的视觉先验。指导较少时,模型会生成更平滑的图案;而指导增加时,模型会生成更清晰的纹理和更精细的细节(这增加了产生不必要的瑕疵或幻觉内容的风险)。为了测试 DarkDiff,研究人员使用了索尼 A7SII 等相机在极低光照条件下拍摄的真实照片,并将结果与其他原始增强模型和基于扩散的基线(包括 ExposureDiffusion)进行了比较。测试图像在夜间拍摄,曝光时间最短为 0.033 秒,并将 DarkDiff 的增强版本与使用三脚架以 300 倍曝光时间拍摄的参考照片进行了比较。研究人员指出,他们基于 AI 的处理速度明显慢于传统方法,而且可能需要云端处理来弥补高计算需求,否则在手机本地运行会快速耗尽电池电量。此外,他们还指出,在弱光环境下,该方法在识别非英语文本方面存在局限性。该研究并未通过 DarkDiff 功能在近期内应用于 iPhone。不过,这项研究表明 Apple 持续致力于计算摄影技术的进步。近年来,随着消费者对摄像头功能的需求超出公司在设备内部物理空间所能容纳的范围,这已成为整个智能手机市场中一个越来越重要的关注领域。