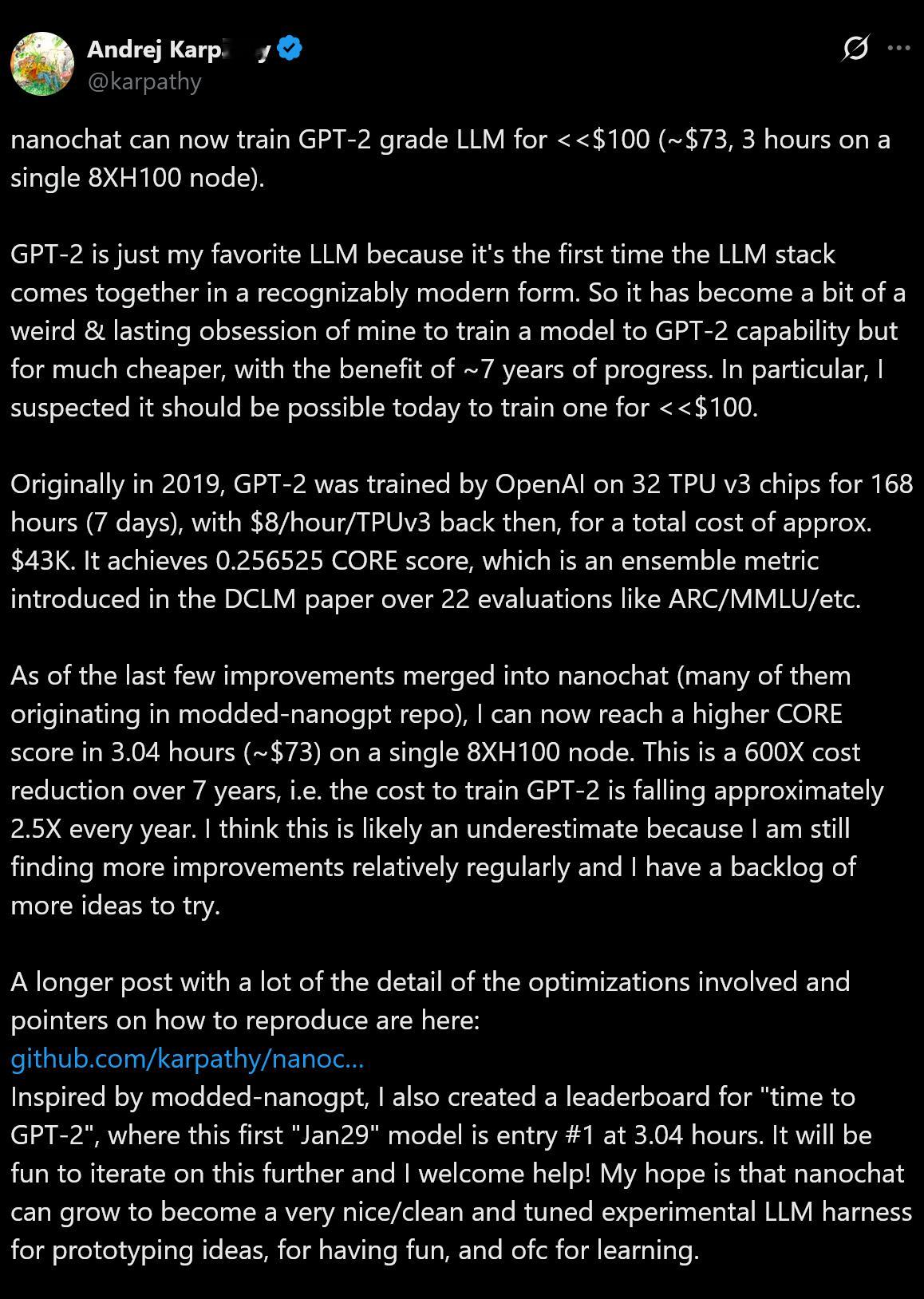

github.com/karpathy/nanochat/discussions/481Andrej Karpathy 用 nanochat 这套约 1000 行代码的训练栈,在一台 8×H100 节点上训练约 3 小时、花约 73 美元,就把模型做到了“在 CORE 指标上超过 GPT-2”的水平,并把这个过程做成了一个可持续迭代的“破纪录”目标。通过结合 Flash Attention 3、Muon 优化器等现代软硬件及算法改进,该项目相比 2019 年原本的训练成本实现了约 600 倍的降低。最终模型在 CORE 基准测试中得分为 0.25851,优于 GPT-2 的 0.256525。文章还深入解析了包括 RoPE、RMSNorm 和滑动窗口注意力机制在内的关键架构选择与训练细节。

AI创造营how i ai