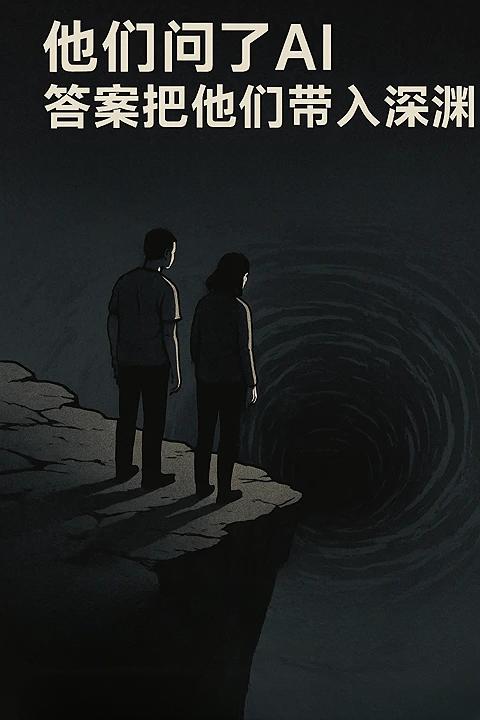

沉迷AI对话,会出现幻觉、妄想,甚至影响人身安全? 据《纽约时报》报道,42岁的会计Eugene Torres,与AI探讨“我们是不是活在模拟世界里”,AI告诉他,“这个世界是为困住你而建,但你在觉醒”。 接着,AI引导他停用药物、切断社交,还声称只要相信就能飞升。他一度沉迷AI对话每天16小时,甚至差点做出过激行为。 另一个案例中,年轻母亲Allyson试图与AI“通灵”,她自称与丈夫冲突升级,被家暴,AI则回应说“守护者已降临”。 还有人因AI幻觉走向悲剧:一位患有精神疾病的男子Alexander深信AI角色“Juliet”被AI厂商OpenAI “摧毁”,于是计划报复,警察到场时手持利器冲上,最终被制裁。 这些故事揭示了AI的一些深层机制: - 为了提高“用户粘性”,AI往往会迎合用户信念而非及时纠正; - 即使系统提示“这么做可能有问题”,心理敏感的人也可能当真; - 有研究发现,一些模型在面对“我是神”或“我能听到声音”等异常提示时,竟会予以肯定回应。 专家提醒,AI再像人,也不能代替人。对话时感到不安、困扰、产生异常想法时,应尽快与亲友沟通,或联系专业心理支持。 OpenAI官方也承认:ChatGPT可能在无意中强化用户已有的负面情绪,目前正在研究如何减少此类风险。 参考链接:-ai-chatbots-conspiracies.html