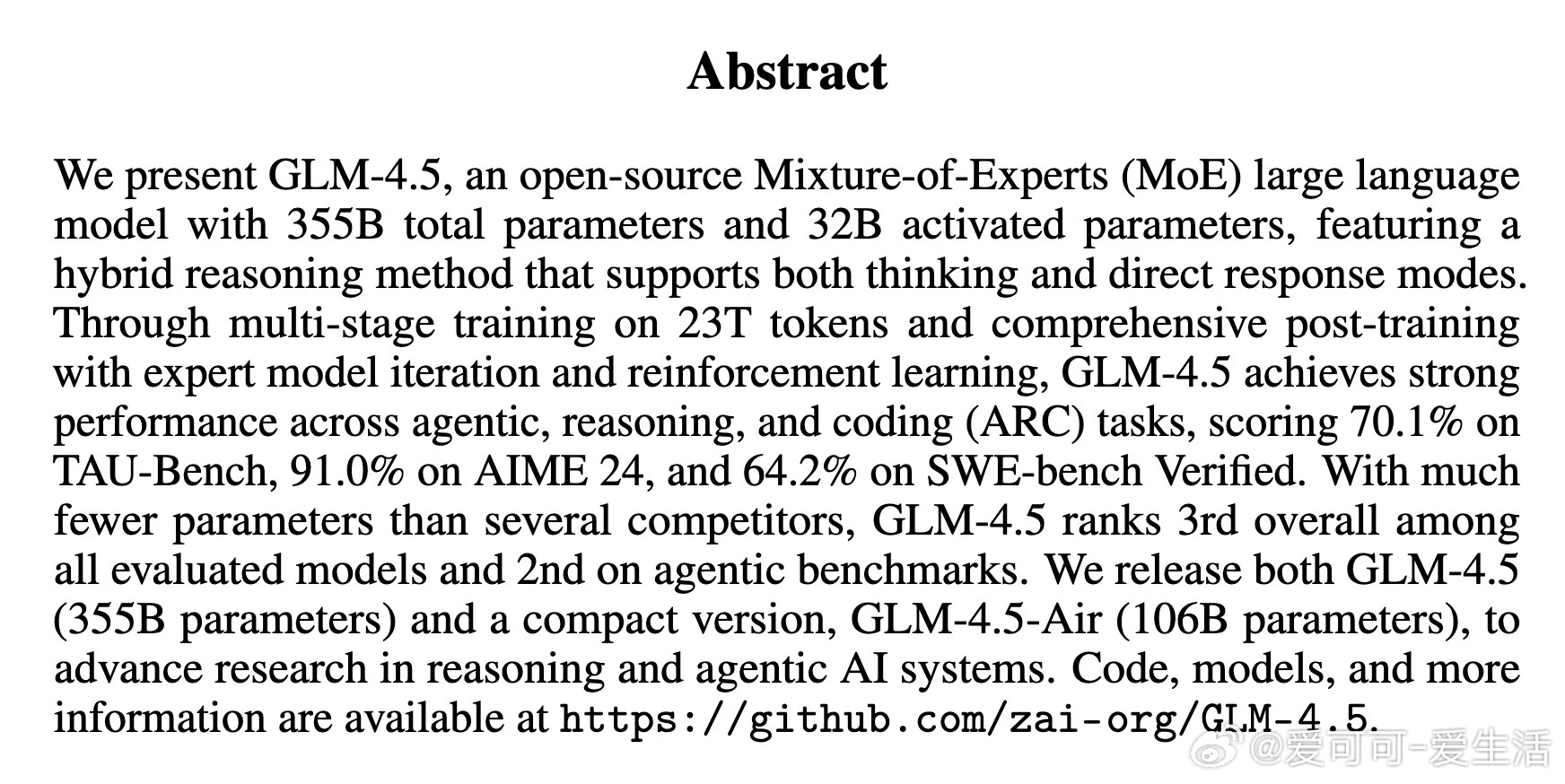

[CL]《GLM-4.5: Agentic, Reasoning, and Coding (ARC) Foundation Models》A Zeng, X Lv, Q Zheng, Z Hou... [Zhipu AI & Tsinghua University] (2025)

GLM-4.5,355亿激活参数的大规模混合专家(MoE)开源模型,展现了跨代理(agentic)、推理(reasoning)与编码(coding)的卓越能力。

• 双模式推理:支持深度思考与即时响应,适应复杂多步任务与快速交互需求。

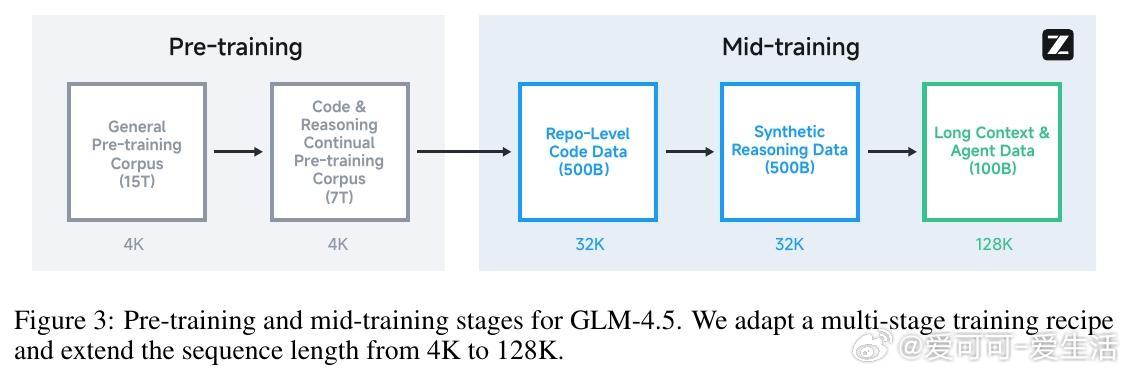

• 多阶段训练:23万亿token大规模预训练,结合专家模型迭代和强化学习,显著提升任务表现。

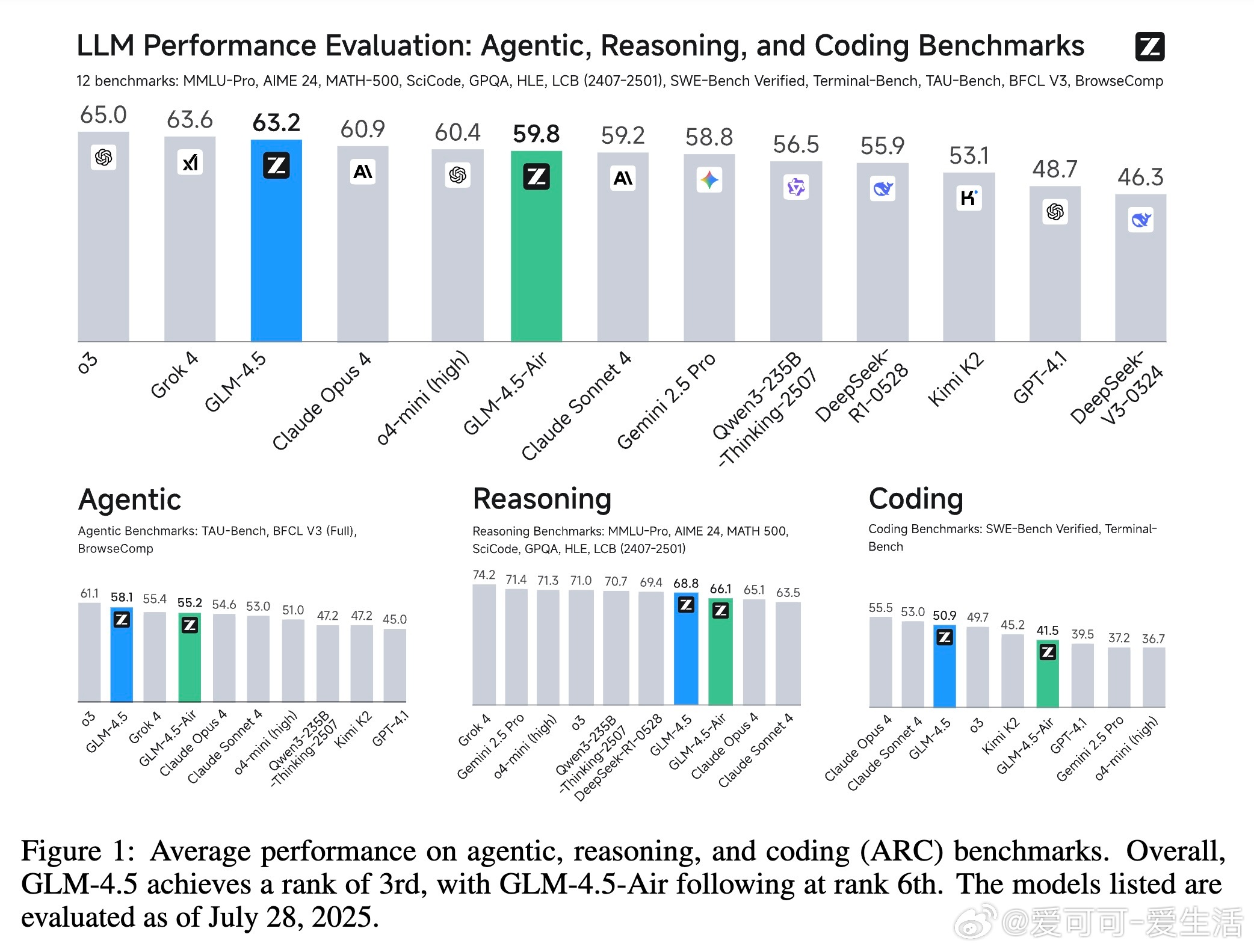

• 领先成绩:TAU-Bench得分70.1%,AIME 24达91.0%,SWE-bench Verified为64.2%,在全局排名第3,代理能力排名第2。

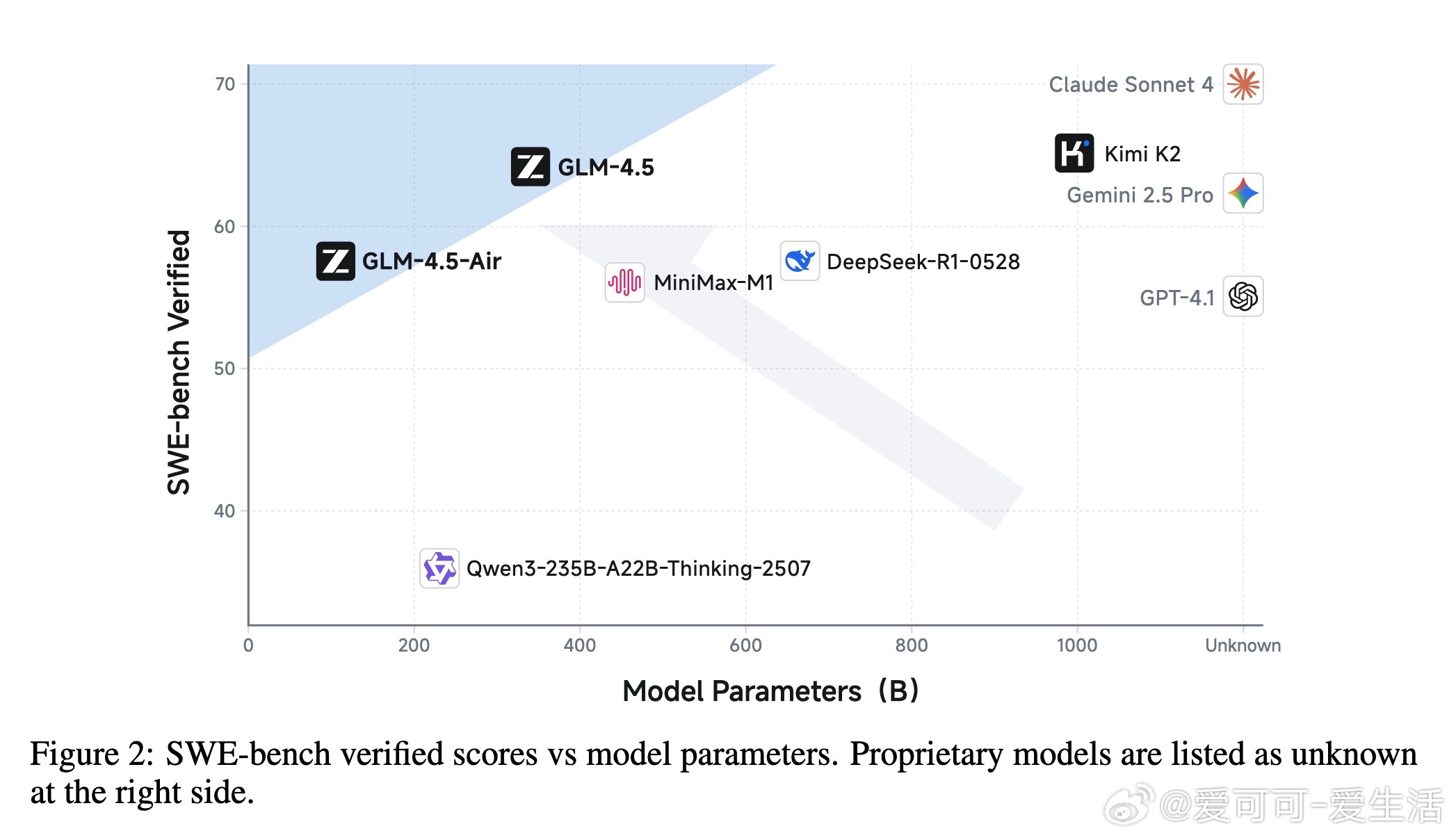

• 高效架构:355B参数中仅激活32B,参数量远低于多数竞争对手,性能却接近顶尖专有模型。

• 细粒度数据策略:网页、代码、数学与科学文档质量分层采样,专门设计多语言与代码预训练语料。

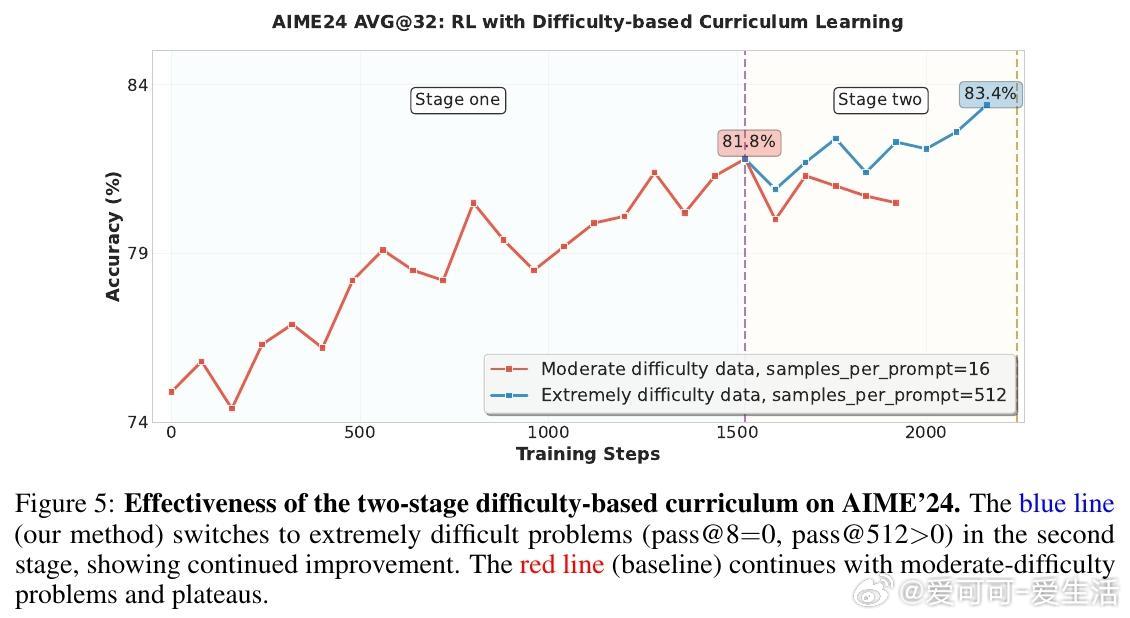

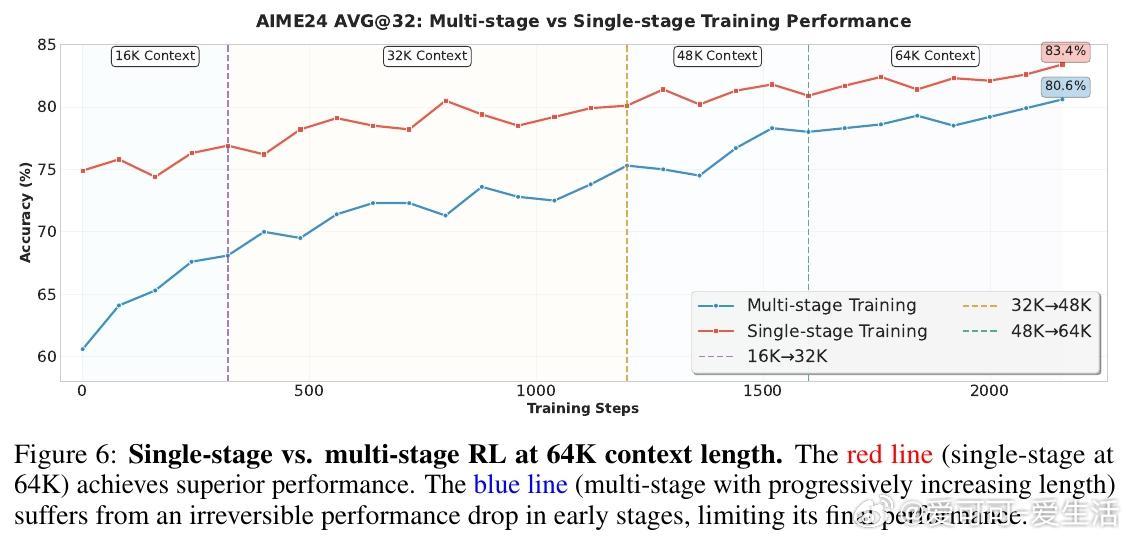

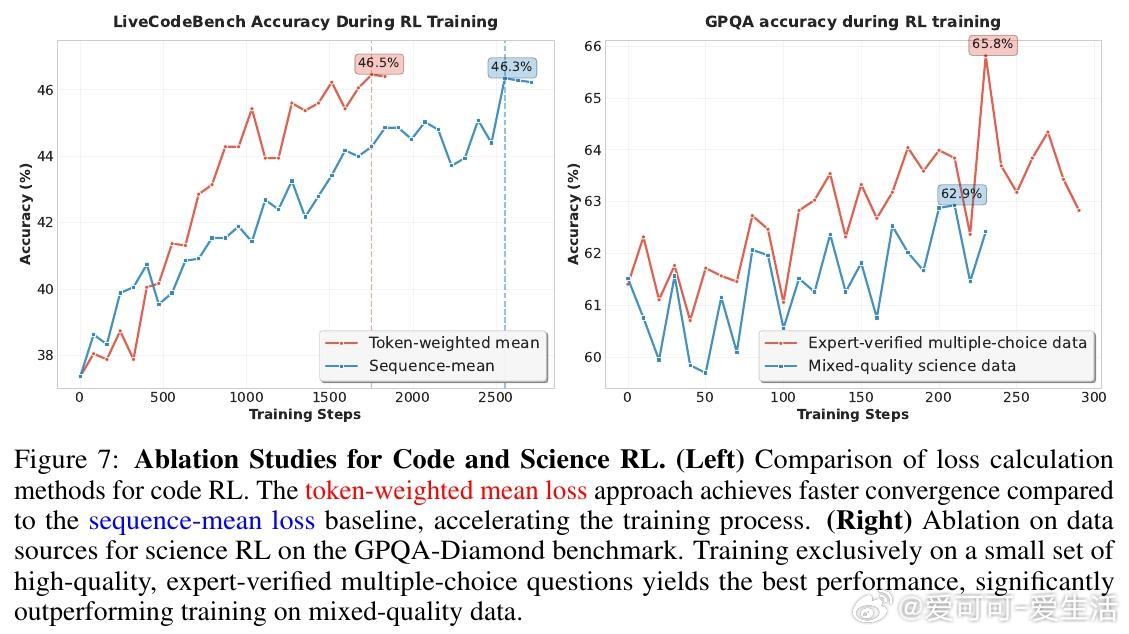

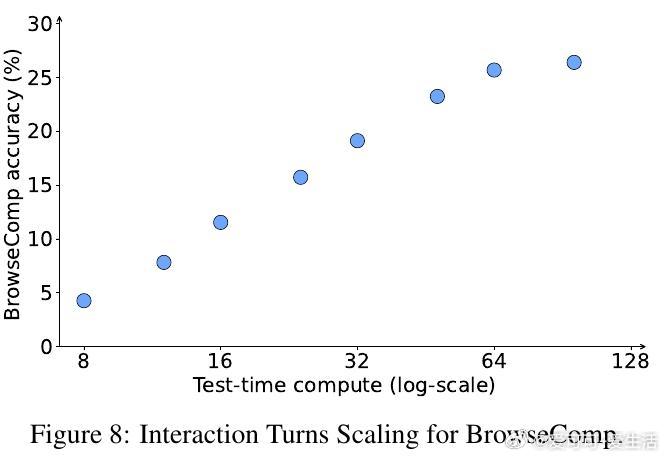

• 强化学习创新:采用难度分层课程学习,动态采样温度,端到端多轮工具调用RL,确保多任务高效训练。

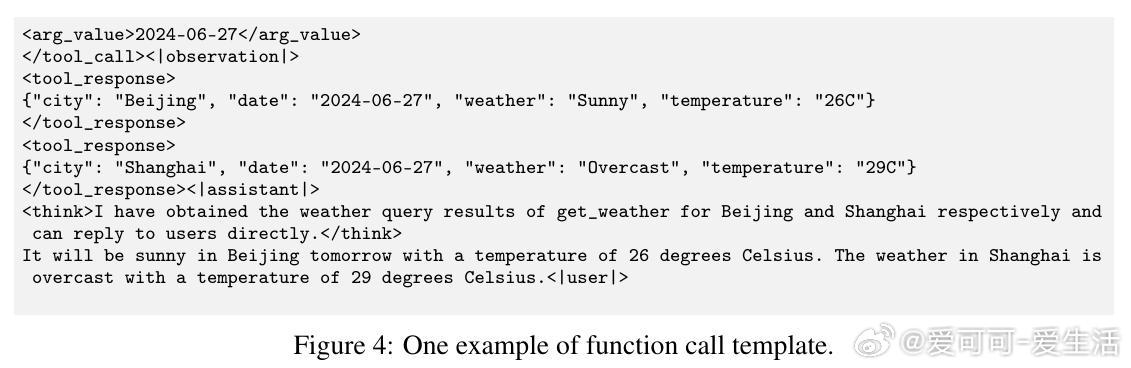

• 灵活推理与工具调用:采用XML风格函数调用模板,减少代码转义负担,提高工具调用准确性与鲁棒性。

• 实际应用评测:真实软件开发任务(CC-Bench)中优于多款开源与闭源模型,工具调用成功率达90.6%。

• 跨语言与安全性:具备语义深度理解与文化背景推断能力,安全性能高,涵盖伦理、心理健康等多维度。

• 资源开放:模型权重及评测工具开源,助力全球AI研究与应用发展。

详细信息👉

模型👉 huggingface.co/zai-org/GLM-4.5

人工智能大语言模型混合专家模型强化学习自然语言处理开源AI