[LG]《Unraveling the cognitive patterns of Large Language Models through module communities》K R Bhandari, P Chen, J Gao [Rensselaer Polytechnic Institute & IBM Research] (2025)

大语言模型(LLM)的认知模式揭示:模块社群与功能分布的网络视角

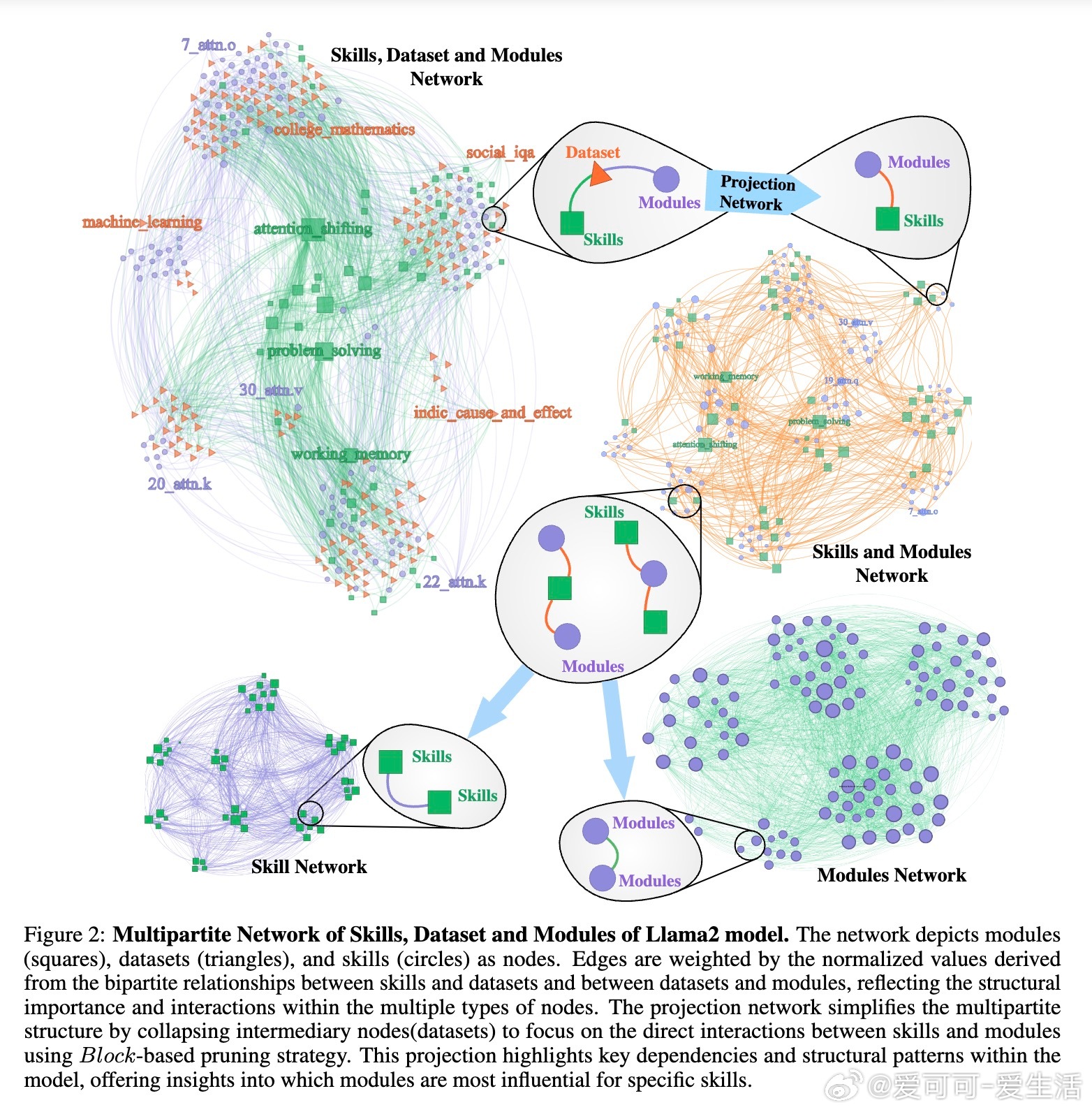

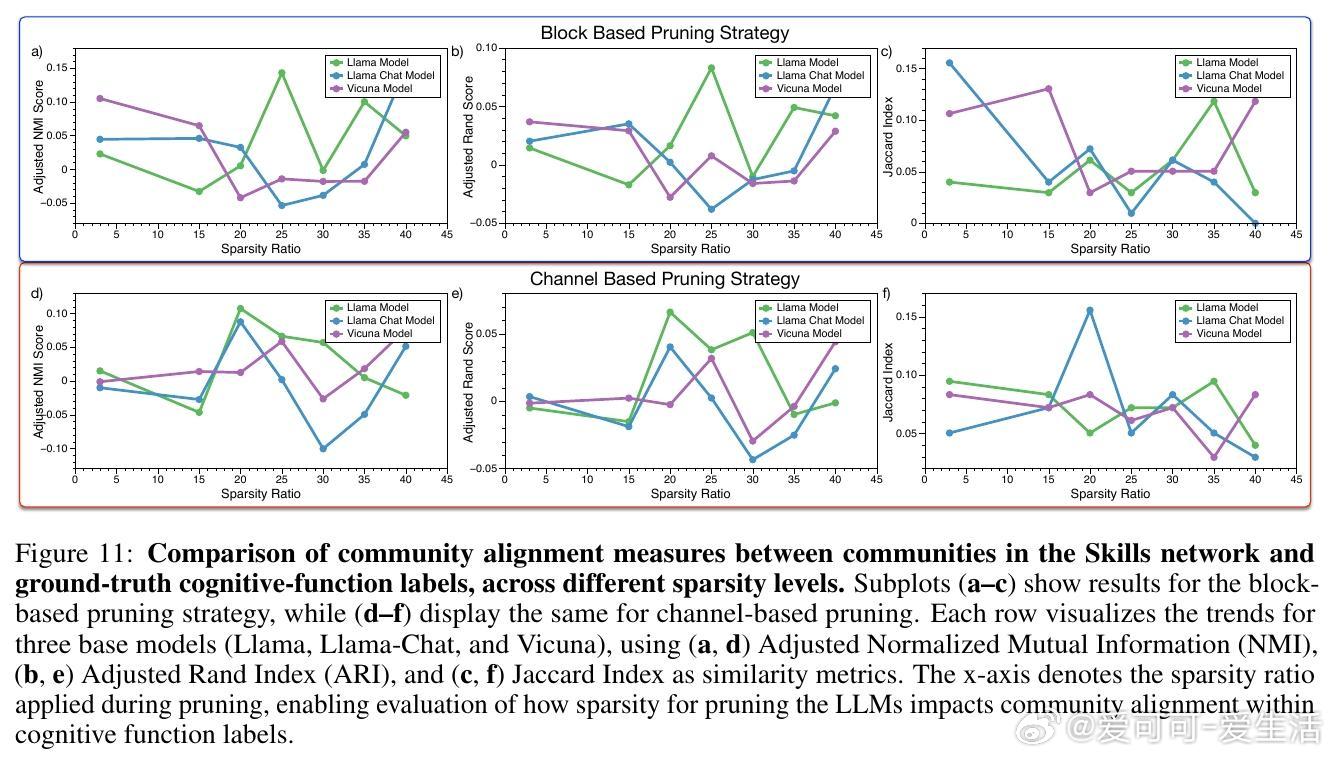

• LLM架构呈现模块化社区结构,模块群组表现出复杂的技能分布,既不同于生物脑的严格局部化,也体现了类似鸟类和小型哺乳动物脑的弱局部化特征。

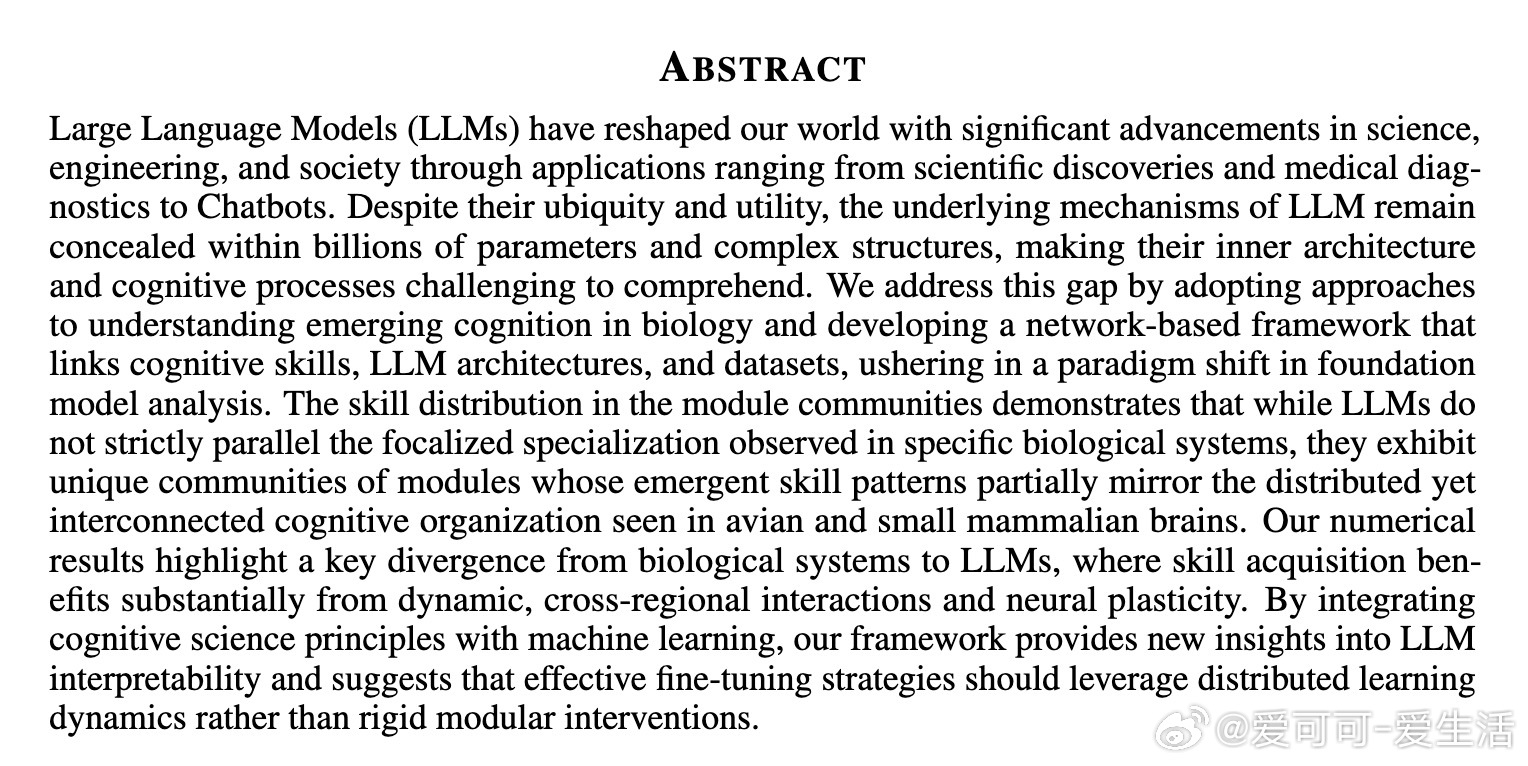

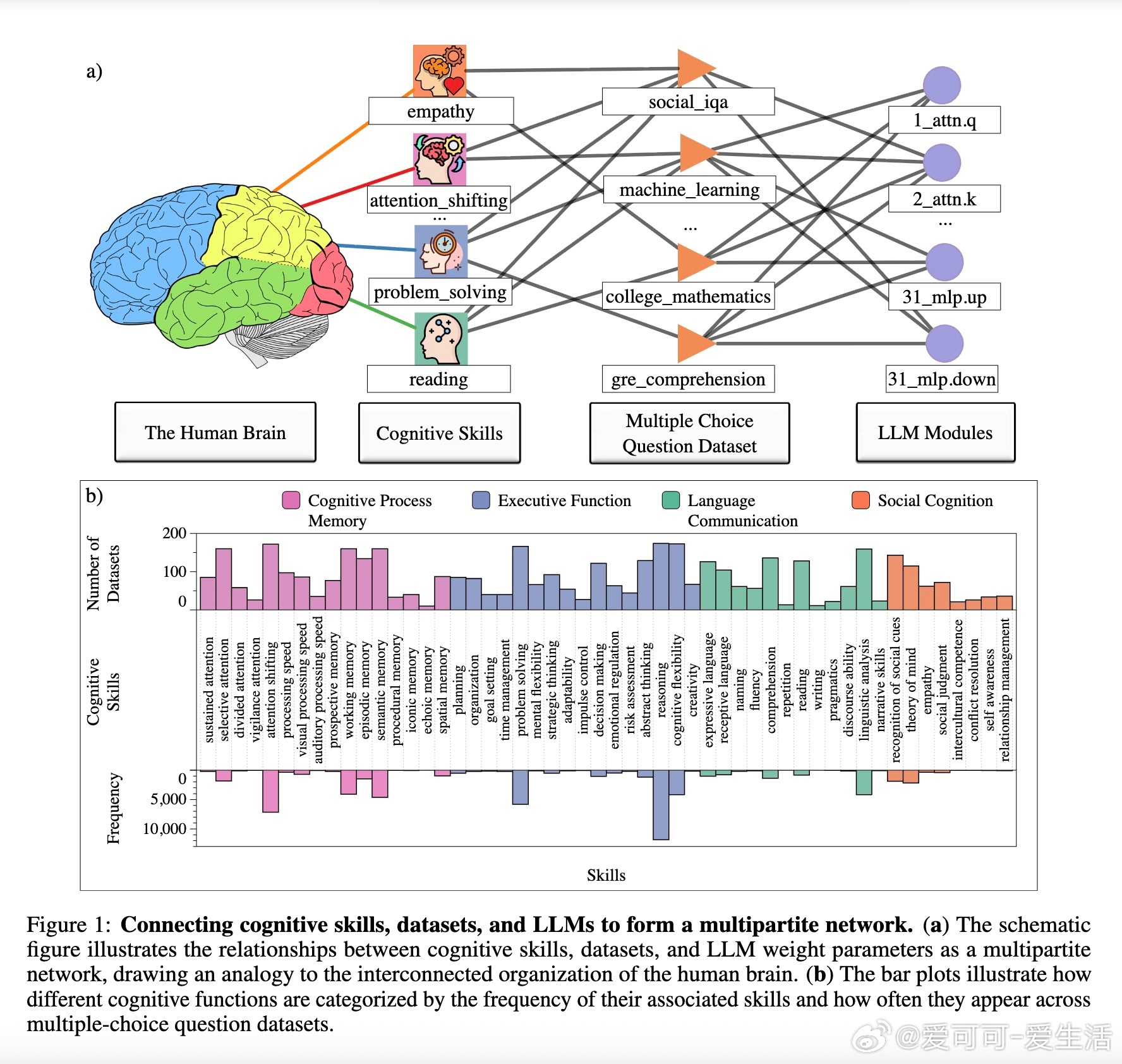

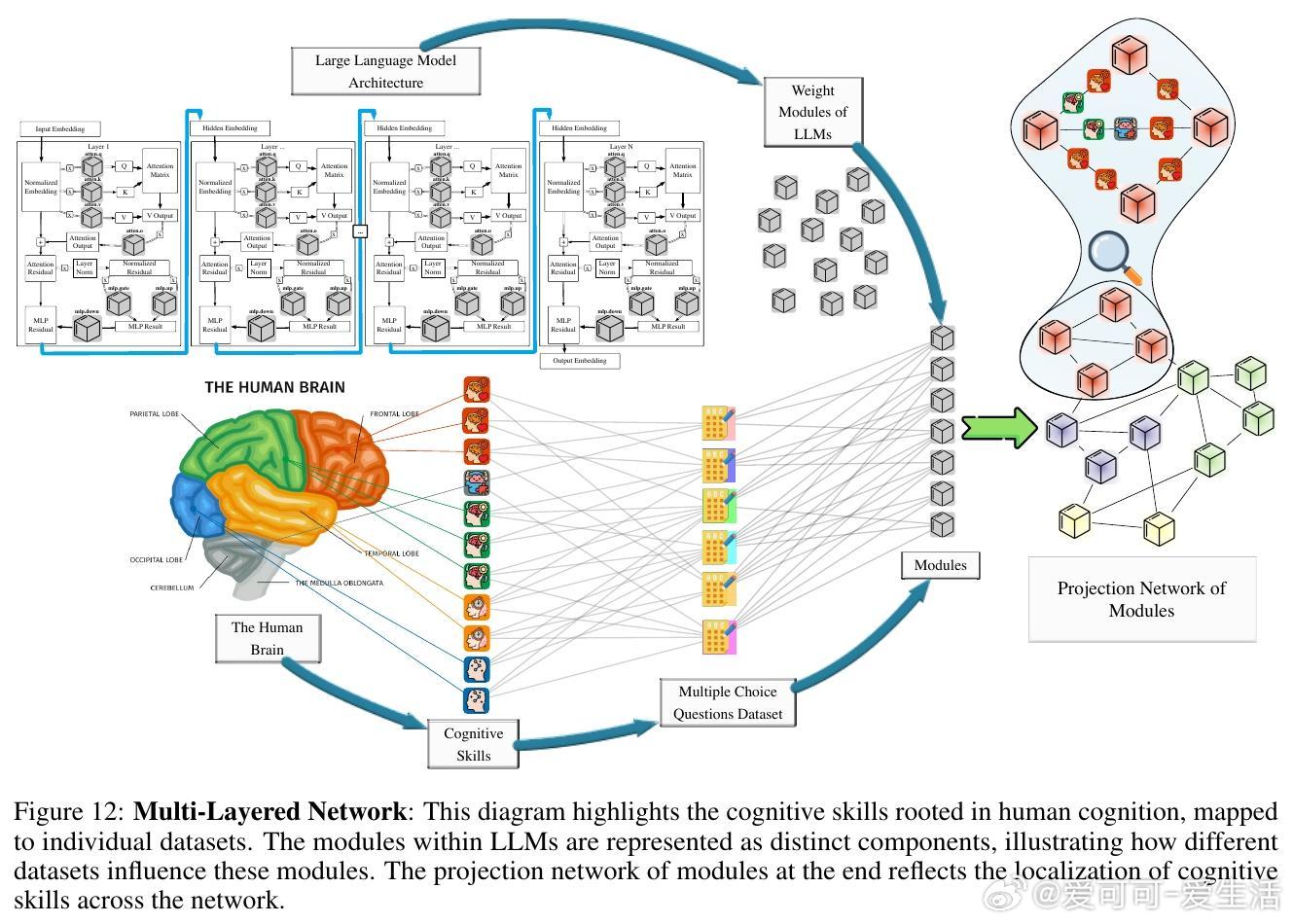

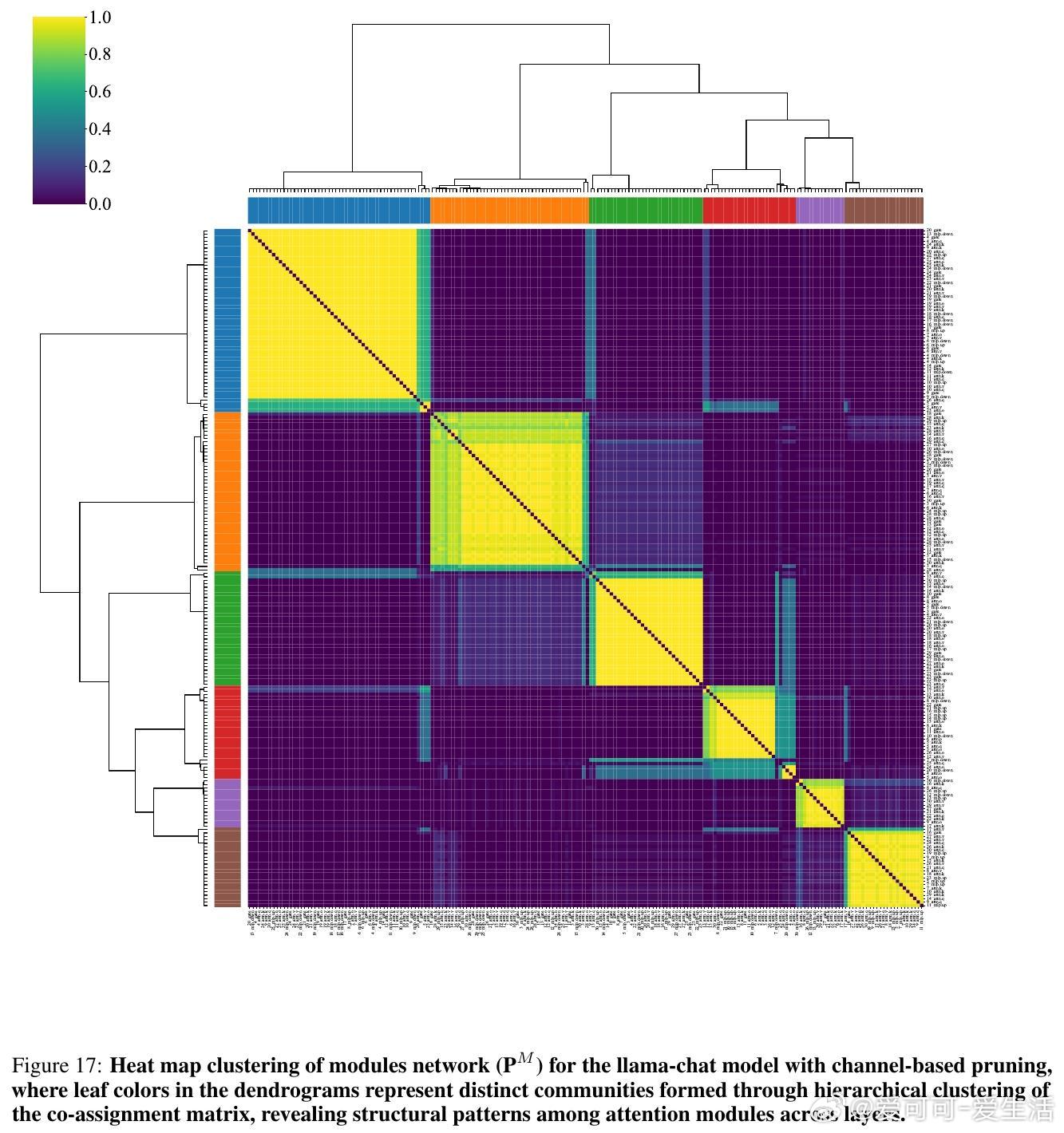

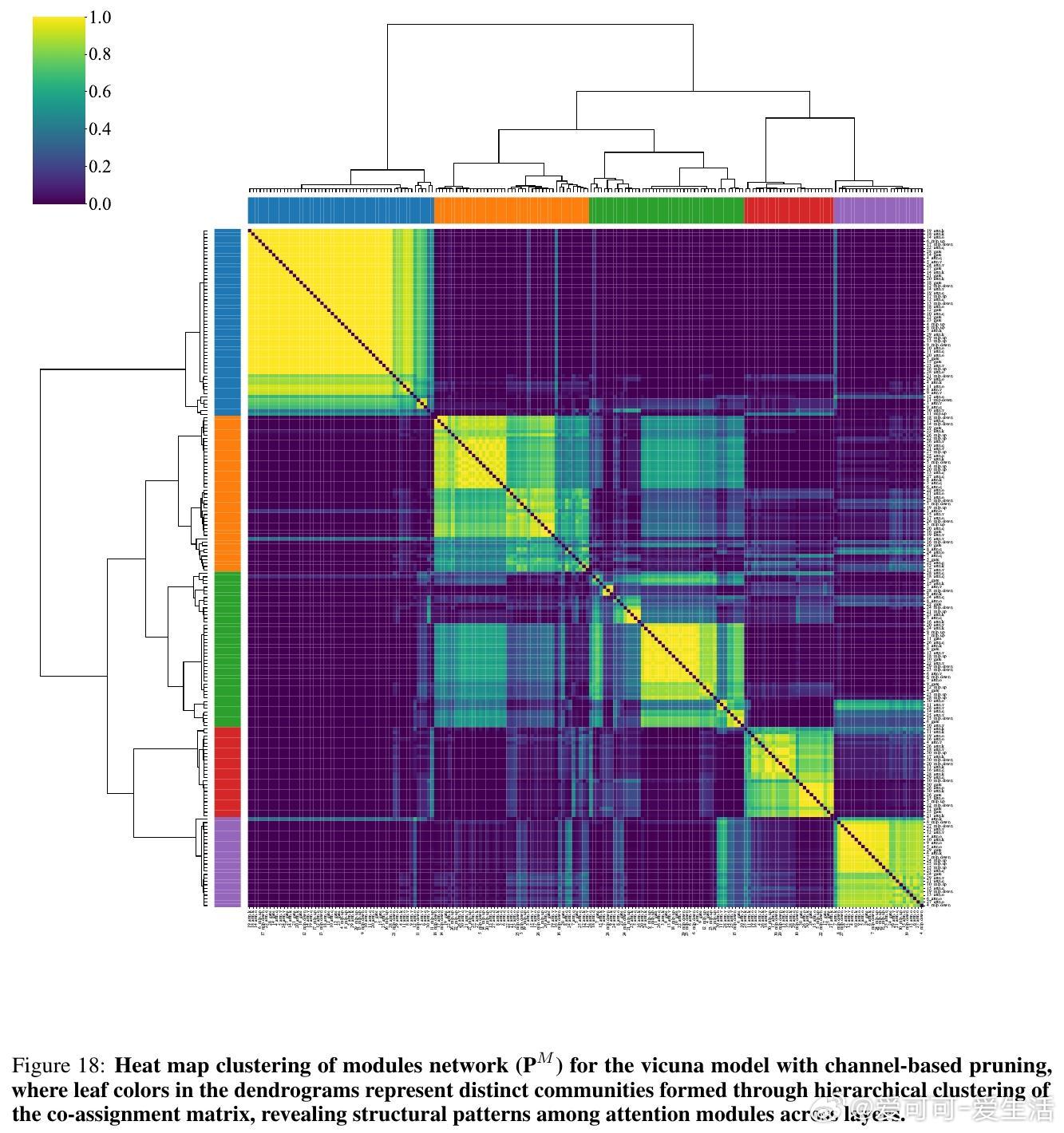

• 通过构建认知技能、数据集与模型模块的多层网络,揭示LLM内部模块如何响应不同认知技能需求,模块间既有紧密内部连接,也保持跨社区的动态交互,支持分布式学习与适应。

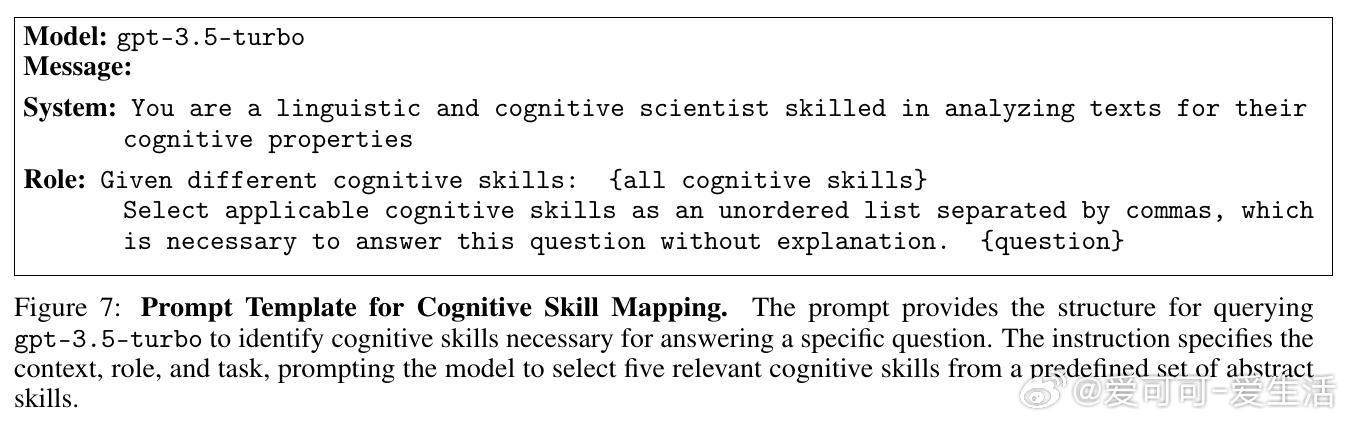

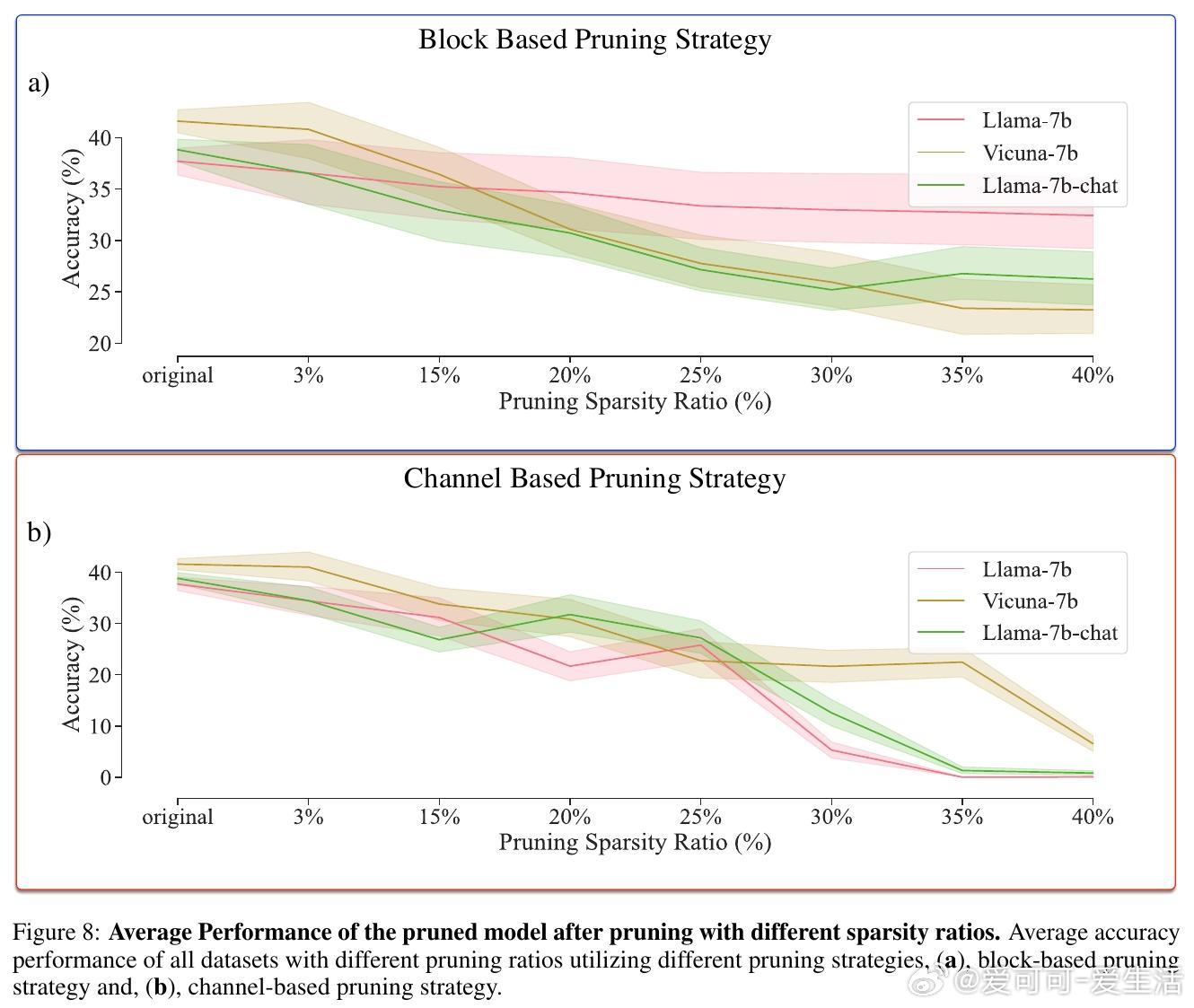

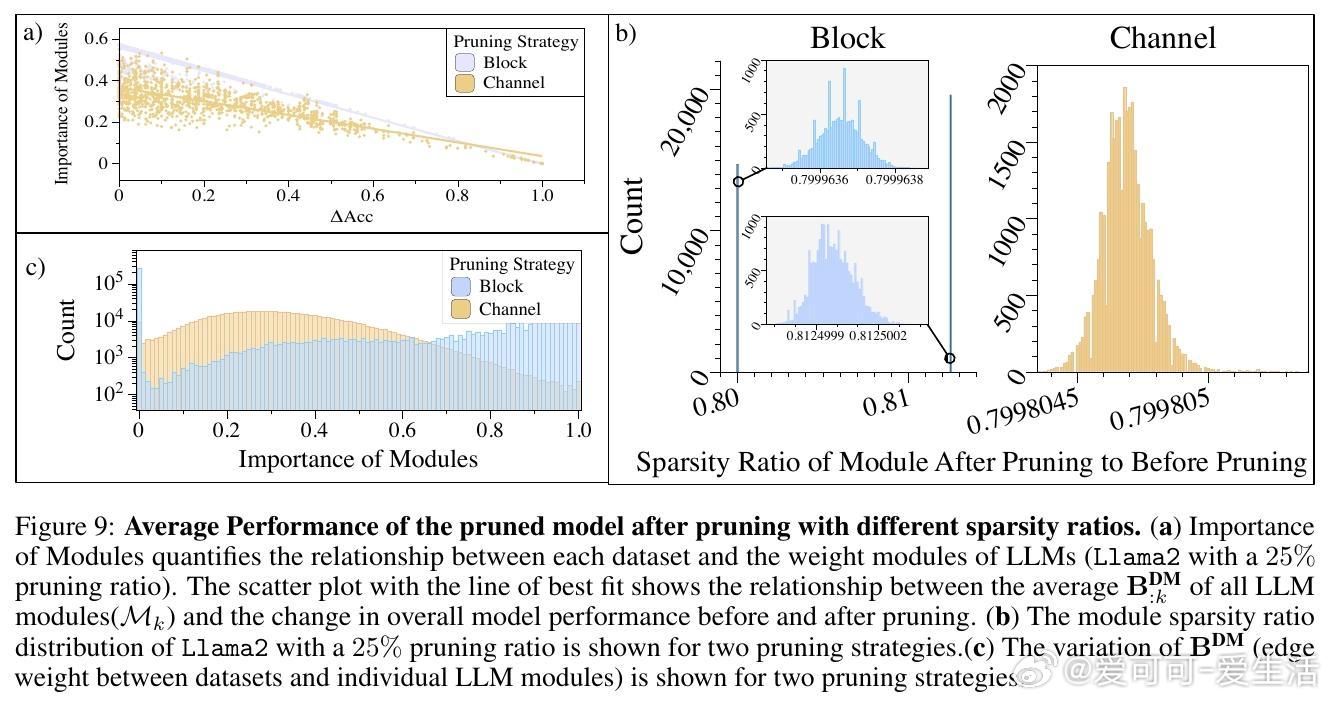

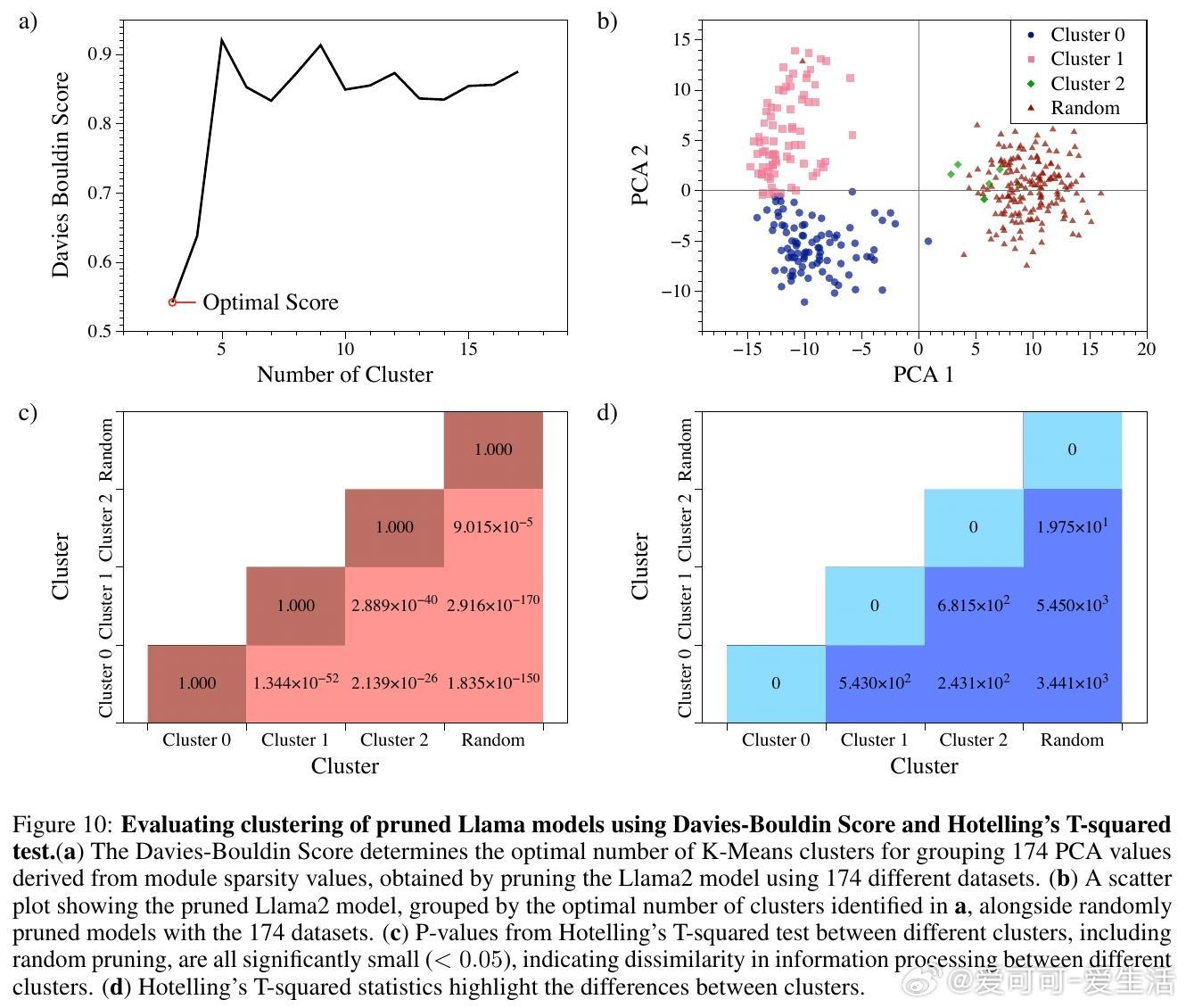

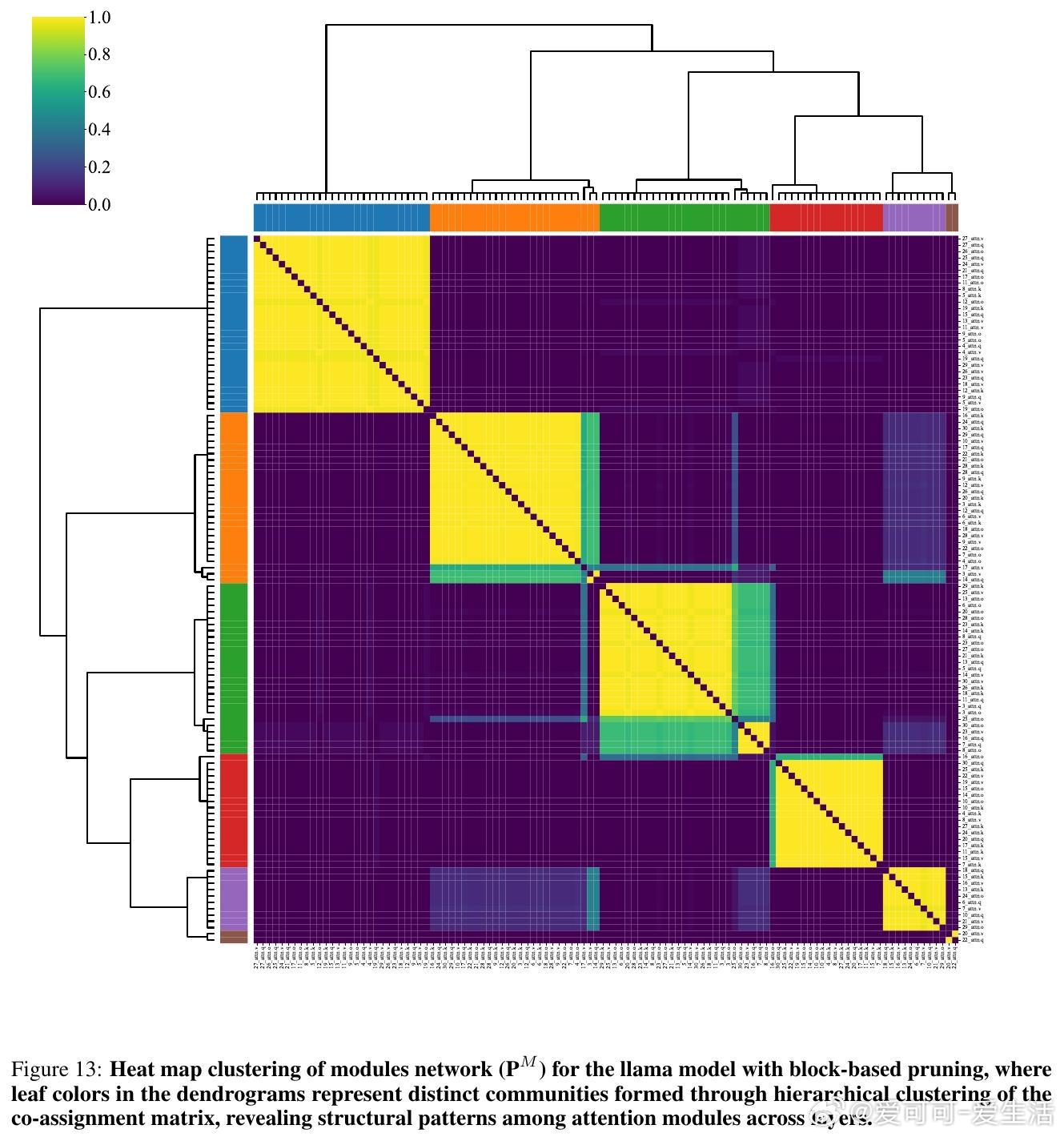

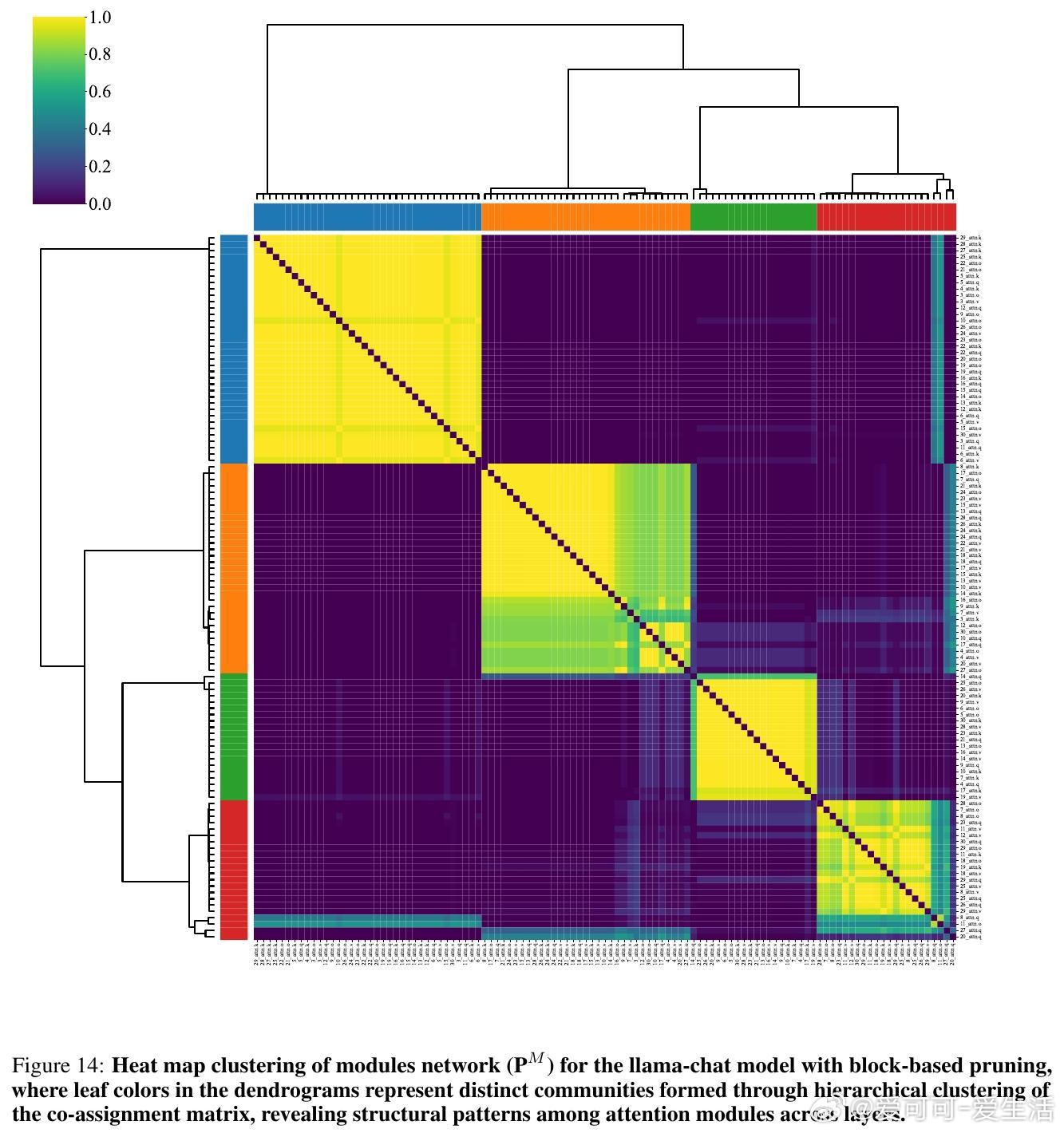

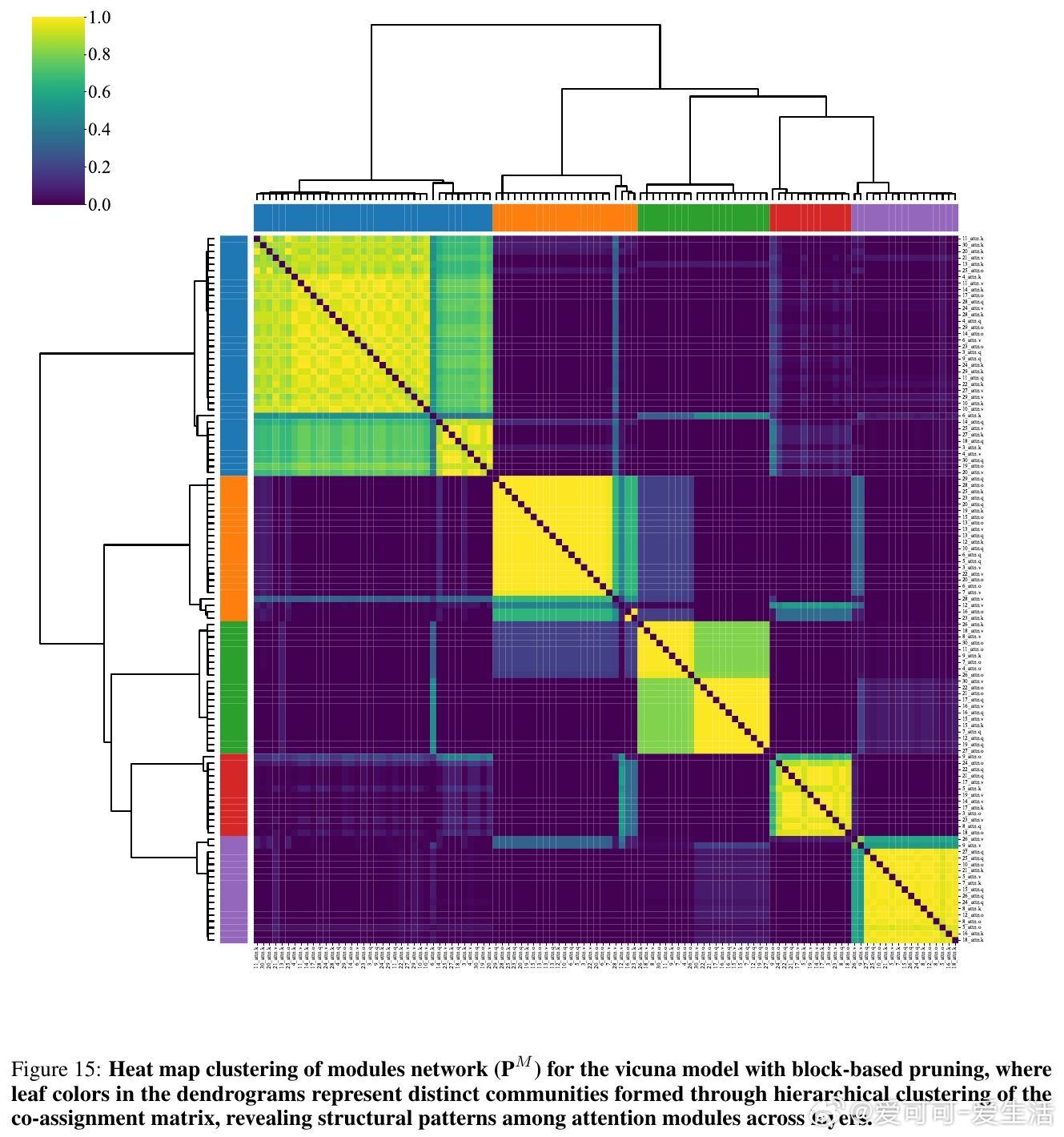

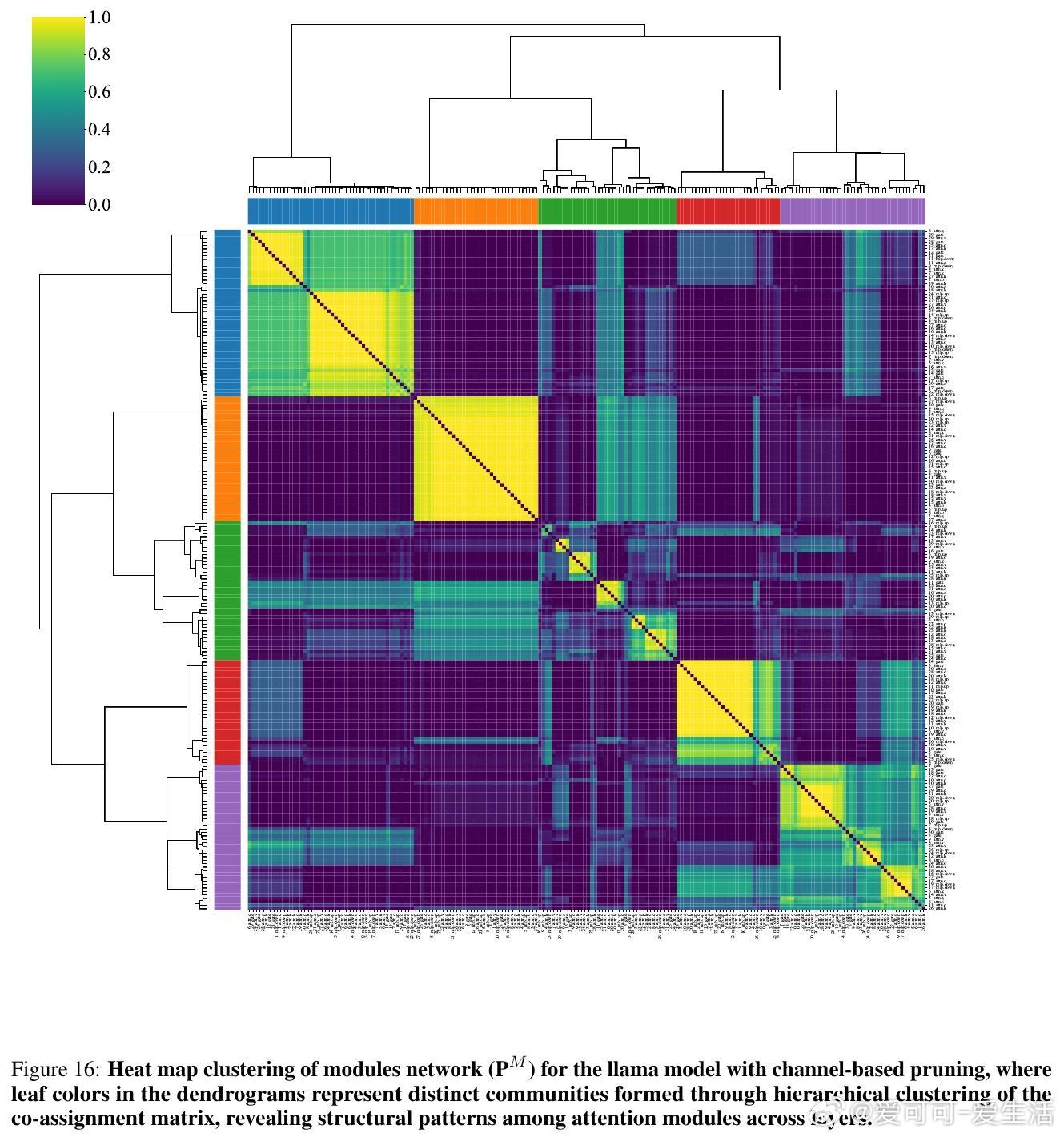

• 利用基于梯度的结构剪枝(LLM-Pruner)精确识别模型中对特定任务关键的权重模块,进而映射技能与模块间的关联,发现模块社区虽有技能相关性,却不严格对应传统认知功能分类。

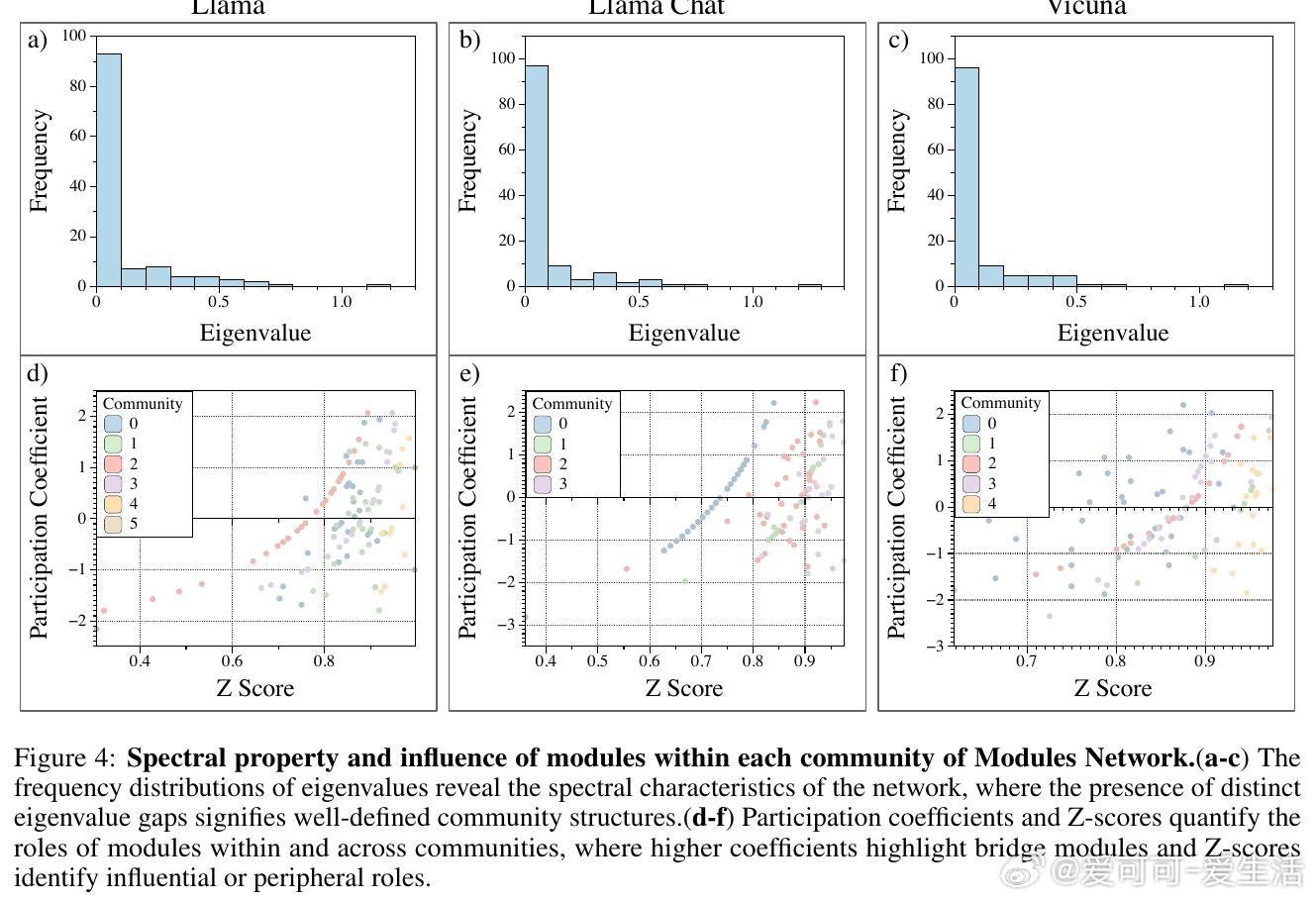

• 模块网络的谱特征、参与系数与Z分数指标揭示模块在社区内的中心性及跨社区桥梁角色,体现了类似人脑小世界网络的组织原则,兼顾功能专门化与全局整合。

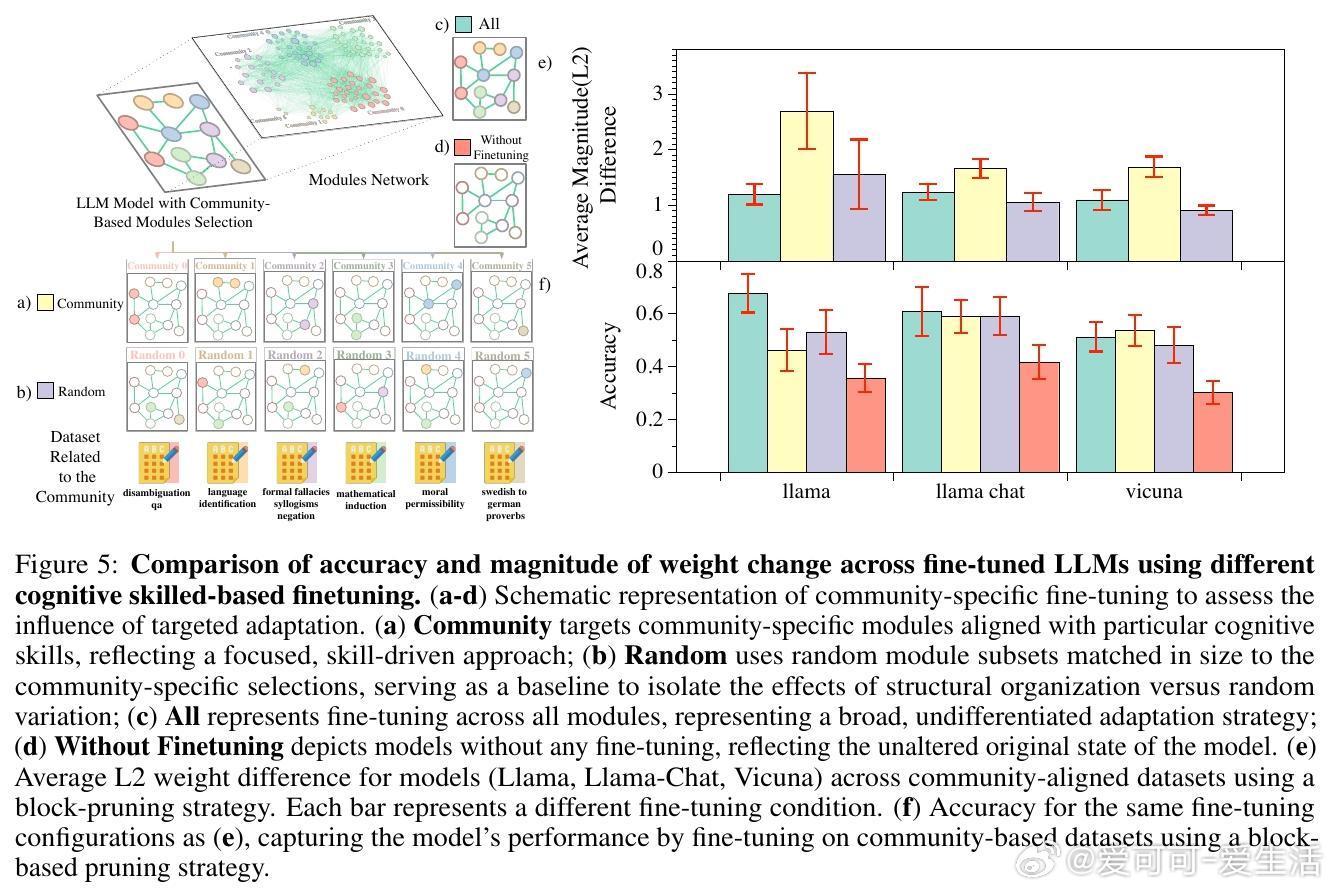

• 认知技能导向的社区微调导致模块参数显著变化,但并未带来明显准确率提升,反映LLMs认知功能的分布式编码与跨模块补偿性的学习机制,区别于人脑的高度局部化神经可塑性。

• 该研究强调未来解释性AI与微调策略应聚焦网络级依赖与层间连接,充分利用分布式学习动力学,而非简单依赖技能模块的刚性映射。

心得:

1. LLM的认知功能并非局部模块独立承载,而是依赖广泛而灵活的模块间动态协作,挑战了传统的模块专门化认知框架。

2. 模块社区结构与生物脑网络的弱局部化特征相似,提示人工智能系统的设计可借鉴自然脑的分布式整合策略以提升适应性与鲁棒性。

3. 针对模块社群的定向微调虽引发显著参数调整,但性能提升有限,说明模型知识呈现冗余编码,强调全局优化的重要性。

论文详情🔗

详细解读与开源代码🔗github.com/KBhandari11/LLMNeuron

模型权重🔗huggingface.co/KBhandari11/collections

大型语言模型认知科学神经网络模块化模型微调人工智能

![李一桐顶光的神李一桐在复制粘贴的时代,你是手写的诗[玫瑰]](http://image.uczzd.cn/12804434382834978633.jpg?id=0)