昨晚的英伟达GTC是第一次在华盛顿举办,除了投资诺基亚、和Uber研发全球最大规模无人驾驶车队以外,其实英伟达还正式发布了自己的VLA大模型,官方叫AR1,「Alpamayo-R1」。

但是GTC大会上老黄没讲这个,跑去英伟达实验室博客上下了论文,简单给大家总结下。

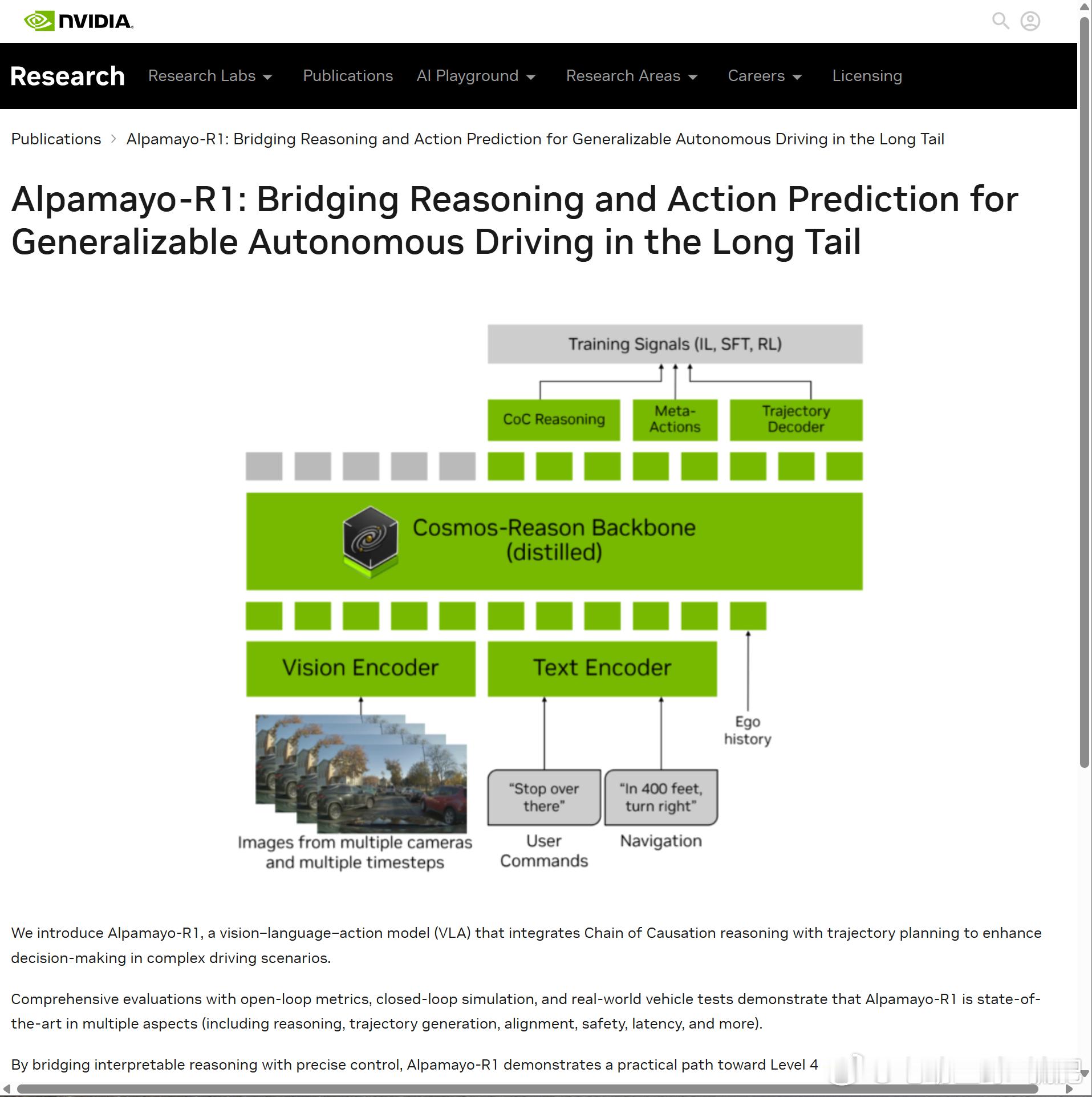

AR1其实是基于去年英伟达的VLM骨干模型Cosmos-Reason扩展而来,与其他VLA的核心区别,就在英伟达自己打的标题里面:

「Bridging Reasoning and Action Prediction for Generalizable Autonomous Driving in the Long Tail」(连接推理和动作预测,实现长尾环境下的通用自动驾驶)。

可以简单概括一下:AR1与其他VLA大模型在核心技术路线上基本趋同,但在复杂多变的「长尾」场景中,AR1用新的技术创新,全面优化了推理、轨迹生成、对齐、安全性、延迟等等方面的实际表现。

官方用词是「state-of-the-art 」(业界领先)。

效果得等实测,今天还是简单从原理方面解释一下AR1的创新之处。

先来回顾一个名词CoT,Chain of Thought 思维链,这是年初DeepSeek震惊AI界的核心名词。

由华人科学家魏学森提出的CoT,是2022年初才广泛被学术界认可的概念。CoT 让大模型自动给出推理步骤,最终让规模足够大的LLM的可解释性显著提升。

英伟达在AR1上的创新也是一个「链」,官方命名CoC(Chain of Causation 因果链)数据集。

英伟达认为,自动驾驶的有效推理必须建立在「因果关系基础之上」,并且推理本身「必须与驾驶任务保持结构对齐」。这就要求推理轨迹不能产生冗长无序的叙述,因为人类的思维本身是极低时延,且精简高效的。

而在对CoT思维链的应用中,英伟达认为思维链存在「行为描述含糊不清、表面推理、因果混淆」等等缺陷。

因而就有了AR1的CoC因果链,可以简单理解为在推理轨迹的过程中,英伟达为模型强制实施了「明确的因果结构」,而这种强制,则是由「选择关键帧」、「分隔历史与未来片段」等标注类手段构成的。

所以可以看到,因果链的前置标注工作相当重要,而由此生成的因果链数据集,最终则可以为决策学习提供清晰的监督数据。

另一个很有意思的点在于,CoC使用的大模型评估器是GPT-5。评估器本身是否影响AR1的全球化进度,这个需要进一步观察。

回到模型本身,AR1作为一个定义为「模块化VLA架构」的大模型,英伟达对其定位是「适配任何现成的VLM主干网络」。而目前AR1已经扩展到了最高7B(三档0.5/3/7B)的规模,也已经明显超出了目前各大主机厂辅助驾驶大模型4B的主流规模。

凭借着以上所有创新,最终英伟达表示,AR1在复杂场景下的轨迹规划性能提升了12%,近距离碰撞率减少25%,强化学习后训练使推理质量提升45%,推理-动作一致性增强37%。

不过,论文中英伟达还提到另外一点:AR1现阶段如果想要的车规级时延,需要在RTX A6000 ProBlackwell 级别的卡上跑推理。

而这张卡的 INT8 算力高达4000T,是Thor-U的6倍左右[允悲]

虽然但是,AR1 的诞生意味着英伟达的车规级软硬一体战略迈出了重要的一步,从10年前纯粹的芯片供应商,跃升为芯片、模型、训练服务器完整闭环,现阶段全球唯一的供应商。