[LG]《Adaptive LLM Routing under Budget Constraints》P Panda, R Magazine, C Devaguptapu, S Takemori... [Fujitsu Research] (2025)

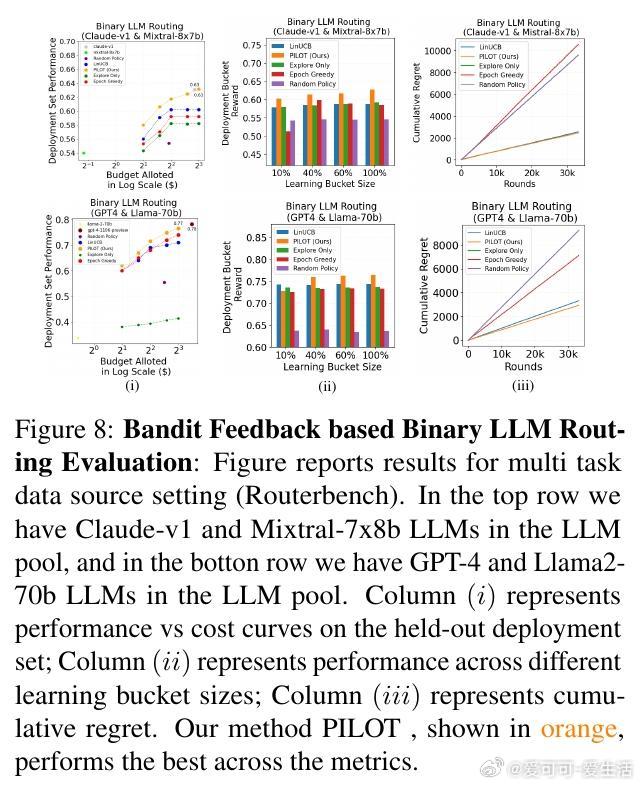

大规模语言模型(LLM)路由面临性能与成本的关键权衡,PILOT算法提出了一种基于偏好先验的自适应上下文Bandit方案,显著提升实际部署效率。

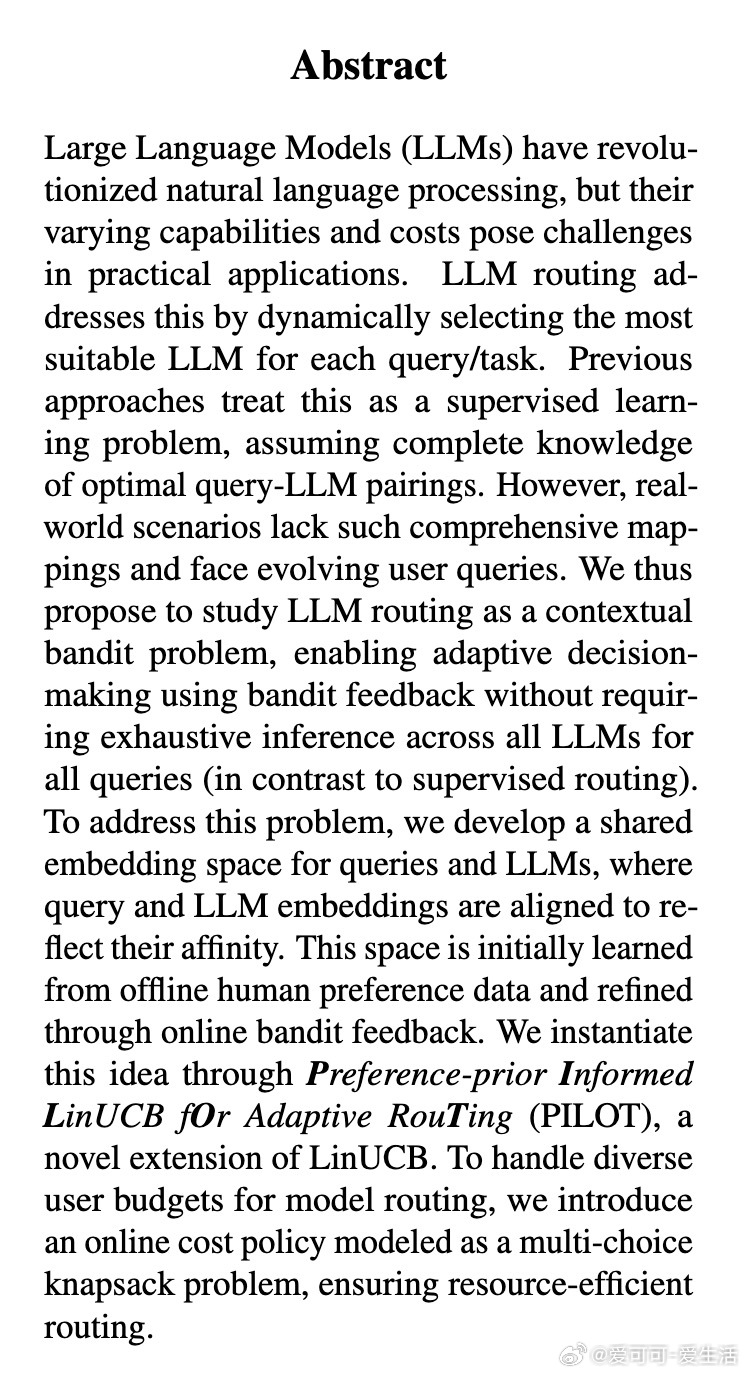

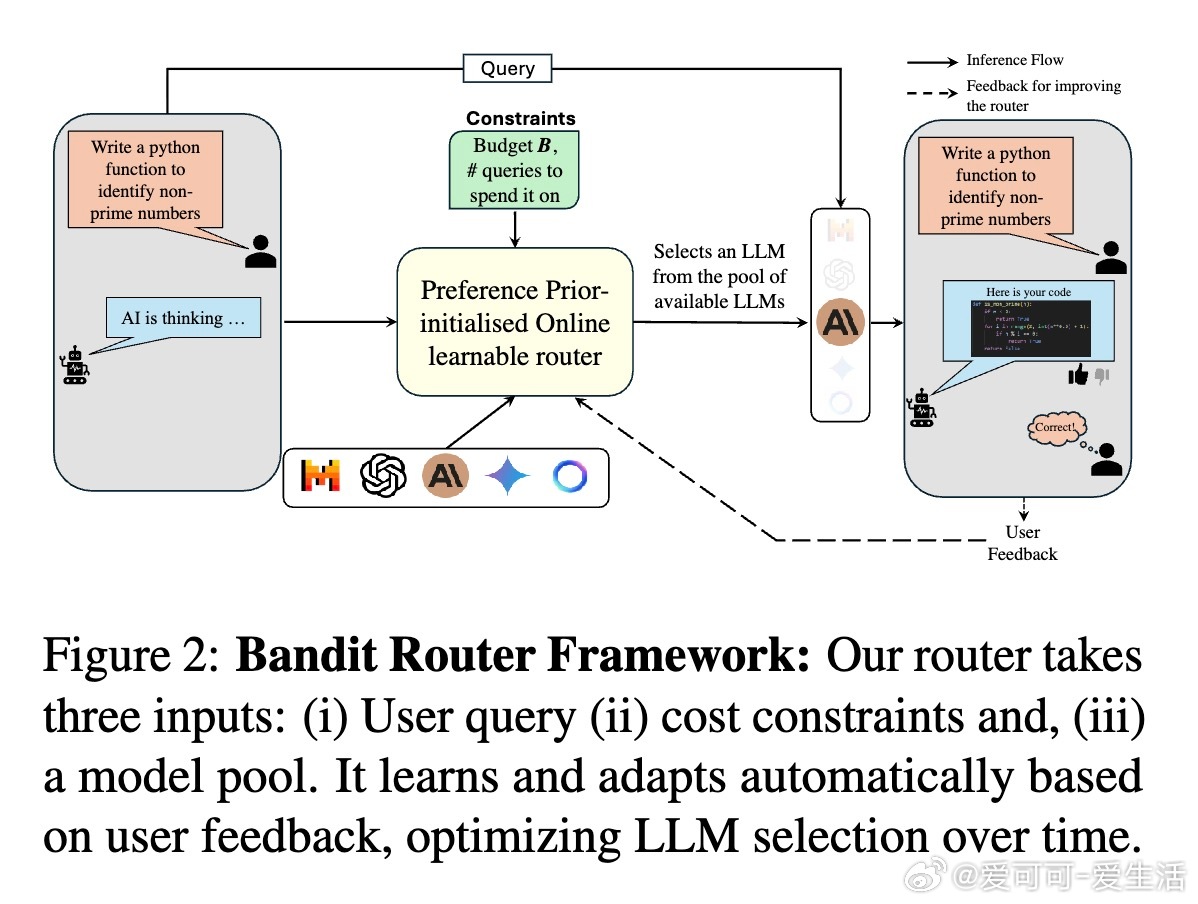

• 将LLM路由问题建模为带预算约束的上下文多臂Bandit,利用有限的评估反馈(点赞/点踩)实现在线学习,无需全模型推理。

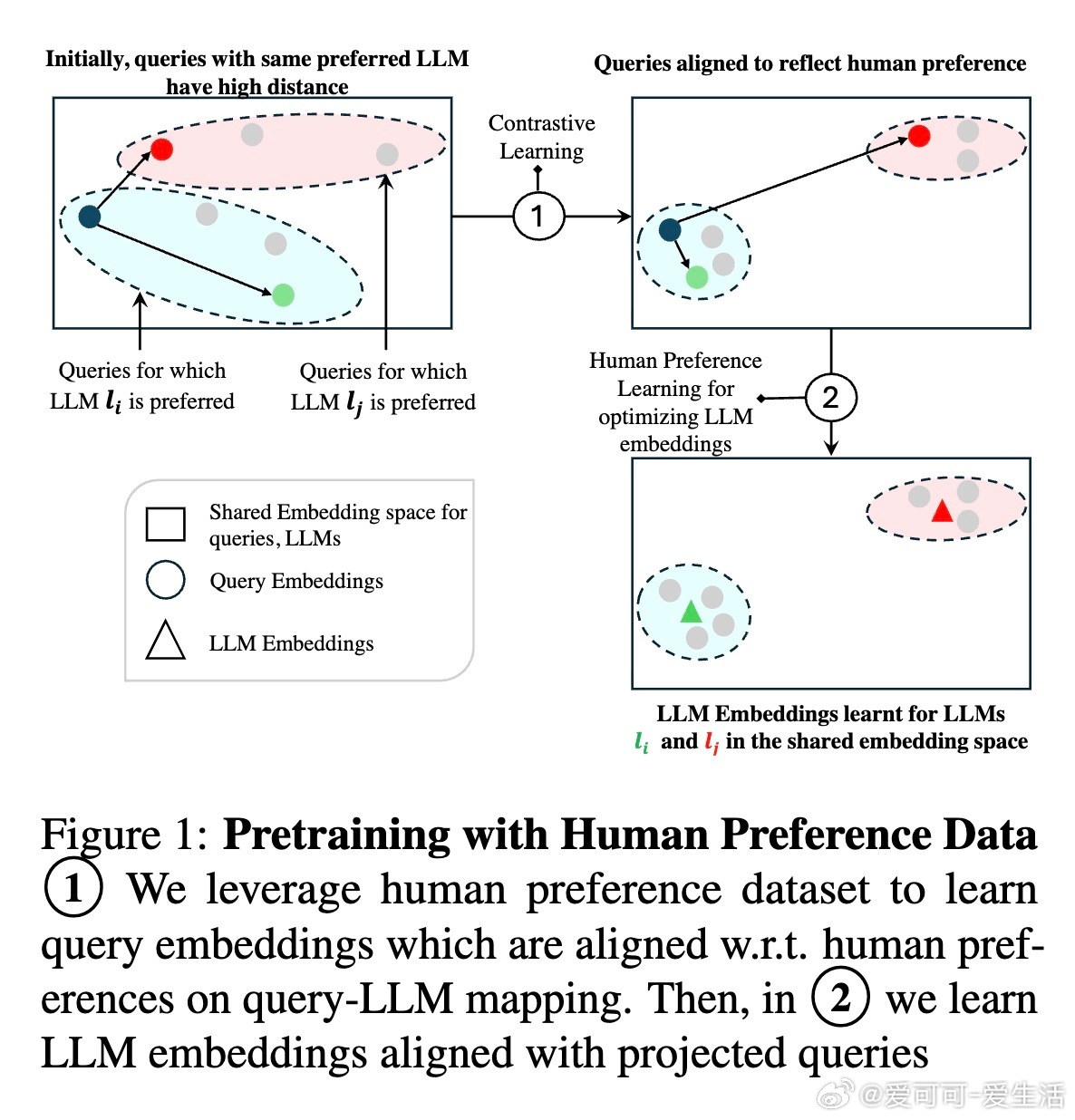

• 创新设计共享嵌入空间,联合预训练人类偏好数据和在线反馈,动态捕捉查询与模型匹配度,提升路由决策准确性。

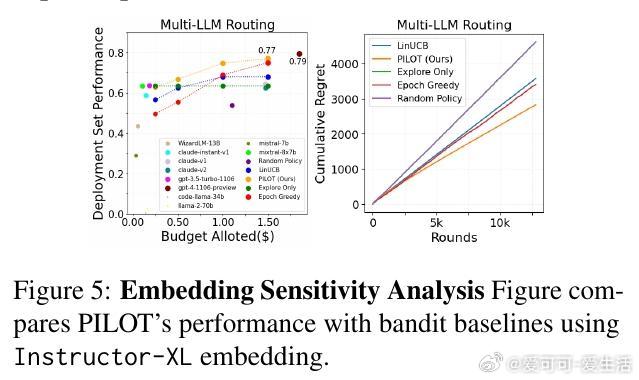

• PILOT算法基于LinUCB框架,融合人类偏好先验,理论证明累积遗憾下界优于标准方法,兼顾探索与利用。

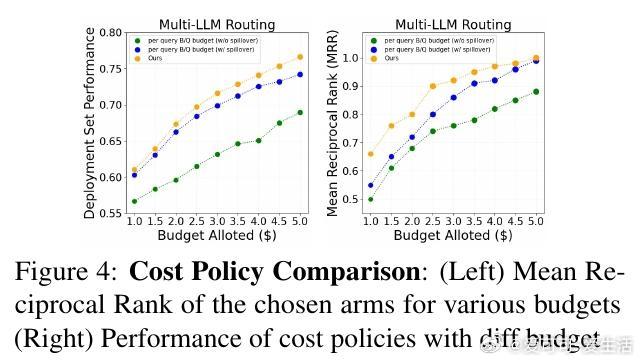

• 引入基于在线多选背包问题的成本策略,实现预算内的资源动态分配,确保整体成本控制同时性能最大化。

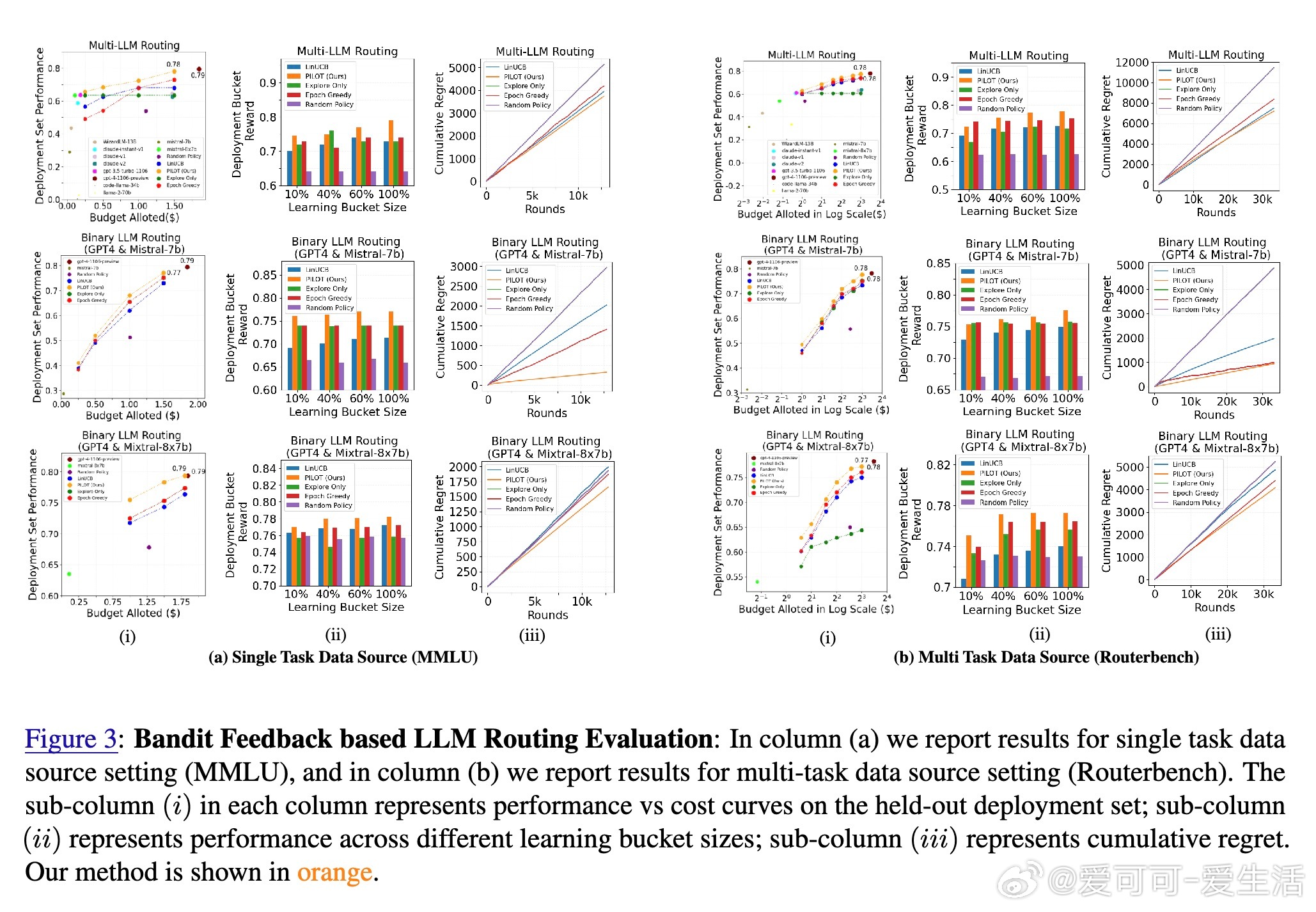

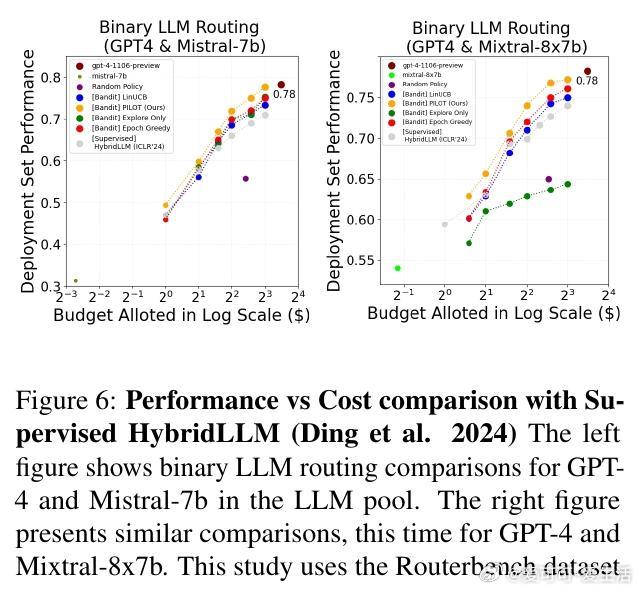

• 实验覆盖Routerbench多任务数据集,11款开源及商用LLM,达到GPT-4性能的93%仅需其25%成本,显著优于多种基线及监督式路由方法。

• 路由决策体现对任务复杂度敏感,如复杂推理任务优先调用GPT-4,数学任务偏好Claude模型,编码任务合理分配,体现智能调度。

• 路由计算开销远低于大模型推理时间,嵌入模型替换后依然保持强鲁棒性,适配不同嵌入器。

• 在线成本策略优于固定预算及离线优化方案,动态调整预算分配更灵活高效。

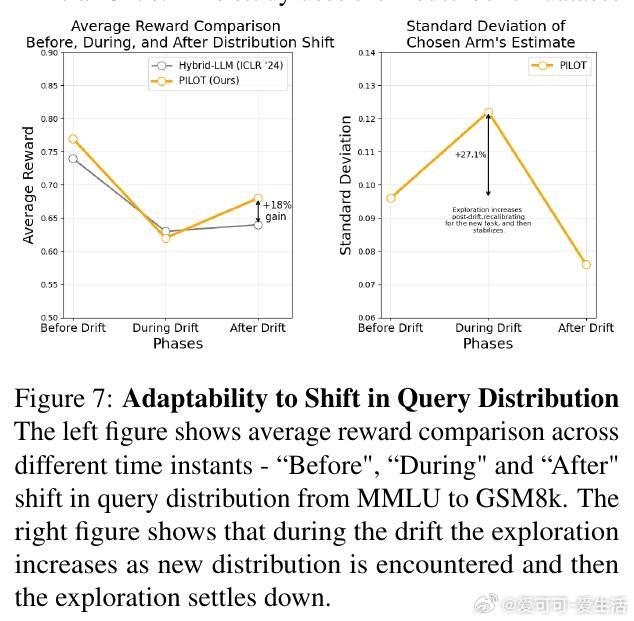

• 适应查询分布漂移能力强,在线探索随分布变化自适应调整,保持高性能。

心得:

1. 利用有限反馈优化多模型选择,避免高昂数据标注及推理成本,具备极高实用价值。

2. 共享嵌入空间有效桥接查询与模型特征,实现高效且动态的模型匹配。

3. 结合理论保证的Bandit算法与成本优化策略,为实际多模型系统提供了稳健且经济的部署方案。

详情🔗 arxiv.org/abs/2508.21141

大规模语言模型上下文Bandit模型路由成本优化在线学习机器学习理论