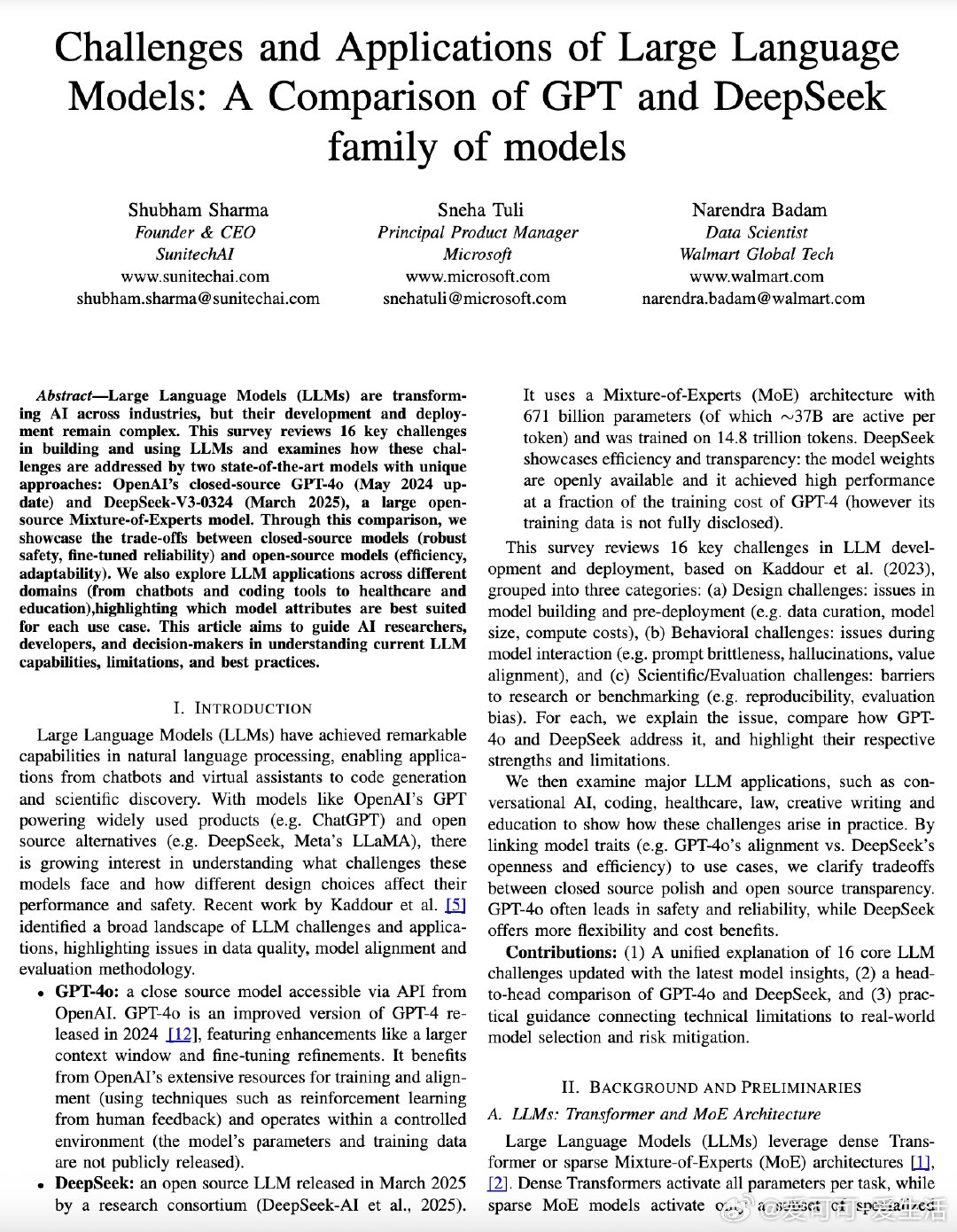

大型语言模型(LLM)发展与应用的挑战与对比:GPT-4o与DeepSeek深度解析

• GPT-4o(2024年5月更新):闭源密集型Transformer架构,数百亿参数,128K超长上下文窗口,多模态输入(文本+图像+音频),强化学习人类反馈(RLHF)深度对齐,安全性高,响应速度快且成本较低,适合安全关键和用户交互场景。

• DeepSeek-V3-0324(2025年3月发布):开源稀疏Mixture-of-Experts架构,6710亿参数(激活约37B/次),14.8万亿训练token,采用多头潜在注意力(MLA)、FP8训练、并行多token预测,训练成本极低(约600万美元),高度可定制和透明,擅长数学推理及编程任务,适合企业内部部署和研究实验。

• 16项核心挑战全面对比:数据质量与透明度、tokenizer设计、训练与推理效率、上下文管理、提示词敏感性、幻觉率、行为对齐、安全防护、知识更新机制、评估方法的稳健性与可重复性等,揭示闭源模型的安全稳定与开源模型的灵活高效的本质权衡。

• 应用领域指引:GPT-4o适合对安全性和准确性要求极高的聊天机器人、创意写作、医疗法律咨询及教育辅导;DeepSeek更适合代码生成、数学推理、企业内网部署及科研定制,可作为GPT-4o的补充或备用方案。

• 未来趋势预测:闭源与开源技术互相借鉴,混合多专家系统崛起,持续动态评估机制取代静态基准,推动更安全、更高效、更开放的人工智能生态构建。

心得:

1. 安全与透明往往难以兼得,闭源模型通过强大对齐机制保障安全,开源模型则以开放性和成本优势赋能创新和定制。

2. 模型选择应基于场景权衡风险与控制,消费者产品宜选闭源以降低误用风险,企业与研究则可借助开源灵活性和透明度。

3. 长上下文处理与推理能力的提升,是LLM实用性跨越式发展的关键,GPT-4o在实际表现中更胜一筹,彰显架构与训练细节决定成败。

详见🔗arxiv.org/abs/2508.21377

大型语言模型 GPT4o DeepSeek 人工智能 开源AI 模型对比 AI安全 机器学习